Introdução geral

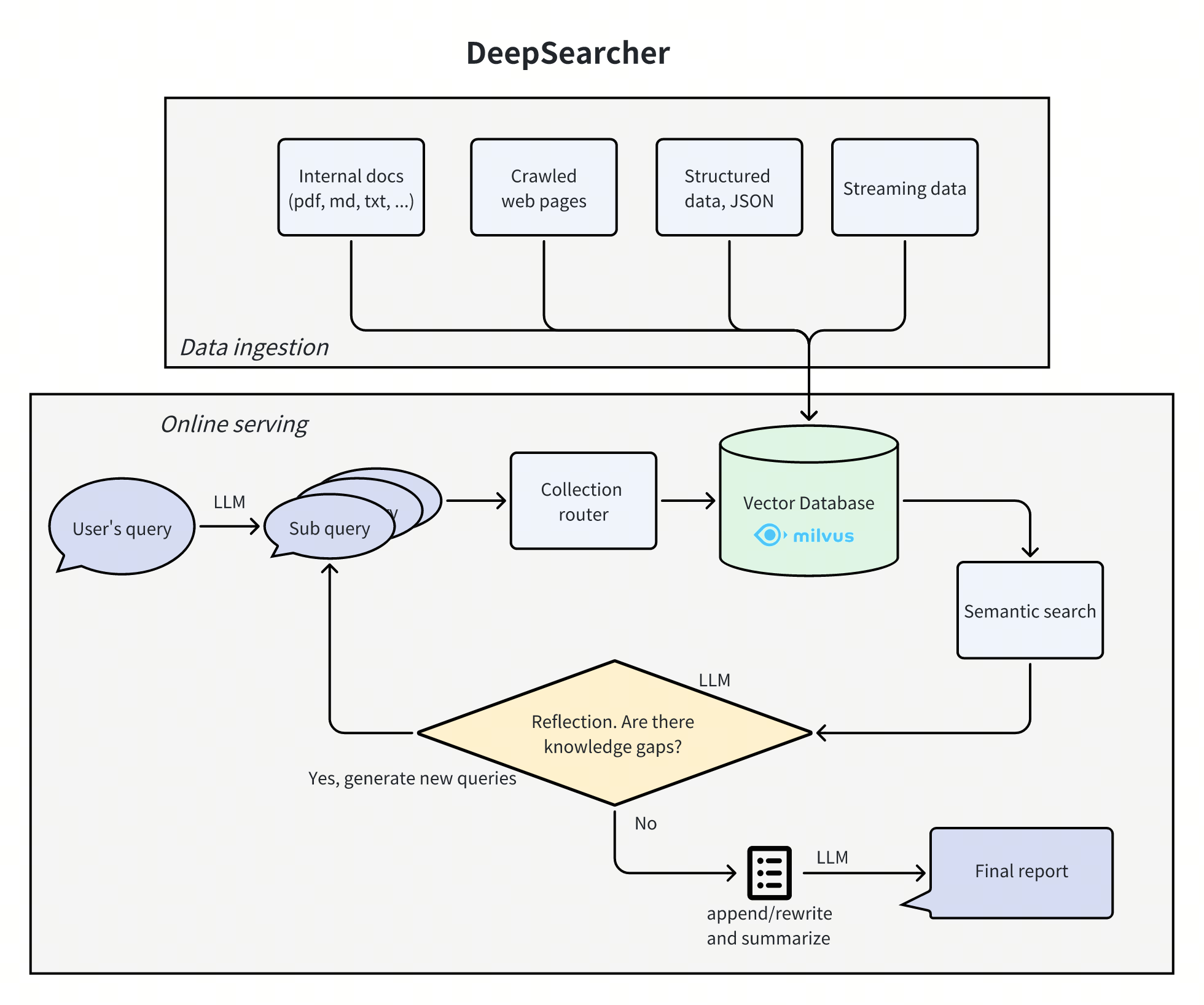

O Deep Searcher é uma combinação de modelos de linguagem grandes e avançados (como o DeepSeek O Deep Searcher suporta uma ampla variedade de modelos de incorporação e grandes modelos de linguagem e é capaz de gerenciar bancos de dados vetoriais para garantir a recuperação eficiente de informações. O projeto é adequado para gerenciamento de conhecimento empresarial, sistemas inteligentes de perguntas e respostas e cenários de recuperação de informações. O Deep Searcher oferece suporte a uma ampla variedade de modelos de incorporação e modelos de linguagem grandes, e é capaz de gerenciar bancos de dados vetoriais para garantir a recuperação eficiente e o uso seguro dos dados.

Lista de funções

- Pesquisa de dados privadosMaximizar o uso de dados na empresa e garantir a segurança dos dados.

- Gerenciamento de banco de dados vetorialSuporte para bancos de dados vetoriais, como o Milvus, que permite o particionamento de dados para uma recuperação mais eficiente.

- Opções flexíveis de incorporaçãoCompatível com vários modelos de incorporação para facilitar a seleção da melhor opção.

- Suporte a modelos em vários idiomasSuporte para grandes modelos, como DeepSeek, OpenAI etc., para geração inteligente de perguntas e respostas e conteúdo.

- Carregador de documentosCarregamento de arquivos locais é suportado e o rastreamento da Web será adicionado no futuro.

Usando a Ajuda

Processo de instalação

- Armazém de Clonagem:

git clone https://github.com/zilliztech/deep-searcher.git

- Crie um ambiente virtual Python (recomendado):

python3 -m venv .venv

source .venv/bin/activate

- Instale a dependência:

cd deep-searcher

pip install -e .

- Configuração do LLM ou do Milvus: Editar

examples/example1.pypara configurar o LLM ou o Milvus conforme necessário. - Prepare os dados e execute o exemplo:

python examples/example1.py

Instruções de uso

- Configuração do LLM: Em

deepsearcher.configurationuse o móduloset_provider_configMétodos para configurar o LLM, por exemplo, configurar um modelo OpenAI:

config.set_provider_config("llm", "OpenAI", {"model": "gpt-4o"})

- Carregar dados locais: Uso

deepsearcher.offline_loadingno móduloload_from_local_filespara carregar dados locais:

load_from_local_files(paths_or_directory="your_local_path")

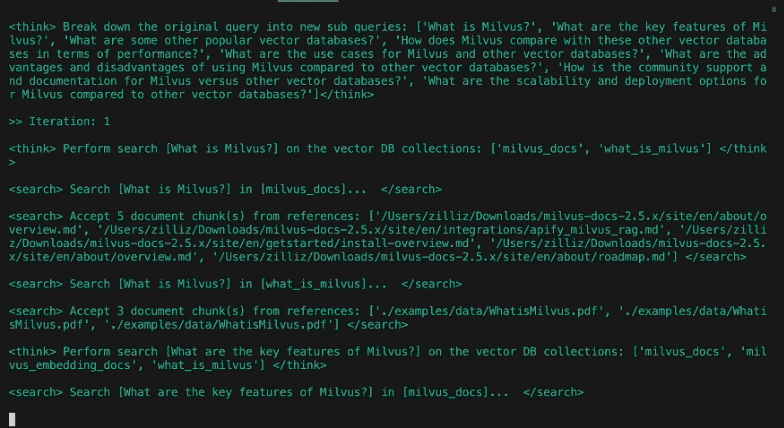

- Consultar dados: Uso

deepsearcher.online_queryno móduloqueryOs métodos são consultados:

result = query("Write a report about xxx.")

Fluxo de operação detalhado da função

- Pesquisa de dados privados::

- Maximize o uso de dados em sua empresa e, ao mesmo tempo, garanta a segurança dos dados.

- O conteúdo on-line pode ser integrado quando forem necessárias respostas mais precisas.

- Gerenciamento de banco de dados vetorial::

- Oferece suporte a bancos de dados vetoriais, como o Milvus, permitindo que os dados sejam particionados para uma recuperação mais eficiente.

- O suporte a mais bancos de dados vetoriais (por exemplo, FAISS) está planejado para o futuro.

- Opções flexíveis de incorporação::

- Compatível com uma ampla gama de modelos incorporados para facilitar a seleção da melhor solução.

- Suporte a modelos em vários idiomas::

- Suporte a grandes modelos como DeepSeek, OpenAI etc. para geração inteligente de perguntas e respostas e conteúdo.

- Carregador de documentos::

- O carregamento de arquivos locais é suportado e o rastreamento da Web será adicionado no futuro.