はじめに

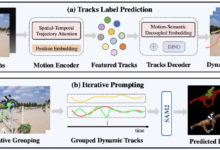

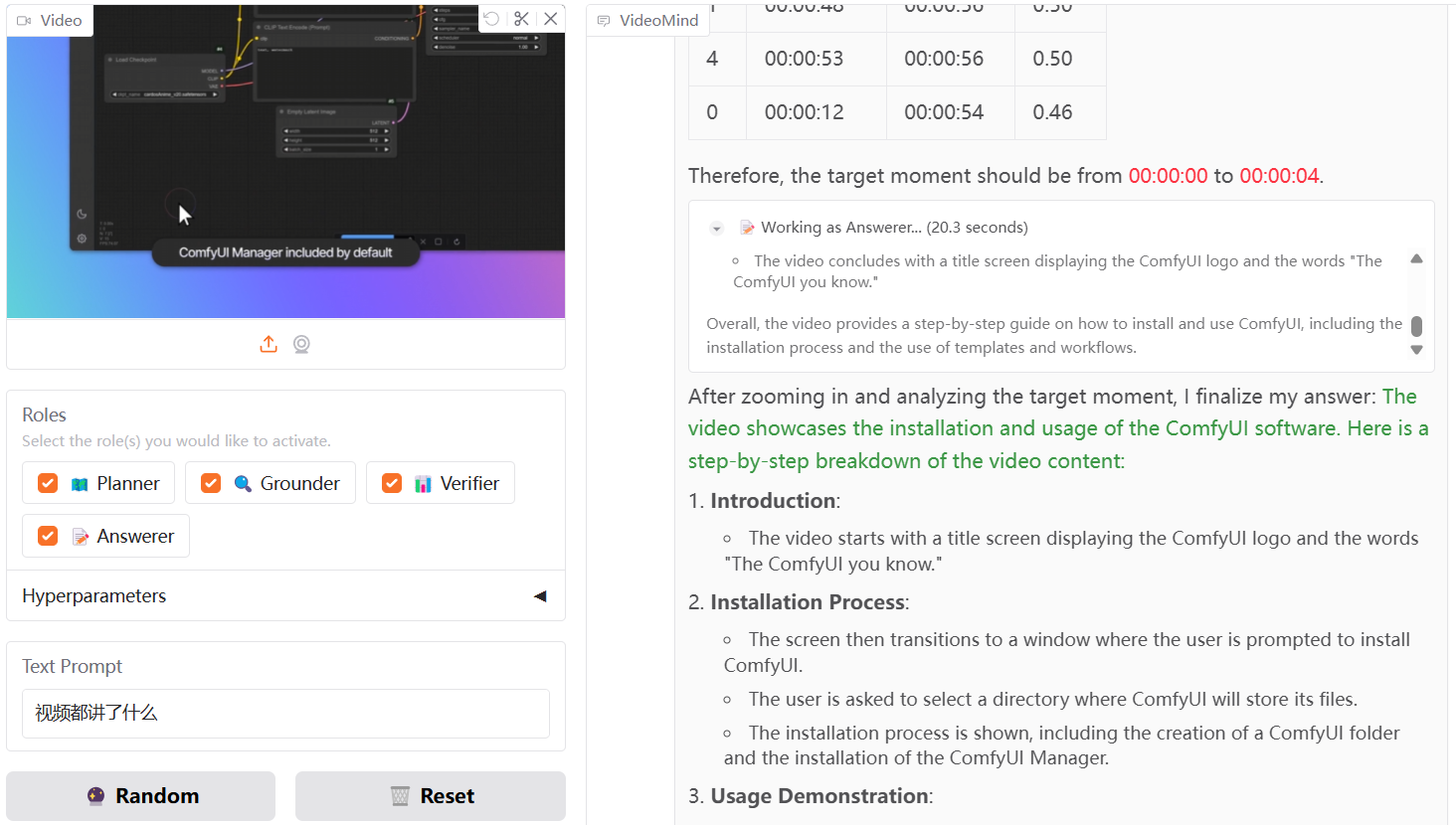

VideoMindはオープンソースのマルチモーダルAIツールで、長尺動画の推論、Q&A、要約生成に特化している。香港理工大学のイェ・リューとシンガポール国立大学のショー・ラボのチームによって開発された。このツールは、タスクを計画、位置決め、検証、回答といったステップに分解し、問題を段階的に解決することで、人間が動画を理解する方法を模倣している。コアテクノロジーはChain-of-LoRAであり、ベースモデルを通じて役割の切り替えを行い、効率的かつ資源効率的である。VideoMindは2024年3月21日にコード、モデル、データセットを正式にリリースし、技術レポートは2025年3月17日に更新される。VideoMindはGitHubまたはGitHub経由で入手可能である。ユーザーはGitHubまたはHugging Face経由でリソースにアクセスできる。

このプロジェクトは、内容を理解するためにテキストに音声を抽出するのではなく、純粋にグラフィカルで、正確にビデオの内容を理解するためにタイムスタンプによると、自動ビデオの微調整、教育シナリオ、非常に実用的に使用することができます!

経験:https://huggingface.co/spaces/yeliudev/VideoMind-2B

機能一覧

- 長い動画の時間的ターゲティング:質問に関連する動画の時間帯を見つける。

- 動画Q&A機能:ユーザーの質問に基づき、動画から的確な回答を抽出。

- ビデオ要約の作成:主要なビデオコンテンツを抽出し、簡潔な概要を作成します。

- マルチモーダル・エージェント・フレームワーク:プランナー、ロケーター、バリデーター、レスポンダーを含み、タスク上で協働する。

- チェーン・オブ・ロラ(Chain-of-LoRA)技術:単一モデルで多機能を実現し、資源消費を削減。

- 複数のハードウェアをサポート:NVIDIA GPUまたはAscend NPUで動作。

- 効率的なトレーニングサポート:DeepSpeed、LoRA、FlashAttention2などの技術を統合。

- オンラインデモ:Gradioのインターフェイスで機能を素早く体験できます。

ヘルプの使用

VideoMind はオープンソースプロジェクトであり、ユーザーはコードをダウンロードし、使用環境を設定する必要があります。以下は、インストールと機能の使用方法に関する詳細なガイドです。

設置プロセス

- クローン・コード・リポジトリ

ターミナルで以下のコマンドを実行し、VideoMindのソースコードをダウンロードする:

git clone https://github.com/yeliudev/VideoMind.git

プロジェクト・カタログにアクセスする:

cd VideoMind

- Python環境のセットアップ

condaを使って仮想環境を作成する(Python 3.12推奨):

conda create -n videomind python=3.12 -y

conda activate videomind

- 依存ライブラリのインストール

以下のコマンドを実行して、必要な依存関係をインストールする:

pip install -r requirements.txt

効率的なトレーニングのために、DeepSpeedをインストールしてください:

pip install deepspeed

- モデルとデータセットのダウンロード

- https://huggingface.co/collections/yeliudev/videomind-67dd41f42c57f0e7433afb36、事前に訓練されたモデルをダウンロードする(例)。

VideoMind-2Bに解凍してください。modelsフォルダー - データセットはhttps://huggingface.co/datasets/yeliudev/VideoMind-Dataset下载、27のビデオデータセットとVideoMind-SFT(481Kのトレーニングデータ)が含まれている。

dataカタログ

- 試験施工

テストスクリプトを実行して、環境が正しいことを確認します:

python test.py

主な機能

1.長編ビデオの時間ポジショニング

- ビデオの準備ビデオファイルを

data/videosカタログ、サポートMP4、AVIおよび他のフォーマット。 - コマンド実行::

python run_grounding.py --video_path data/videos/sample.mp4 --query "找到讨论AI的部分"

- 結果出力例:"00:05:12 - 00:07:34"。

2.ビデオクイズ

- 入力の問題新着情報

query.txt"ビデオの主人公は誰ですか?"などの質問を書く。. - コマンドを実行する::

python run_qa.py --video_path data/videos/sample.mp4 --query_file query.txt

- 回答を見る主人公は李明です。

3.ビデオ・サマリーの作成

- コマンド実行::

python run_summary.py --video_path data/videos/sample.mp4

- 概要を見る結果は

summary.txt例えば、「科学技術の講義を紹介するビデオ」。

注目の機能操作

Chain-of-LoRAテクノロジー

- VideoMind は単一のモデルを使用して、LoRA アダプタを介して役割を切り替えます。設定ファイルは

config/lora.yaml調節可能rankパラメーターブースト効果:

lora:

rank: 16

オンラインデモ

- ローカルにインストールする必要はないので、https://huggingface.co/spaces/yeliudev/VideoMind-2B、ビデオをアップロードして質問を入力すれば、機能を直接体験することができる。詳しくは

docs/DEMO.md.

トレーニングモデル

- データの準備使用

VideoMind-SFTまたはその他の27のデータセットがdataカタログ - プライミングトレーニング走れ:

python train.py --dataset data/VideoMind-SFT --model models/VideoMind-2B

- モニタートレーニングTensorboardまたはWandbをサポートし、進捗状況を確認できる。

docs/TRAIN.md.

ほら

- ビデオファイルが大きすぎる場合は、メモリのオーバーフローを避けるため、分割して処理することをお勧めします。

- Ascend NPUユーザーは、Ascendドライバをインストールし、実行時にパラメータを追加する必要がある。

--device ascend. - コミッショニングの詳細については、以下を参照のこと。

docs/EVAL.mdベンチマークガイドラインを含む。

以上の手順で、ユーザーはVideoMindを素早くインストールして使用し、長時間のビデオ作業を処理することができる。

アプリケーションシナリオ

- 映像コンテンツ分析

ユーザーはVideoMindを使って、YouTubeの長い動画を分析し、重要なクリップを探し出したり、視聴時間を節約するために要約を作成したりすることができる。 - 教育・研究

講義ビデオを扱う学生や研究者は、"どのアルゴリズムが取り上げられたか?"と質問し、その答えを得ることができる。と尋ねて答えを得ることができ、より効率的にノートを整理することができます。 - コンテンツ監査

プラットフォーム管理者は、違反クリップのチェックなど、ビデオコンテンツが準拠しているかどうかを確認するために使用する。

品質保証

- VideoMind はどのくらいの長さのビデオを扱えますか?

ハードウェアにもよるが、16GBのRAMで1時間の動画を処理でき、32GBなら長時間のコンテンツにも対応できる。 - オンラインデモと現地展開の違いは何ですか?

オンライン・バージョンはインストールが不要だが、機能が限られている。ローカル・バージョンは、カスタム・トレーニングや大規模な処理をサポートしている。 - データセットはどのように使われているのですか?

トレーニングおよび評価には27のデータセットが使用され、VideoMind-SFTは、https://huggingface.co/datasets/yeliudev/VideoMind-Dataset で説明されているように、モデルの最適化に適していた。