最近、待望の クウェン2.5-VL Qwen2.5-VLシリーズの新モデル「Qwen2.5-VL-32B-Instruct」をリリースしました。この320億パラメータ規模のマルチモーダル視覚言語モデルは、Qwen2.5-VLシリーズの長所を継承しつつ、強化学習などの手法によりさらに最適化され、特に複雑な推論やユーザーエクスペリエンスにおいて大幅な性能向上を実現しています。

今年1月末、QwenチームはQwen2.5-VLシリーズを発表し、瞬く間にコミュニティから広く注目され、好評を博した。コミュニティの期待に応え、マルチモーダルモデリング技術の開発を促進し続けるため、チームは数ヶ月かけてQwen2.5-VLシリーズを慎重に磨き上げ、最終的にこの新しいQwen2.5-VL-32B-Instructモデルを発表しました。

前世代や類似モデルを凌駕する数々の指標を備えた、飛躍的なパフォーマンス

公式データによると、Qwen2.5-VL-32B-Instructモデルは、以前にリリースされたQwen2.5-VLシリーズと比較して、多くの主要性能指標で大幅な改善を達成している。

第一に、主観的なユーザーの嗜好という点で、新しいモデルは、出力スタイルを調整することにより、返信をより詳細に、より標準化された形式にする。これは、ユーザーが使用中によりスムーズで自然なインタラクション体験を得られることを意味する。

第二に、数学的推論能力において、Qwen2.5-VL-32B-Instructモデルは、複雑な数学的問題を解く精度で大きな進歩を遂げた。このことは、論理的推論能力と計算能力が効果的に強化され、深い思考と正確な計算を必要とする課題に対応できるようになったことを示している。

さらに、Qwen2.5-VL-32B-Instructモデルは、画像のきめ細かな理解と推論において、より高い強みを発揮します。画像解析の正確さ、内容認識の広さ、視覚論理推論の深さなど、新モデルはより高いレベルを示し、画像情報をより正確かつ綿密に解析することができる。

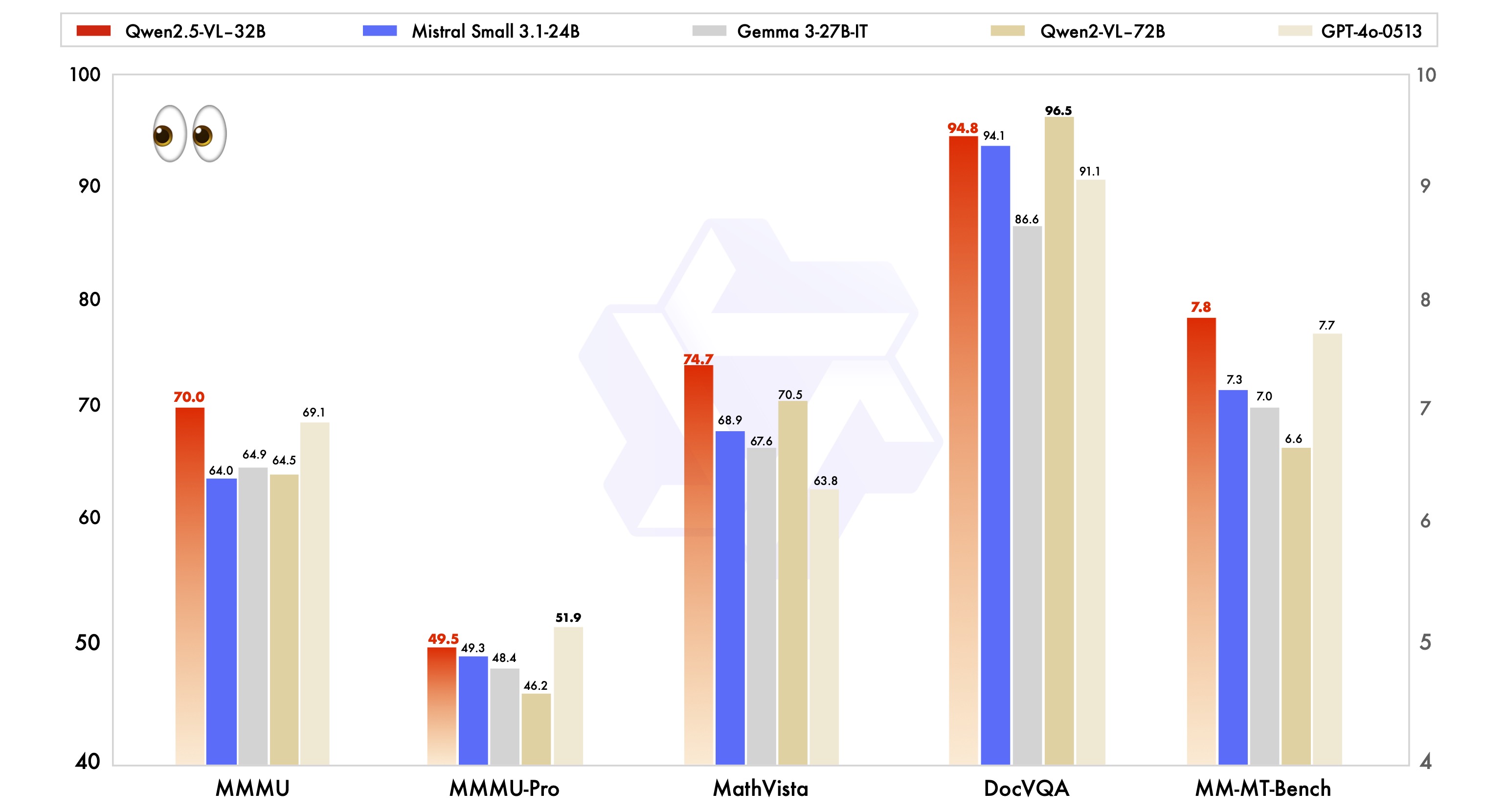

また、Qwen2.5-VL-32B-Instruct モデルの性能の優位性を実証するため、Mistral-Small-3.1-24B や Gemma-3-27B-IT など、業界をリードする同サイズのモデルとの比較テストも実施しました。その結果、Qwen2.5-VL-32B-Instruct モデルが、多くのマルチモーダルなタスクにおいて明らかな優位性を示し、いくつかの指標は、より大規模な Qwen2-VL-72B-Instructモデルをも凌駕することが分かりました。特に、Qwen2.5-VL-32B-Instruct モデルの卓越した性能は、MMMU、MMMU-Pro、MathVista のような複雑なマルチステップ推論を重視するタスクにおいて印象的です。また、主観的なユーザー体験を重視する MM-MT-Bench ベンチマ ークにおいても、Qwen2-VL-72B-Instruct と比較して大きな進歩を遂げています。

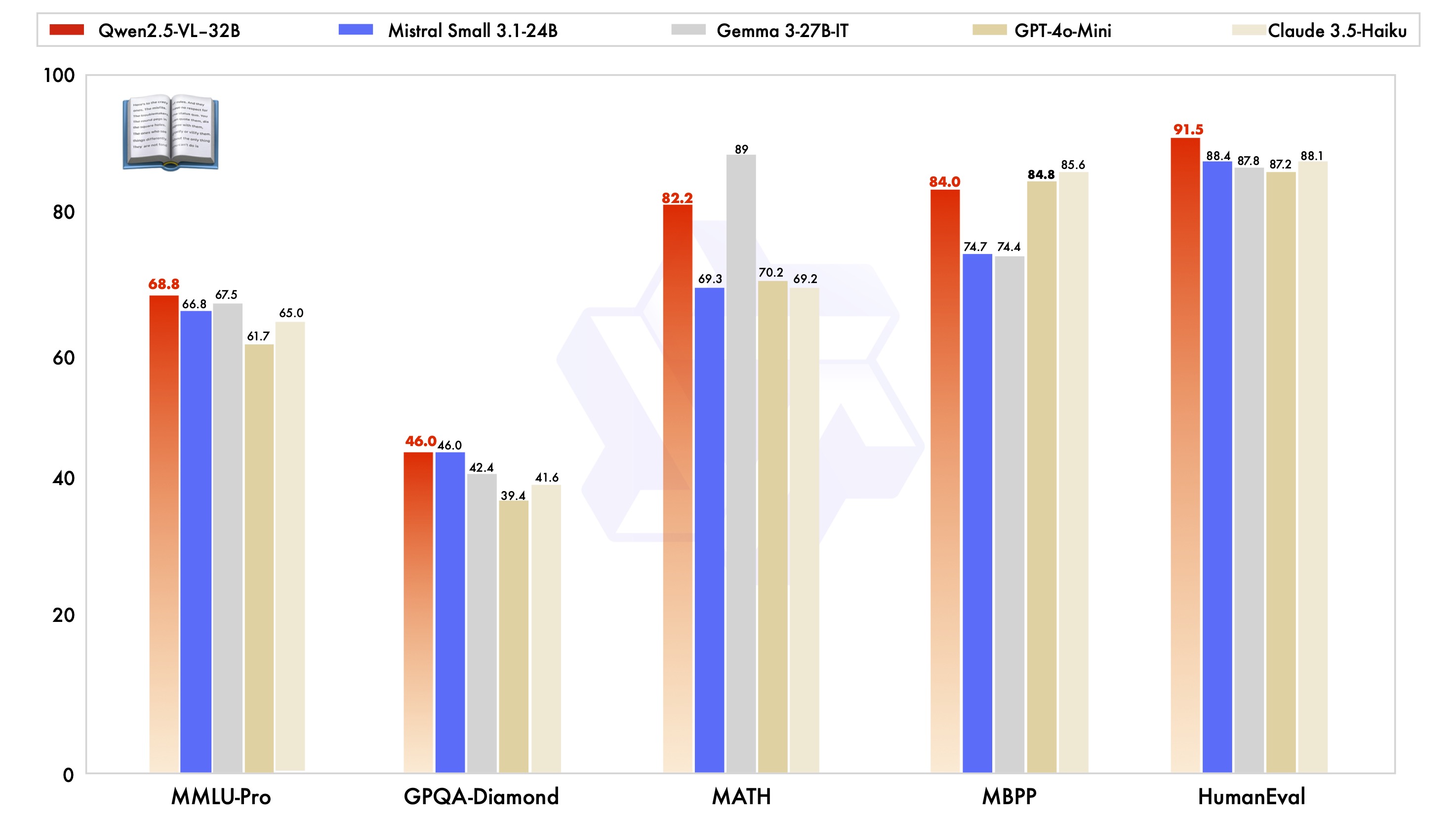

特筆すべきは、Qwen2.5-VL-32B-Instructモデルが、視覚的能力という点で良い結果を出しているだけでなく、プレーンテキスト能力という点でも同規模モデルの最適レベルを達成していることだ。

テクノロジーハイライト:ダイナミック解像度、効率的なビジュアルエンコーダー

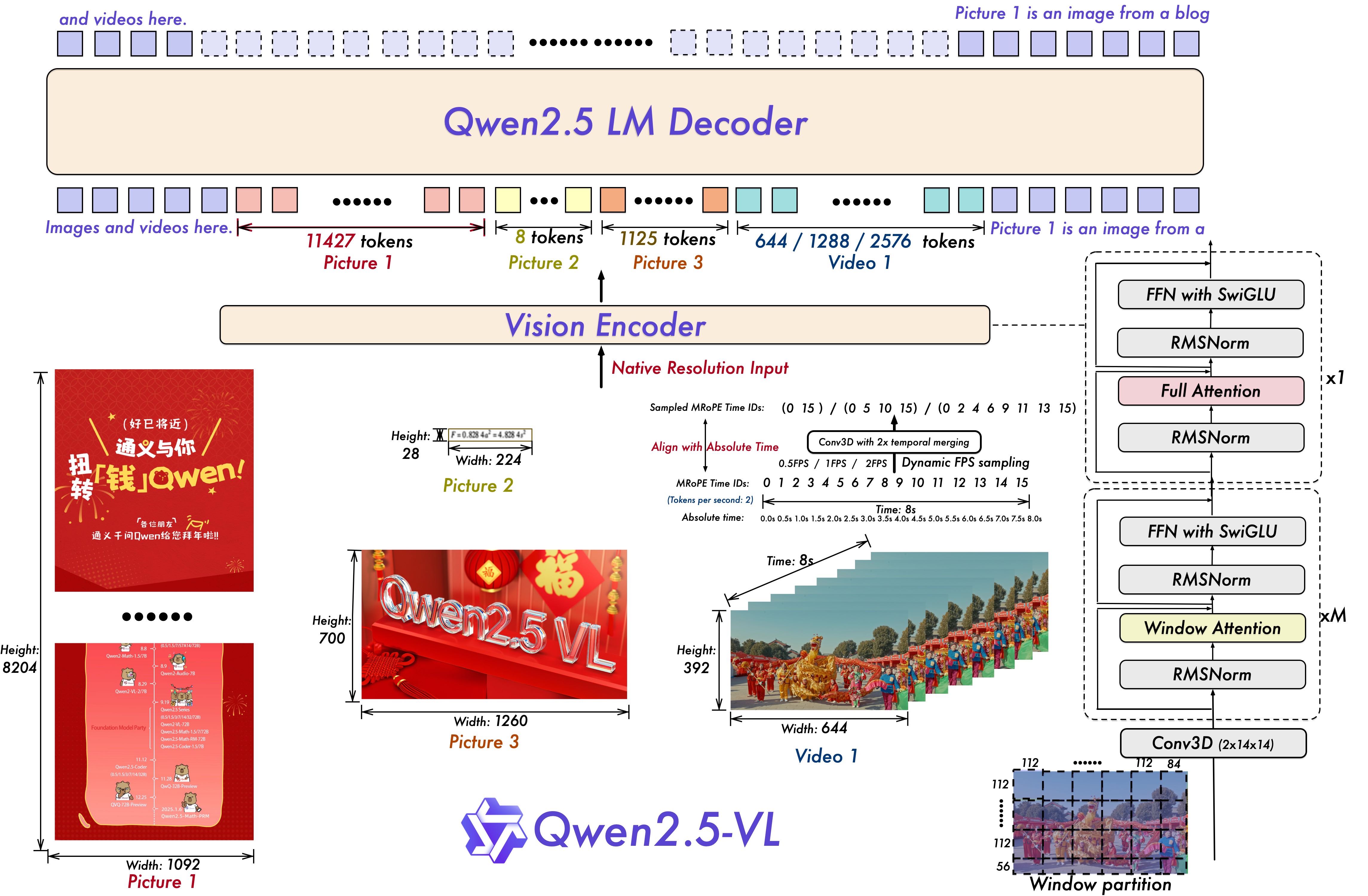

Qwen2.5-VLシリーズは、技術的なアーキテクチャーにも一連の革新とアップグレードが施されている。

ビデオ理解のために、モデルは動的解像度とフレームレートの学習技術を使用し、動的FPSサンプリングを導入することで、異なるサンプリングレートのビデオコンテンツを理解することを可能にする。一方、mRoPE (Multiple Relative Position Encoding)は時間次元で更新され、IDや絶対時間アライメントと組み合わされることで、モデルが時系列や速度情報を学習することを可能にし、映像の重要な瞬間を捉える能力を提供する。

ビジョンエンコーダについては、Qwen2.5-VLシリーズのモデルは合理的で効率的なビジョンエンコーダを採用しており、ViT(Vision)エンコーダで使用することができます。 変圧器)は、Qwen2.5 LLMの窓付きアテンションメカニズムを戦略的に導入し、SwiGLUやRMSNormなどの最適化と組み合わせることで、ViTアーキテクチャをQwen2.5 LLMの構造との整合性を高め、モデル学習と推論の速度を効果的に向上させている。

マルチモーダル・アプリケーション・イノベーションのためのオープンソース・インクルージョン

Qwen2.5-VL-32B-Instructモデルのオープンソースリリースは、間違いなくマルチモーダル視覚言語の分野に新たな活力を注入するでしょう。このモデルに基づいて、開発者や研究者はより深い研究を行い、画像やビデオコンテンツの理解、インテリジェントエージェント、クロスモーダルコンテンツの生成など、より幅広いアプリケーションを開発することができます。

Qwen2.5-VL-32B-Instructモデルは現在、Hugging Face TransformersとModelScopeで公開されており、詳細なコードサンプルと説明書が付属しているため、ユーザーはすぐに使い始めることができます。Qwenチームは、Qwen2.5-VLシリーズの最適化と改良のため、今後もコミュニティからのフィードバックに注目していくことを表明しています。Qwen2.5-VLシリーズは、今後もコミュニティからのフィードバックに注目し、最適化と改良を続け、マルチモーダル技術の発展に貢献していきます。

Qwen2.5-VL-32B-Instructモデルを体験したい方は、以下の方法でクイックスタートが可能です:

環境設定

互換性を確保するため、ユーザーはトランスフォーマー・ライブラリーをソースからビルドすることを推奨する:

pip install git+https://github.com/huggingface/transformers accelerateクイックスタートコード例(🤗トランスフォーマーを使用)。

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

Qwen2.5-VL-32B-Instructモデルのリリースは、間違いなくマルチモーダル視覚言語モデルの分野に新たなブレークスルーをもたらし、性能、技術、オープンソースにおけるその優位性は、マルチモーダル技術の普及と応用を加速させることが期待され、業界の継続的な注目に値する。