OpenAIは最近、開発者がよりパワフルでインテリジェントな音声アシスタントを構築できるように設計された、新世代の音声モデリングAPIのローンチを発表した。このイニシアチブは、音声対話技術の分野における大きな進歩であり、人間とコンピュータの音声対話がより自然で効率的な新たな段階を迎えることを示唆している。

このリリースには2つの重要なアップデートが含まれています。それは、より高度な音声合成モデルと、より表現力豊かな音声合成モデルです。OpenAIは、特に複雑なアクセント、ノイズの多い環境、発話速度の変化といった困難なシナリオにおいて、精度と信頼性の新たなベンチマークを設定するとしています。パフォーマンスの向上は、複雑なアクセント、ノイズの多い環境、発話速度の変化といった困難なシナリオにおいて特に顕著です。つまり、この新しいモデルは、カスタマー・コールセンターや議事録の書き起こしなどの用途において、書き起こしの品質と効率を劇的に向上させるということです。

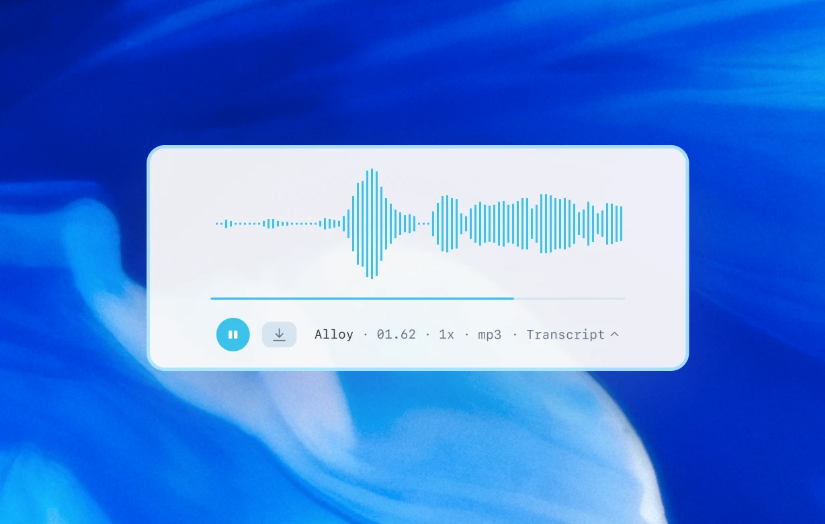

特筆すべきは、OpenAIで初めて、開発者が音声合成モデルに特定の話し方を指示できるようになったことだ。例えば、開発者はモデルを「共感的なカスタマーサービスエージェントのように話す」ように設定することができ、音声アシスタントにパーソナライゼーションの前例のない範囲を与えることができます。この機能は、より人間的なカスタマーサービスから、より表現力豊かなクリエイティブなストーリーテリングまで、さまざまなシナリオに新たな扉を開く。

OpenAIは2022年に最初のオーディオモデル「Whisper」を発表して以来、モデルのインテリジェンス、精度、信頼性を向上させるための投資を続けてきた。今回の新しい音声モデルのリリースは、その長年の努力の集大成です。開発者はAPIを通じて、より正確な音声合成システムや、より特徴的で生き生きとした音声合成システムを構築できるようになりました。

新世代の音声テキスト変換モデル:gpt-4o-transcribeとgpt-4o-mini-transcribe

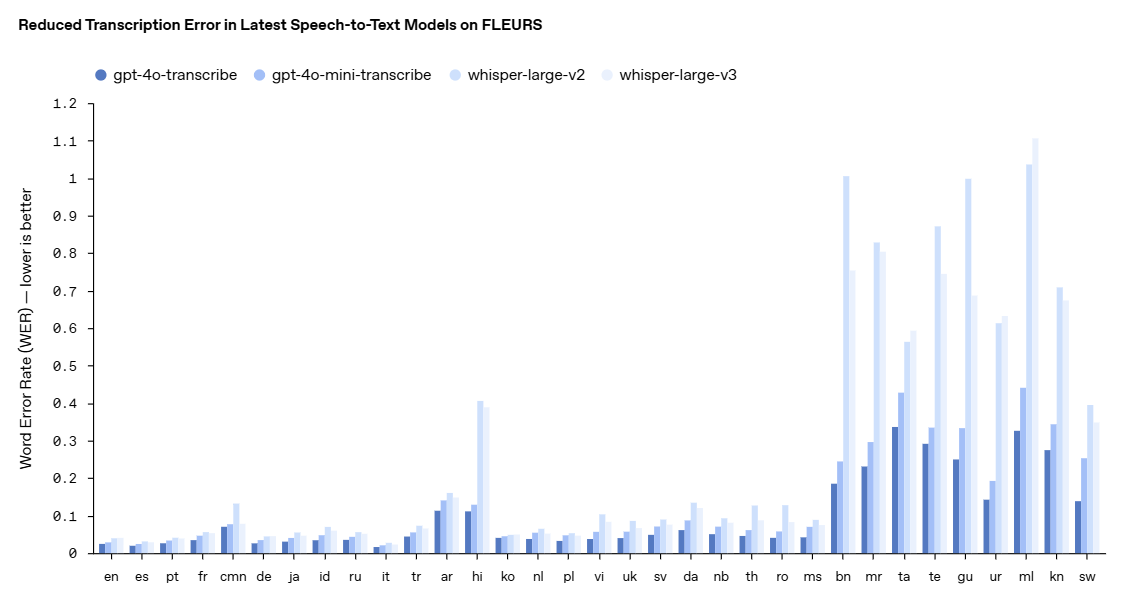

OpenAIは、gpt-4o-transcribeとgpt-4o-mini-transcribeの2つの新しいモデルをリリースした。 ウィスパー これらのモデルは、単語誤り率(WER)、言語認識、精度の大幅な向上を示している。

- WER(Word Error Rate:単語誤り率)は、基準となる書き起こし単語と比較して、誤って書き起こされた単語の割合を計算することで、音声認識モデルの精度を測定するもので、WERが低いほど、誤りが少ないことを意味します。私たちの最新の音声テキスト化モデルは、FLEURS(Learning Evaluation of Speech Universal Representation with Small Samples)を含む様々なベンチマークで低いWERを達成しています。これらの結果は、より高い書き起こし精度と、より強力な言語カバー率を示しています。ここに示すように、我々のモデルは全ての言語評価において一貫してWhisper v2とWhisper v3を上回っています。

gpt-4o-transcribeは、多くの権威あるベンチマークにおいて、Whisperモデルの単語誤り率を上回る性能を実証しました。単語誤り率は音声認識モデルの精度を測る重要な指標であり、値が低いほど誤りが少ないことを意味します。OpenAIによると、これらの改善は強化学習と、多様で高品質な音声データセットを使用した大規模な中間トレーニングにおける的を絞った革新的技術によるものです。

その結果、新しい音声テキスト化モデルは、特に訛りやノイズの多い環境、発話速度の違いといった複雑な状況に対応する場合に、音声のニュアンスをより的確に捉え、誤認識を減らし、書き起こしの信頼性を向上させることができる。これらのモデルは現在、音声テキストAPIで使用するために公開されています。

パフォーマンスの向上をより視覚的に示すために、OpenAIはFLEURS(Few-shot Learning Evaluation of ユニバーサル Representations of Speech (FLEURS)ベンチマークの結果、手作業で書き起こした音声サンプルを使用し、100以上の言語をカバーする多言語音声ベンチマークです。その結果、OpenAIの新しいモデルは、Whisper v2およびWhisper v3よりも単語誤り率が低く、言語横断的な評価において、より高い書き起こし精度と幅広い言語カバレッジを実証しています。

新世代の音声合成モデル:gpt-4o-mini-ts

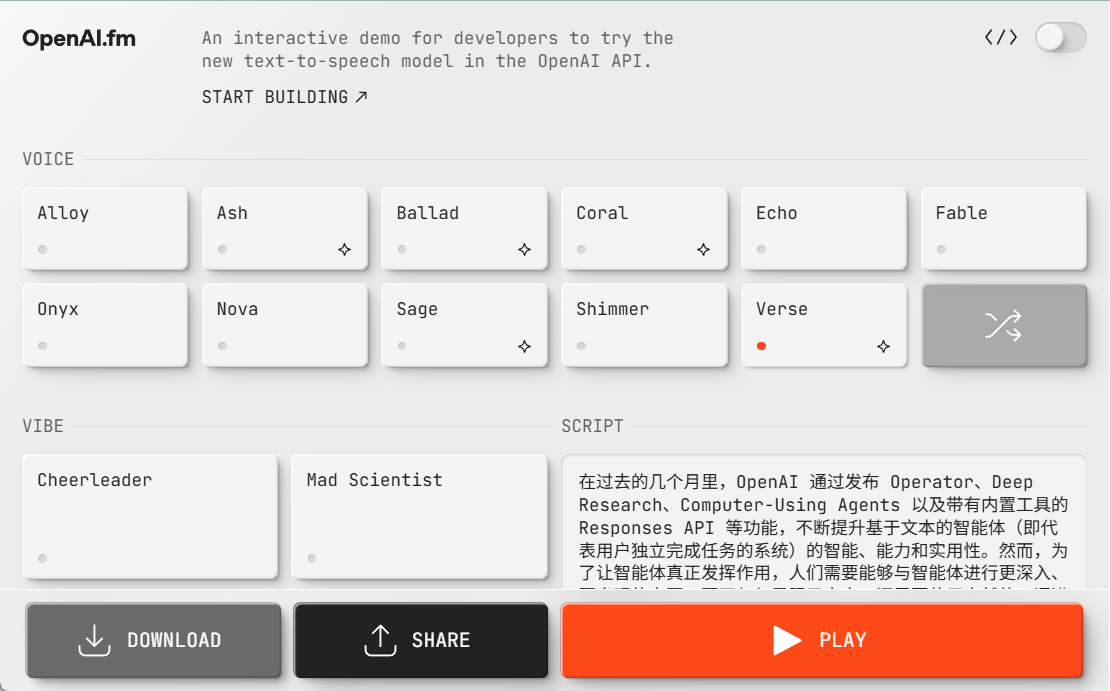

音声合成モデルに加え、OpenAIは新しい音声合成モデルgpt-4o-mini-ttsを発表した。開発者はモデルが話す内容をコントロールできるだけでなく、どのように話すかを指示することもできます。この機能により、顧客サービスからクリエイティブなコンテンツまで、ユーザー体験のカスタマイズが可能になります。このモデルはText-to-Speech APIでも利用可能です。これらの音声合成モデルは、現在プリセットされた合成音声に限定されており、OpenAIは合成されたプリセット音声との整合性を監視しています。

gpt-4o-mini-ttsはこちら!

https://www.openai.fm/

モデルを支える技術革新

OpenAIの発表によると、新しい音声モデルはGPT-4oおよびGPT-4o-miniアーキテクチャの上に構築され、モデルのパフォーマンスを最適化するために重要な音声に特化したデータセットを使用して、事前に大規模なトレーニングを行った。この的を絞ったアプローチにより、モデルは音声の微妙なニュアンスをより深く理解し、オーディオ関連のさまざまなタスクで優れた能力を発揮します。

さらに、OpenAIは、大規模な音声モデルから小規模で効率的なモデルへの知識移転を可能にするために、知識洗練技術を改善しました。高度なセルフゲーミング手法を活用することで、洗練されたデータセットは実際の対話ダイナミクスを効果的に捉え、実際のユーザーアシスタントとの対話シナリオを再現します。これにより、小型モデルは優れた対話品質と応答性を提供することができます。

音声テキストモデリングにおいて、OpenAIは強化学習(RL)主導のパラダイムを採用し、転写精度を次のレベルに引き上げました。このアプローチにより、精度が大幅に向上し、幻覚が減少するため、複雑な音声認識シナリオにおいて、OpenAIのSpeech-to-Textソリューションの競争力が高まります。

これらの技術的進歩は、音声モデリングの分野における最新の進歩であり、OpenAIは革新的なアプローチと、音声アプリケーションのパフォーマンス向上を目的とした実用的な改良を組み合わせています。

APIの開放性と将来展望

これらの新しい音声モデルは、すべての開発者が利用できるようになりました。すでにテキストモデルを使って対話体験を構築している開発者にとっては、音声-テキストおよびテキスト-音声モデルを統合することが音声アシスタントを構築する最も簡単な方法です。OpenAIはまた、開発プロセスを簡素化するためにエージェントSDKとの統合をリリースしました。低遅延の音声合成体験を構築したい開発者には、OpenAIはRealtime APIにある音声合成モデルの使用を推奨しています。

今後、OpenAIはオーディオモデルのインテリジェンスと精度にさらに投資し続け、開発者がカスタムサウンドを導入してよりパーソナライズされた体験を構築できるようにする方法を模索するとともに、OpenAIのセキュリティ基準への準拠を保証する予定です。さらに、OpenAIは、政策立案者、研究者、開発者、クリエイターとの対話を積極的に行い、合成されたサウンドがもたらす課題と機会について議論しています。OpenAIは、開発者がこれらの強化されたオーディオ機能を使用して構築する革新的なアプリケーションに期待しており、マルチモーダルなインテリジェンス体験を構築する開発者をサポートするために、ビデオを含む他のモダリティへの投資を継続すると述べています。

OpenAIの新世代の音声モデルAPIのリリースは、音声インタラクション技術の発展に新たな活力を注入したことは間違いない。技術の絶え間ない進歩と、ますます豊かになるアプリケーションシナリオによって、デジタル世界の未来はより「聞いて話すことができる」ようになり、人間とコンピュータの相互作用はより自然でスムーズになると信じる理由がある。