はじめに

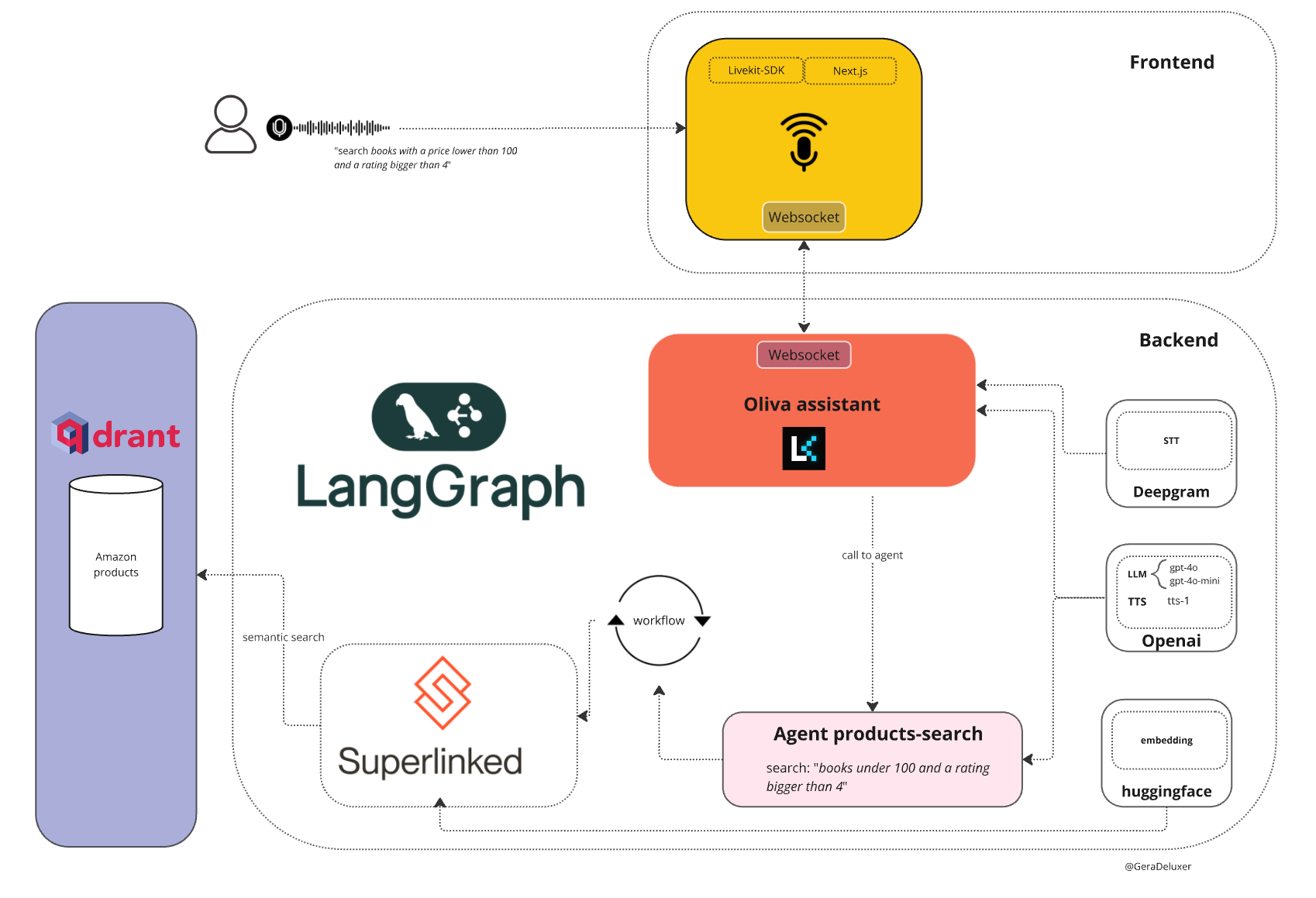

OlivaはDeluxerがGitHub上で開発したオープンソースのマルチインテリジェンスアシスタントツールです。OlivaはDeluxerがGitHubで開発したオープンソースのマルチインテリジェンスアシスタントツールで、複数のAIインテリジェンスの連携によりQdrantデータベースの商品情報を検索する手助けをします。Olivaは開発者や研究者に適しており、コードはユーザーがダウンロード、修正、デプロイできるように完全にオープンになっている。実用的なツールであるだけでなく、マルチ・インテリジェンス・アーキテクチャを学ぶためのプラットフォームでもある。このプロジェクトは、以下のような最新のテクノロジー・スタックに依存している。 ライブキット とDeepgramはリアルタイムの音声対話をサポートしている。

機能一覧

- 音声制御検索:ユーザーが音声でコマンドを入力すると、インテリジェントボディが検索タスクを完了する。

- マルチインテリジェンス・コラボレーション:複数のAIインテリジェンスが処理タスクを分担し、スーパーバイザーインテリジェンスが調整する。

- 意味検索サポート:LangChainとSuperlinkedに基づき、正確なコンテンツ検索を可能にします。

- オープンソース・コード:完全なコードが提供され、ユーザーは自由に機能を変更・拡張できる。

- ローカルまたはクラウドでの展開:高い柔軟性でローカルまたはサーバー上での実行をサポート。

ヘルプの使用

OlivaはGitHubをベースとしたオープンソースプロジェクトであり、使用する前に環境と依存関係を設定する必要があります。以下は、すぐに使い始められるように、詳しいインストールと使い方のガイドです。

設置プロセス

- Python環境の準備

OlivaにはPython 3.12以降が必要です。バージョンを確認してください:

python --version

正しいバージョンを持っていない場合は、Pythonのウェブサイトに行き、ダウンロードしてインストールしてください。

- クローンプロジェクト

https://github.com/Deluxer/oliva、「コード」ボタンをクリックし、HTTPSリンクをコピーして実行する:

git clone https://github.com/Deluxer/oliva.git

まずGitをインストールする必要がある。ダウンロード・アドレスはGit公式サイト。

- プロジェクト・ディレクトリに移動する

ダウンロードしてフォルダに移動する:

cd oliva

- 仮想環境の構築

依存関係の衝突を避けるために、仮想環境を作成することをお勧めします:

python -m venv .venv

環境を活性化させる:

- ウィンドウズ

.venv\Scripts\activate - Mac/Linux:

source .venv/bin/activate

- 依存関係のインストール

利用するuvツール同期の依存関係:

uv sync

これで自動的に仮想環境が作成され、LangChainやSuperlinkedなどの依存関係がすべてインストールされます。もし uvまずはインストールしてください:

pip install uv

- Qdrantデータベースの設定

DockerでQdrantを動かす:

docker run -p 6333:6333 -p 6334:6334 -e QDRANT__SERVICE__API_KEY=your_api_key -v "$(pwd)/qdrant_storage:/qdrant/storage:z" qdrant/qdrant

まずDockerをインストールする必要がある。Docker公式ウェブサイトからダウンロードする。Dockerを your_api_key カスタムキーに置き換える。

- Livekitアカウントの設定

ある ライブキット・クラウド 以下の情報を登録する:

LIVEKIT_URL=wss://your-project.livekit.cloud

LIVEKIT_API_KEY=your_key

LIVEKIT_API_SECRET=your_secret

これらの値を環境変数に保存する。

- 環境変数の設定

サンプルファイルをコピーして編集する:

cp .env.example .env

ある .env ファイルにはライブキットと ディープグラム (ディープグラムは ディープグラム公式サイト (アクセスするには登録が必要です)。

- データベースへの入力

に基づいている。 表形式意味検索チュートリアル を解凍してデータをセットアップしてください。assets/snapshot.zipスナップショットをQdrantに送る。

主な機能

- 音声アシスタントの起動

プロジェクト・ディレクトリで実行する:

make oliva-start

これで音声アシスタントサービスが開始されます。QdrantとLivekitが起動していることを確認してください。

- フロントエンド・インターフェースへの接続

インタビュー エージェントの遊び場Livekitプロジェクトがある場合は、Livekitプロジェクトの認証情報を入力してアシスタントに接続します。またはローカルで実行してください: - クローン 遊び場倉庫代理店::

git clone https://github.com/livekit/agents-playground.git - 依存関係をインストールして開始する:

npm install npm run start

インターフェイスに音声コマンドを入力する。

- セマンティックサーチ

検索には2つの方法がある: - スーパーリンクを使用する:

make agent-search-by-superlinked - JSONファイルを使用する:

make agent-search-by-json

検索結果はQdrantデータベースからインテリジェンスによって返されます。

注目の機能操作

- 音声対話

Olivaは音声によるコマンド入力をサポートしています。起動後、エージェント 遊び場 Deepgramのマイクアイコンをタップし、欲しいもの(「携帯電話を探す」など)を言うと、Deepgramが音声をテキストに変換し、インテリジェンスがそれを処理して結果を返す。どのインテリジェンスがタスクを実行するかは、スーパーバイザー・インテリジェンスが決定する。 - マルチインテリジェンス・コラボレーション

このプロジェクトでは、複数のノード(検索、生成など)と条件付きエッジを含むグラフィカルなワークフロー(LangGraph)を使用する。設定ファイルはapp/agents/langchain/config/インテリジェントな身体の挙動を調整することができる。のコアロジックはapp/agents/カタログ - カスタムエクステンション

機能を追加しますか?編集するapp/agents/implementations/をスマート本体のコードに追加します。例えば、新しいツールを追加するには、スマート本体のコードにapp/agents/langchain/tools/で定義されている。

ほら

- LivekitとDeepgramはインターネット接続が必要です。

- プロジェクトには多くの依存関係があり、初期設定には複数のデバッグ・セッションが必要になるかもしれない。

- GitHubのコミットをチェックして、最新のコードを使用していることを確認してください。

以上の手順で、Olivaの全機能を実行し、音声操作による検索機能を体験することができる。

アプリケーションシナリオ

- 製品情報のお問い合わせ

ユーザーが音声で商品の詳細を尋ねると、OlivaはQdrantデータベースから結果を返します。 - テクニカル・ラーニング

開発者はマルチインテリジェント・ボディ・アーキテクチャを研究し、異なるワークフローをテストするためにコードを修正する。 - ライブデモ

音声アシスタント機能を会議で実演し、AIコラボレーション機能を強調する。

品質保証

- 音声アシスタントが応答しない場合はどうすればよいですか?

LivekitおよびDeepgramキーが正しく設定されていることを確認し、ネットワーク接続が機能していることを確認します。 - Qdrantが起動しない場合はどうすればいいですか?

Dockerが起動していること、ポート6333と6334が占有されていないことを確認する。 - オフラインで使用できますか?

音声機能にはインターネット接続が必要で、検索機能はデータがローカライズされていればオフラインで実行できる。