はじめに

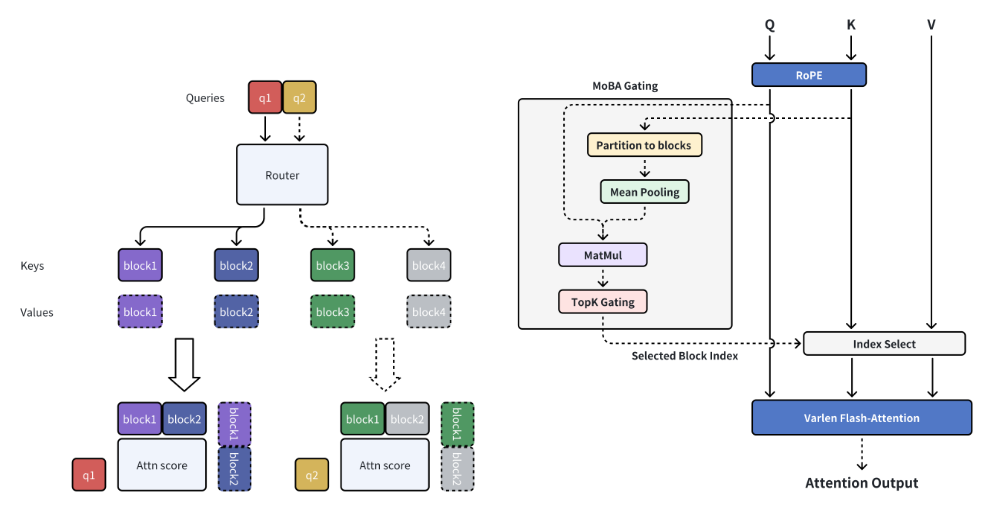

MoBA (Mixture of Block Attention)はMoonshotAIによって開発された革新的なアテンションメカニズムであり、長い文脈を処理する大規模言語モデル(LLM)のために設計されています。MoBAは完全な文脈を複数のブロックに分割することで効率的な長いシーケンス処理を実現し、各クエリトークンは最も関連性の高いKVブロックにフォーカスするように学習します。MoBAはフルアテンションモードとスパースアテンションモードをシームレスに切り替えることができ、性能と効率の両方を保証する。MoBAは、フルアテンションモードとスパースアテンションモードをシームレスに切り替えることができ、性能と効率を保証する。この技術は、Kimiが有効な長いコンテキスト要求に適用することに成功し、効率的なアテンション計算の大きな進歩を実証した。

機能一覧

- ブロック・スパース・アテンション完全なコンテキストをチャンクに分割し、各クエリトークンは最も関連性の高いKVチャンクにフォーカスするように学習する。

- パラメーターフリーのゲート機構各クエリトークンに対して最も関連性の高いブロックを選択する、パラメータフリーのtop-kゲーティングメカニズムを導入。

- 完全なスパース・アテンション・スイッチングフルアテンションモードとスパースアテンションモードをシームレスに切り替え可能。

- 効率的なコンピューティング長いコンテキストのタスクの計算効率を大幅に改善。

- オープンソース使いやすさと二次開発のために、完全なオープンソースコードが提供されています。

ヘルプの使用

設置プロセス

- 仮想環境を作る:

conda create -n moba python=3.10

conda activate moba

- 依存関係をインストールします:

pip install .

クイックスタート

トランスフォーマーと互換性のあるMoBA実装を提供します。ユーザーは--attnこのパラメータは、アテンションバックエンドを moba と moba_naive から選択する。

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

詳細な機能操作の流れ

- ブロック・スパース・アテンション長いコンテキストを処理する場合、MoBAは完全なコンテキストを複数のチャンクに分割し、各クエリトークンは最も関連性の高いKVチャンクにフォーカスするように学習する。

- パラメーターフリーのゲート機構MoBAは、各クエリトークンに対して最も関連性の高いブロックを選択するパラメータフリーのtop-kゲーティングメカニズムを導入し、モデルが最も情報量の多いブロックにのみフォーカスすることを保証する。

- 完全なスパース・アテンション・スイッチングMoBAは、フルアテンションモードとスパースアテンションモードの間のシームレスな切り替えを可能にし、パフォーマンスと効率の両方を保証する、フルアテンションに代わる柔軟なものとして設計されている。

- 効率的なコンピューティング上記のメカニズムにより、MoBAは様々な複雑な推論タスクの長いコンテキストタスクの計算効率を大幅に向上させる。

サンプルコード

以下はMoBAを使用したサンプルコードです:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)

簡単な説明

MoBAは、長い文脈処理を伴う大規模な言語モデルのために設計された革新的なブロック注意メカニズムであり、計算効率を大幅に改善し、完全なスパース注意の切り替えをサポートする。

ページキーワード

ロングコンテクスト処理、ブロックアテンションメカニズム、大規模言語モデル、効率的コンピューティング、MoonshotAI

はじめに

MoBA (Mixture of Block Attention)はMoonshotAIによって開発された革新的なアテンションメカニズムであり、長い文脈を処理する大規模言語モデル(LLM)のために設計されています。MoBAは完全な文脈を複数のブロックに分割することで効率的な長いシーケンス処理を実現し、各クエリトークンは最も関連性の高いKVブロックにフォーカスするように学習します。MoBAはフルアテンションモードとスパースアテンションモードをシームレスに切り替えることができ、性能と効率の両方を保証する。MoBAは、フルアテンションモードとスパースアテンションモードをシームレスに切り替えることができ、性能と効率を保証する。この技術は、Kimiが有効な長いコンテキスト要求に適用することに成功し、効率的なアテンション計算の大きな進歩を実証した。

機能一覧

- ブロック・スパース・アテンション完全なコンテキストをチャンクに分割し、各クエリトークンは最も関連性の高いKVチャンクにフォーカスするように学習する。

- パラメーターフリーのゲート機構各クエリトークンに対して最も関連性の高いブロックを選択する、パラメータフリーのtop-kゲーティングメカニズムを導入。

- 完全なスパース・アテンション・スイッチングフルアテンションモードとスパースアテンションモードをシームレスに切り替え可能。

- 効率的なコンピューティング長いコンテキストのタスクの計算効率を大幅に改善。

- オープンソース使いやすさと二次開発のために、完全なオープンソースコードが提供されています。

ヘルプの使用

設置プロセス

- 仮想環境を作る:

conda create -n moba python=3.10

conda activate moba

- 依存関係をインストールします:

pip install .

クイックスタート

トランスフォーマーと互換性のあるMoBA実装を提供します。ユーザーは--attnこのパラメータは、アテンションバックエンドを moba と moba_naive から選択する。

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

詳細な機能操作の流れ

- ブロック・スパース・アテンション長いコンテキストを処理する場合、MoBAは完全なコンテキストを複数のチャンクに分割し、各クエリトークンは最も関連性の高いKVチャンクにフォーカスするように学習する。

- パラメーターフリーのゲート機構MoBAは、各クエリトークンに対して最も関連性の高いブロックを選択するパラメータフリーのtop-kゲーティングメカニズムを導入し、モデルが最も情報量の多いブロックにのみフォーカスすることを保証する。

- 完全なスパース・アテンション・スイッチングMoBAは、フルアテンションモードとスパースアテンションモードの間のシームレスな切り替えを可能にし、パフォーマンスと効率の両方を保証する、フルアテンションに代わる柔軟なものとして設計されている。

- 効率的なコンピューティング上記のメカニズムにより、MoBAは様々な複雑な推論タスクの長いコンテキストタスクの計算効率を大幅に向上させる。

サンプルコード

以下はMoBAを使用したサンプルコードです:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)