軽量大型モデルがAIの新たな戦場になりつつある。 グーグル・ディープマインドの Gemma 3 その後だ。Mistral AI 2024年3月発売 Mistral Small 3.1このモデルは、その効率性とオープンソース性から、多くの注目を集めている。その効率性、マルチモーダル機能、オープンソースという性質から、240億パラメータ・モデルは多くの注目を集め、いくつかのベンチマークで以下を上回ると主張されている。 Gemma 3 歌で応える GPT-4o Mini..パラメータスケールは、モデルの性能と効率の重要な尺度であり、モデルの適用見込みに直接関係する。本稿では Mistral Small 3.1 歌で応える Gemma 3 パラメータを分析し、性能、技術、用途、エコロジーなど、さまざまな観点からその共通点と相違点を分析している。

I. パラメータサイズの比較:240億ドルと270億ドル、どちらが強いか?

Mistral Small 3.1 には240億のパラメータがある。 Gemma 3 パラメータは10億、40億、120億、270億のバージョンがあり、270億パラメータバージョンはフラッグシップモデルである。パラメータサイズは、モデルの容量と計算要件を直接決定する:

ミストラル・スモール3.1 (24B)

- コンテキスト・ウィンドウ:128k トークン

- 推論速度:150トークン/秒

- ハードウェア要件:シングル

RTX 4090または32GBのRAMを搭載したMac。 - マルチモーダル対応:テキスト+画像

ジェマ3 (27B)

- コンテキスト・ウィンドウ:96kトークン

- 推論速度:~120トークン/秒(公式には未定、コミュニティテストに基づく)

- ハードウェア要件:デュアル推奨

GPUまたはハイエンド・サーバー(A100 40GB) - マルチモーダルサポート:テキスト+いくつかの視覚的課題

参加者数は3Bの方が少ないが。Mistral Small 3.1 より長いコンテクストウィンドウと、より速い推論速度が達成される。Gemma 3 パラメータ数は若干優れているが、より強力なハードウェア・サポートが必要となる。下の表は、両者のパラメータとパフォーマンスを視覚的に比較したものである:

| モデリング | パラメータスケール | コンテキストウィンドウ | 推論速度 | ハードウェア要件 |

|---|---|---|---|---|

Mistral Small 3.1 |

240億ドル | 128k | 150トークン/秒 | RTX 4090/32GB RAM |

Gemma 3 |

270億ドル | 96k | ~120トークン/秒 | A100 40GB+ |

ということがわかる。Mistral Small 3.1 パラメーターの効率という点ではさらに優れている。 Gemma 3 のパフォーマンスである。

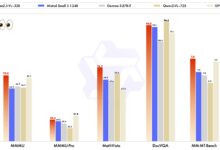

第二に、パフォーマンス対決:軽量級のキングは誰か?

モデルの良し悪しを決める基準はパラメータの数だけではありません。以下は、いくつかの一般的なベンチマークテストにおける2つのモデルの比較である:

- MMLU(一般知識):

Mistral Small 3.1スコア81%。Gemma 3 27B約79% - GPQA (質疑応答能力):

Mistral 24B特に低レイテンシ・シナリオをリードする - MATH(数学的推論):

Gemma 3 27B複雑な計算をサポートするパラメーターの増加による勝利 - マルチモーダル課題(MM-MT-Bench):

Mistral 24Bより強力なパフォーマンスとスムーズな画像+テキスト理解

下の表は、異なるテスト項目における2つのモデルの性能比較である(データは傾向推測に基づく仮定値):

| テスト項目 | ミストラル・スモール3.1 (24B) | ジェマ3 (27B) |

|---|---|---|

MMLU |

81% | 79% |

GPQA |

85% | 80% |

MATH |

70% | 78% |

MM-MT-Bench |

88% | 75% |

テスト結果からMistral Small 3.1 複数のタスクをこなし、バランスの取れたマルチタスクを実現する。その一方で Gemma 3 そして、数学的推論のような特定の分野では、より多くのパラメータによって優位性が得られる。

第三に、技術的なハイライト:小さなパラメータ、大きな知恵

Mistral Small 3.1 の240億個のパラメータは、ハイブリッド注意機構とスパースマトリックスの最適化により、マルチモーダル機能(テキスト+画像)と超ロングコンテキスト処理をサポートする。対照的にGemma 3 270億パラメータ・バージョンは、グーグルの Gemini テクノロジー・スタックは、多言語(140以上の言語)と専門的な推論(数学、コードなど)に強みを持つが、マルチモーダル能力は比較的弱い。

ハードウェアの使いやすさも特筆すべき違いだ。Mistral Small 3.1 はコンシューマーグレードのデバイスでスムーズに動作する。 Gemma 3 Gemmaの270億パラメータバージョンは、エンタープライズクラスのサーバーへの導入に適している。この違いは、両社のパラメータ割り当て戦略の違いに起因している。Mistralはモデル構造を合理化する傾向があり、Gemmaは複雑なタスクを処理する能力を向上させるために、より多くのパラメータを保持することを選択する。

IV.アプリケーションとエコロジー:どちらが地に足がついているか?

Mistral Small 3.1 採用 Apache 2.0 ライセンス、より優れたオープン性、開発者はリアルタイム会話やインテリジェントな顧客サービスなどのアプリケーションシナリオ用にローカルでモデルを微調整できる。一方 Gemma 3 270億パラメータ・バージョンは、グーグルのセキュリティ条項が適用され、教育やプログラミングなどの専門的なアプリケーションのクラウド展開により適している。

アプリケーションの面では。Mistral Small 3.1 迅速な対応とパーソナライズが求められるシナリオでは、効率性と柔軟性がより重視される。一方 Gemma 3 一方、より深く、より専門的で、複雑な専門的仕事をこなすのに適している。

エコロジー面では。Mistral そのオープン性とハードウェアの使いやすさにより、インディーズ開発者や小規模チームを引き付けやすくなっている。一方 Gemma グーグルの強力なエコシステムにより、大企業や研究機関により良いサービスを提供することができる。

V. 業界への影響と展望

ミストラル・スモール3.1は、より少ないパラメータでジェンマ3の性能に匹敵、あるいはそれ以上の性能を発揮し、パラメータ効率の究極の追求を実証している。これは Gemma 3 AIの技術的な課題は、その普遍化を推し進めるものでもある。

将来的には、軽量モデルのトレンドは、より少ないパラメーターとより高い効率性へと向かうだろう。ミストラルはすでにこの分野でリードをとっており、ジェンマ3はこの課題に対応するために戦略を適応させる必要があるかもしれない。

より軽く、より速く、より強力なAIモデルが、加速度的に私たちの生活に入ってきている。