はじめに

Lepton AIは、効率的で信頼性が高く、使いやすいAIソリューションを開発者や企業に提供することに特化した、業界をリードするクラウドネイティブAIプラットフォームです。Lepton AIは、その強力なコンピューティング能力とユーザーフレンドリーなインターフェースを通じて、複雑なAIプロジェクトにおける迅速な着地とスケーリングの実現を支援します。

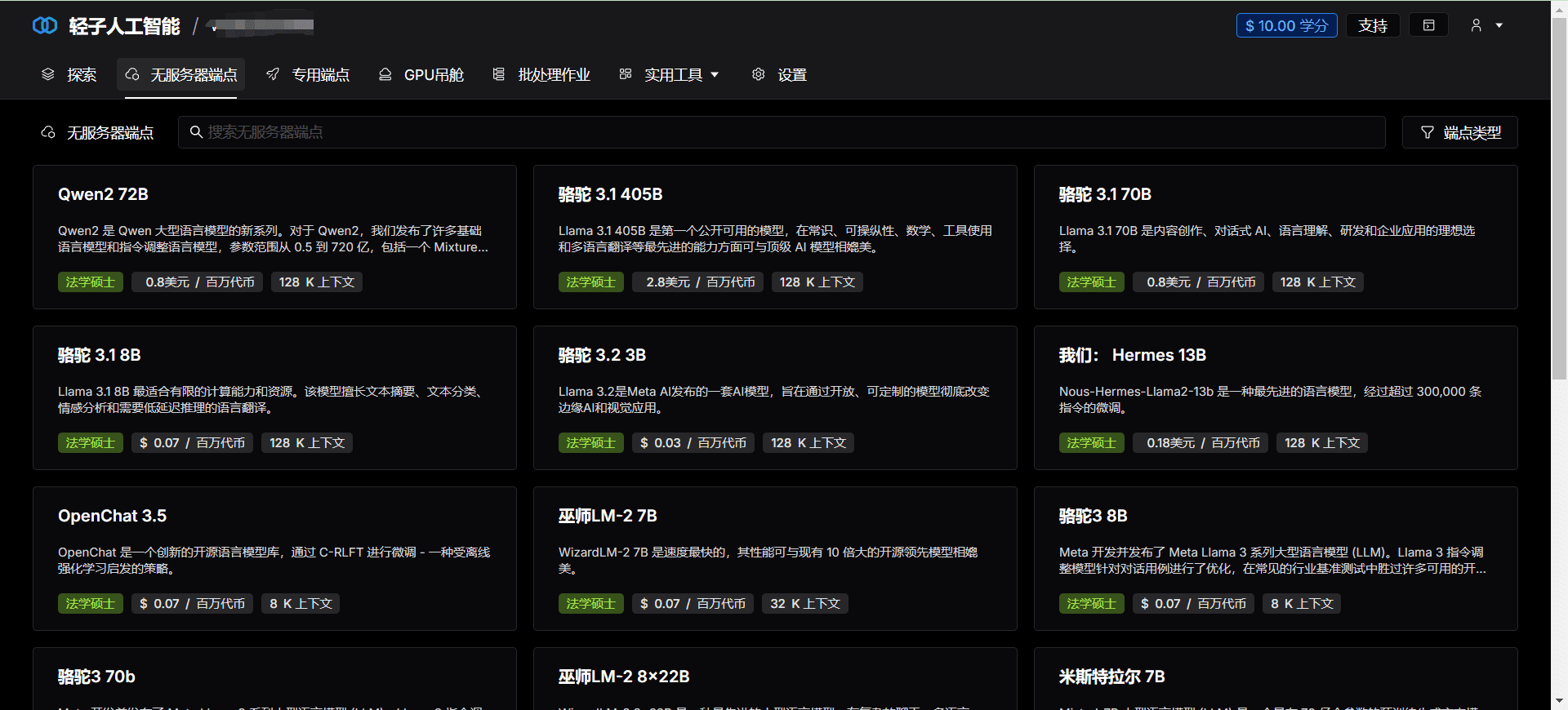

機能一覧

- 効率的なコンピューティング大規模AIモデルの学習と推論をサポートする高性能コンピューティングリソースを提供。

- クラウド・ネイティブ・エクスペリエンスクラウドコンピューティング技術とのシームレスな統合により、AIアプリケーションの開発・導入プロセスを簡素化します。

- GPUインフラAIタスクの効率的な実行を保証するために、最高のGPUハードウェアサポートを提供します。

- 迅速な展開コンテナやKubernetesを学ぶことなくモデルを迅速にデプロイできるよう、ネイティブのPython開発をサポートします。

- 柔軟なAPIあらゆるアプリケーションでAIモデルを呼び出しやすくする、シンプルで柔軟なAPIを提供します。

- 水平展開大規模なワークロードを処理するための水平スケーリングをサポートしています。

ヘルプの使用

インストールと使用

- アカウント登録Lepton AIウェブサイトにアクセスし、「登録」ボタンをクリックし、関連情報を入力して登録を完了します。

- プロジェクトを作成するログイン後、"コントロールパネル "から "プロジェクトの作成 "をクリックし、プロジェクトの名前と説明を入力します。

- コンピューティング・リソースの選択プロジェクトの設定で、GPUのタイプや数など、必要なコンピューティングリソースを選択します。

- モデルのアップロードモデル管理 "で "モデルのアップロード "をクリックし、アップロードするローカルモデルファイルを選択します。

- 設定環境環境設定」で、必要な実行環境と依存パッケージを選択します。

- 配備モデルDeploy "をクリックすると、自動的にモデルがデプロイされ、APIインターフェースが生成されます。

- APIの呼び出しAPI Documentation "では、生成されたAPIインターフェースのドキュメントを閲覧し、提供されたAPIコールモデルを推論に使用します。

ワークフロー

- モデルトレーニングモデルのトレーニングはPythonを使用してローカルで行われ、モデルが期待通りに動作することを確認する。

- モデルテストモデルの精度と安定性を検証するために、ローカルでモデルテストを行う。

- モデルのアップロード学習済みモデルをLepton AIプラットフォームにアップロードし、オンライン展開する。

- 環境設定モデルが適切に実行されるように、モデルの要件に従って実行環境と依存パッケージを設定します。

- APIコール生成されたAPIインターフェースを使用して、アプリケーションで推論モデルを呼び出し、リアルタイムで結果を取得します。

- モニタリングとメンテナンスMonitor "ページでは、メンテナンスと最適化をタイムリーに行うために、モデルの稼動状況や性能指標を見ることができます。