はじめに

II-Researcherは、Intelligent-Internetチームによって開発され、GitHubでホストされているオープンソースのAI研究ツールで、ディープサーチと複雑な推論のために設計されており、インテリジェントなウェブ検索とマルチステップ分析によって複雑な質問に答えることができます。2025年3月27日にリリースされたこのプロジェクトは、複数の検索・クローリングツール(Tavily、SerpAPI、Firecrawlなど)をサポートし、さまざまなAIモデルを呼び出すためにLiteLLMを統合している。ユーザーはコードを無料で入手し、自分で導入したり変更したりすることができる。これは、研究者や開発者、その他効率的な情報処理を必要とする人々に適している。その核心は、オープンソース、設定可能、非同期操作にあり、透明性の高い研究サポートを提供する。

機能一覧

- インテリジェントなウェブ検索:経由 タヴィリー とSerpAPIで正確な情報を得ることができる。

- ウェブページのクローリングと抽出: Firecrawl、Browser、BS4、その他のツールをサポートし、コンテンツを抽出します。

- 多段階推理:問題を分解し、答えまで段階的に推理する能力。

- 設定可能なモデル:さまざまなタスク(GPT-4o、DeepSeekなど)に合わせてLLMをチューニングするためのサポート。

- 非同期オペレーション:検索と処理の効率化。

- 詳細な回答の作成:参考文献を含む包括的なレポートを提供する。

- カスタマイズされたパイプライン:ユーザーは検索と推論プロセスを調整することができます。

ヘルプの使用

設置プロセス

II-Researcherを使用するには、インストールと環境設定が必要です。以下に具体的な手順を示す:

- コードベースのクローン

ターミナルで以下のコマンドを入力し、コードをダウンロードする:

git clone https://github.com/Intelligent-Internet/ii-researcher.git

cd ii-researcher

- 依存関係のインストール

このプロジェクトにはPython 3.7+が必要です。以下のコマンドを実行して、依存関係をインストールしてください:

pip install -e .

- 環境変数の設定

必要なAPIキーとパラメータを設定します。例

export OPENAI_API_KEY="your-openai-api-key"

export TAVILY_API_KEY="your-tavily-api-key"

export SEARCH_PROVIDER="tavily"

export SCRAPER_PROVIDER="firecrawl"

オプションの設定(圧縮または推論用):

export USE_LLM_COMPRESSOR="TRUE"

export FAST_LLM="gemini-lite"

export STRATEGIC_LLM="gpt-4o"

export R_TEMPERATURE="0.2"

- LiteLLMローカルモデルサーバーの実行

LiteLLMをインストールする:

pip install litellm

設定ファイルの作成 litellm_config.yaml::

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_key: ${OPENAI_API_KEY}

- model_name: r1

litellm_params:

model: deepseek-reasoner

api_key: ${OPENAI_API_KEY}

litellm_settings:

drop_params: true

サーバーを起動します:

litellm --config litellm_config.yaml

デフォルトは http://localhost:4000.

- Dockerデプロイメント(オプション)

環境変数を設定したら、実行する:

docker compose up --build -d

サービス住所

- フロントエンド

http://localhost:3000 - バックエンドAPI:

http://localhost:8000 - LiteLLM:

http://localhost:4000

主な機能

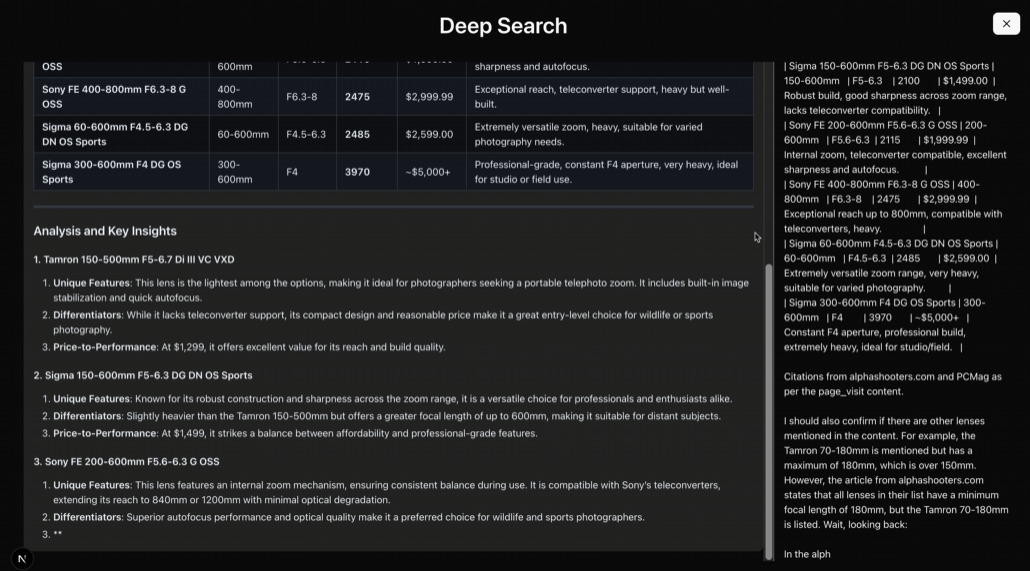

インテリジェント・ディープ・サーチ

- 手続き::

- コマンドラインから実行する:

python cli.py --question "AI如何改善教育质量?"

- システムはTavilyまたはSerpAPIを呼び出して検索し、結果を返す。

- 機能説明マルチソース検索をサポートし、複雑な問題に適しています。

多段推理

- 手続き::

- 推論モデルを使う:

python cli.py --question "AI在教育中的优缺点" --use-reasoning --stream

- システムは段階的に分析し、結論を出力する。

- 機能説明論理的な推論を必要とする仕事をこなせる。

ウェブクローラー

- 手続き::

- コンフィグ

SCRAPER_PROVIDER="firecrawl"とAPIキー。 - ウェブコンテンツを自動的にクロールする検索タスクを実行する。

- 機能説明複数のクロールツールをサポートし、包括的なコンテンツを確保。

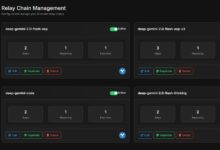

ウェブ・インターフェースの使用

- 手続き::

- バックエンドAPIを起動する:

python api.py

- 入る

frontendフォルダにインストールし、フロントエンドを実行する:

npm install

npm run dev

- インタビュー

http://localhost:3000入力の問題。

- 機能説明より直感的な操作を可能にするグラフィカル・インターフェースを提供。

ほら

- APIへのアクセスには安定したネットワーク接続が必要です。

- ハードウェア要件:基本機能には8GB RAM、大規模モデルの推論には16GB以上とGPUを推奨。

- ログチェック:ログをチェックするには

docker compose logs -f走行状況を確認する。 - タイムアウト設定:デフォルトの検索タイムアウト300秒、調整可能

SEARCH_PROCESS_TIMEOUT.

これらのステップにより、ユーザーはII-Researcherを検索から推論までの全プロセスに簡単に導入し、使用することができます。

アプリケーションシナリオ

- 学術研究

研究者は文献検索、データ分析、レポート作成に利用できる。 - 技術開発

開発者は、このフレームワークに基づいてカスタマイズされた検索ツールを開発することができる。 - 教材

生徒は情報を整理したり、質問に答えたりするのに使うことができる。 - 市場分析

企業はこれを利用して業界情報を収集し、トレンド分析を行うことができる。

品質保証

- II-Researcherは無料ですか?

そう、これはオープンソースのプロジェクトで、ユーザーはコードを無料で利用できる。 - プログラミングの基礎が必要ですか?

Python操作の基本的な知識が必要だが、ドキュメントは初心者が始めるのに十分詳しい。 - 中国語に対応していますか?

サポートは、中国のタスクを処理するために適切なモデルと検索ツールを設定します。 - 最低限必要なハードウェアは何ですか?

基本的な機能を実行するには8GBのRAM、大きなタスクには16GB以上のRAMとGPUを推奨。