はじめに

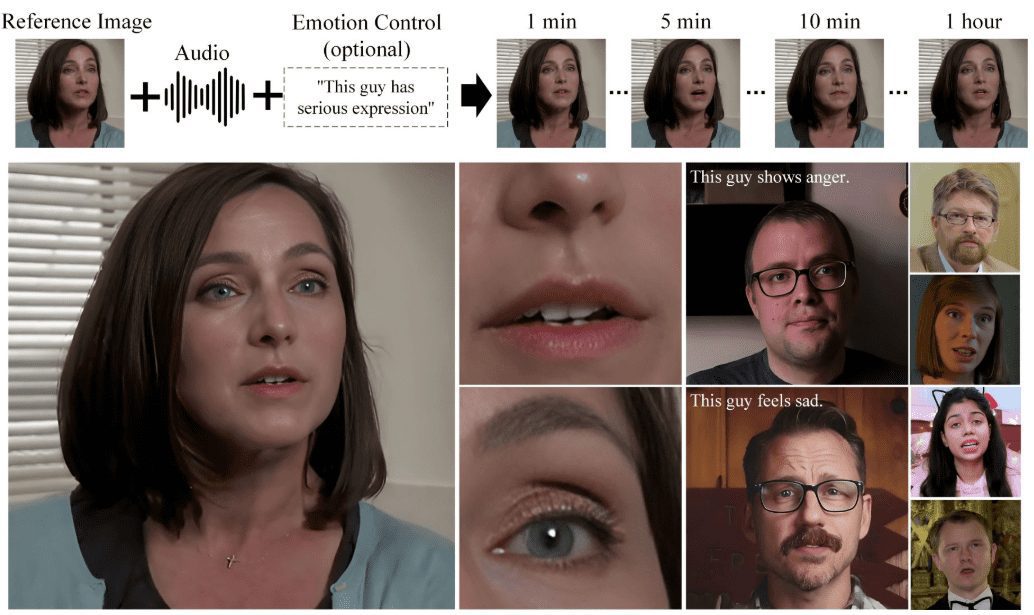

Hallo2は復旦大学と百度が共同開発したオープンソースプロジェクトで、音声駆動型の生成により高解像度のポートレートアニメーションを生成する。このプロジェクトでは、先進的なGenerative Adversarial Networks (GAN)と時間的アライメント技術を利用して、4K解像度と最大1時間のビデオ生成を実現している。Hallo2はまた、生成コンテンツの多様性と制御性を高めるために、テキストプロンプトもサポートしている。

音声信号と表情の複雑な関係を効果的に捉えるクロスアテンションメカニズムを導入することで、音声コンディショニングを可能にし、驚異的なリップシンクを実現した「Hallo3」がリリースされた。

Hallo3は、推論のための入力データに対して次のような簡単な要求をしている:

参照画像:参照画像はアスペクト比が1:1または3:2でなければなりません。 ドライバーオーディオ:ドライバーオーディオはWAVフォーマットでなければなりません。 音声言語:音声は英語でなければなりません。モデルのトレーニングデータセットにはこの言語しか含まれていないからです。 音声の明瞭さ:音声の中でボーカルが明瞭であることを確認する。

機能一覧

- オーディオ・ドリブン・アニメーション生成音声ファイルを入力して、対応する似顔絵アニメーションを生成します。

- 高解像度対応鮮明な画質を保証する4K解像度のビデオ生成に対応。

- 長時間のビデオ生成最長1時間のビデオコンテンツを作成できます。

- テキスト・アラートの強化意味的なテキストラベルを通して、生成された似顔絵の表情や動作を制御する。

- オープンソース二次開発を容易にするために、完全なソースコードと事前にトレーニングされたモデルが提供されます。

- マルチプラットフォーム対応Windows、Linuxなどのマルチプラットフォームでの動作に対応。

ヘルプの使用

設置プロセス

- システム要件::

- オペレーティングシステム:Ubuntu 20.04/22.04

- GPU: CUDA 11.8対応のグラフィックカード(A100など)

- 仮想環境の構築::

conda create -n hallo python=3.10 conda activate hallo - 依存関係のインストール::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt sudo apt-get install ffmpeg - 訓練済みモデルのダウンロード::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models

使用プロセス

- データ入力の準備::

- 必要な事前学習済みモデルをダウンロードして準備する。

- ソース・イメージとドライバー・オーディオ・ファイルを準備する。

- 推論スクリプトの実行::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - 生成された結果を見る::

- 生成されたビデオファイルは、指定された出力ディレクトリに保存され、任意のビデオプレーヤーを使用して表示することができます。

詳細な手順

- ダウンロードコード::

git clone https://github.com/fudan-generative-vision/hallo2 cd hallo2 - 仮想環境の作成と起動::

conda create -n hallo python=3.10 conda activate hallo - 必要なPythonパッケージをインストールする::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt - ffmpegをインストールする::

sudo apt-get install ffmpeg - 訓練済みモデルのダウンロード::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models - 推論スクリプトの実行::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - 生成された結果を見る::

- 生成されたビデオファイルは、指定された出力ディレクトリに保存され、任意のビデオプレーヤーを使用して表示することができます。