はじめに

falはオンラインAI推論プラットフォームであり、画像、動画、音声を含む高品質な生成メディアモデルを用いてリアルタイムAIアプリケーションを構築することができます。falは、Stable Diffusion XL、Stable Diffusion with LoRAs、Optimised Latent Consistency (SDv1.5)など、様々な訓練済み生成モデルを提供しており、ユーザーは簡単なテキスト記述や落書きスケッチを使用して、素早く画像を生成することができます。画像を素早く生成することができます。

falは、GPU-A100、GPU-A10G、GPU-T4など、さまざまなマシンのタイプや仕様をサポートしており、さまざまなパフォーマンスやコスト要件を満たすことができます。falには詳細なドキュメントとサンプルが用意されており、ユーザーがすぐに使い始めることができます。

fal.aiは2021年に設立され、サンフランシスコに本社を置き、推論のスピードと効率を最適化することで、クリエイティブな表現の障壁を下げることに専念している。

機能一覧

- 効率的な推論エンジン最大400%の推論速度を持つ、世界最速の拡散モデル推論エンジンを提供します。

- 複数の世代モデルStable Diffusion 3.5やStable Diffusion 3.5など、事前にトレーニングされた様々な生成モデルをサポートしています。 フラックス.1.

- LoRAトレーニング: 業界最高のLoRAトレーニングツールを提供し、5分以内に新しいスタイルをパーソナライズまたはトレーニングできる。

- APIの統合JavaScript、Python、Swiftなど、さまざまなクライアント側ライブラリが用意されており、開発者が簡単に統合できる。

- オンライン推論リアルタイムのクリエイティブツールやカメラ入力のためのメディア推論のリアルタイム生成に対応。

- コスト最適化費用対効果の高い計算を保証するために、使用量に応じた支払い。

ヘルプの使用

インストールと統合

- アカウント登録fal.aiにアクセスし、デベロッパーアカウントにサインアップしてください。

- APIキーの取得ログイン後、"API Key "ページでAPIキーを生成・取得してください。

- クライアント・ライブラリのインストール::

- ジャバスクリプト::

import { fal } from "@fal-ai/client"; const result = await fal.subscribe("fal-ai/fast-sdxl", { input: { prompt: "photo of a cat wearing a kimono" }, logs: true, onQueueUpdate: (update) => { if (update.status === "IN_PROGRESS") { update.logs.map((log) => log.message).forEach(console.log); } }, }); - パイソン::

from fal import Client client = Client(api_key="YOUR_API_KEY") result = client.subscribe("fal-ai/fast-sdxl", input={"prompt": "photo of a cat wearing a kimono"}) print(result) - スウィフト::

import FalAI let client = FalClient(apiKey: "YOUR_API_KEY") client.subscribe(model: "fal-ai/fast-sdxl", input: ["prompt": "photo of a cat wearing a kimono"]) { result in print(result) }

- ジャバスクリプト::

生成モデルの使用

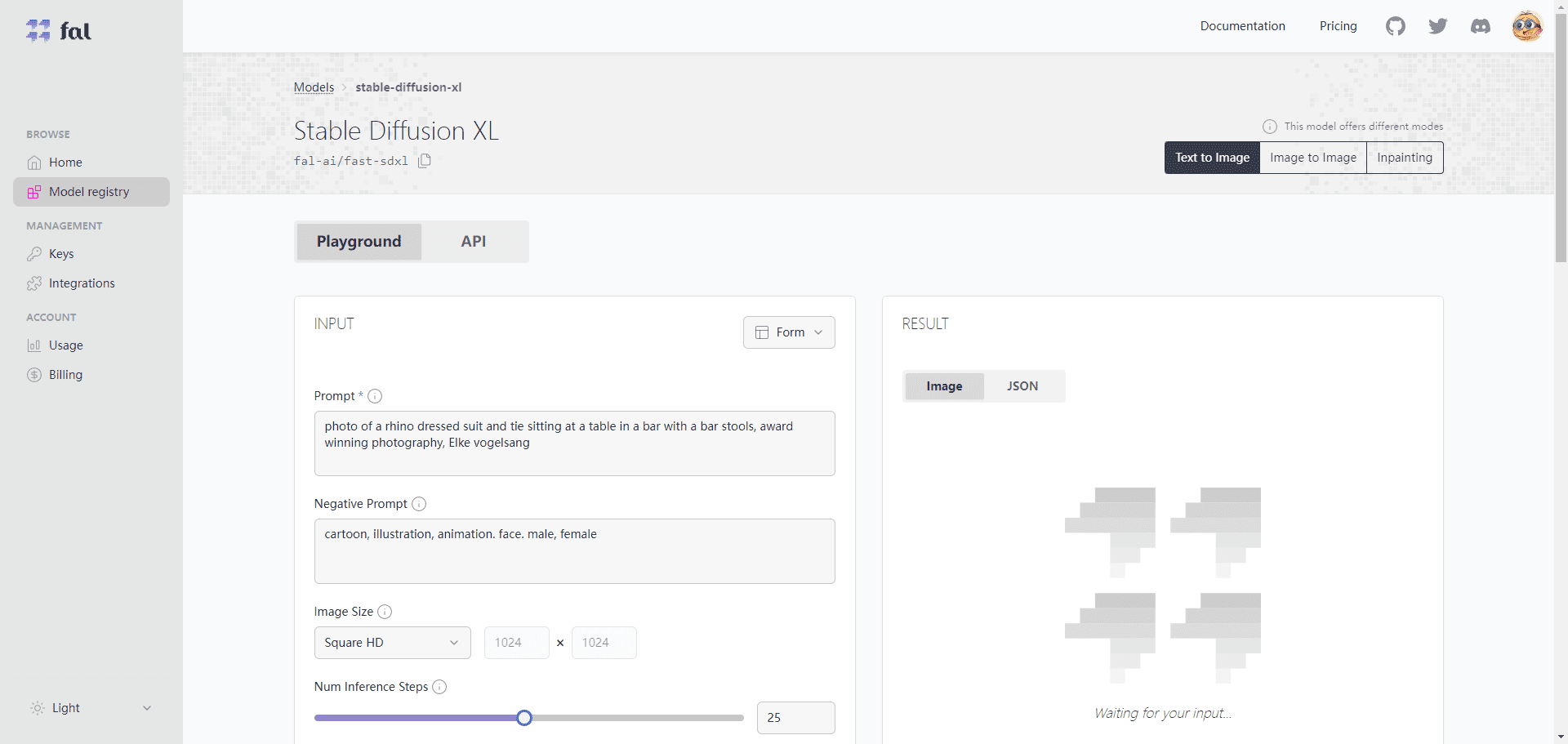

- モデルを選択: fal.aiのモデルライブラリから、Stable Diffusion 3.5やFLUX.1など、プロジェクトに適したモデルを選択します。

- 設定パラメータ推論ステップ数、入力画像サイズなどのモデルパラメータを、プロジェクトの要件に応じて設定します。

- 走り推理APIコールを使用して推論を実行し、生成されたメディアコンテンツを取得します。

- 最適化と調整生成された結果に基づいて、パラメータを調整するか、最適化のために別のモデルを選択します。

LoRAトレーニング

- データのアップロードトレーニングデータを準備し、fal.aiプラットフォームにアップロードします。

- トレーニングモデルの選択FLUX.1のような適切なLoRAトレーニングモデルを選択する。

- トレーニングパラメータの設定学習率、学習ステップ数などの学習パラメータを設定します。

- トレーニング開始トレーニングプロセスを開始すると、プラットフォームはトレーニングを完了し、短時間で新しいスタイルモデルを生成します。

- 新モデルの適用パーソナライズされたメディアコンテンツを生成するために、新しく学習されたモデルを使用した推論。

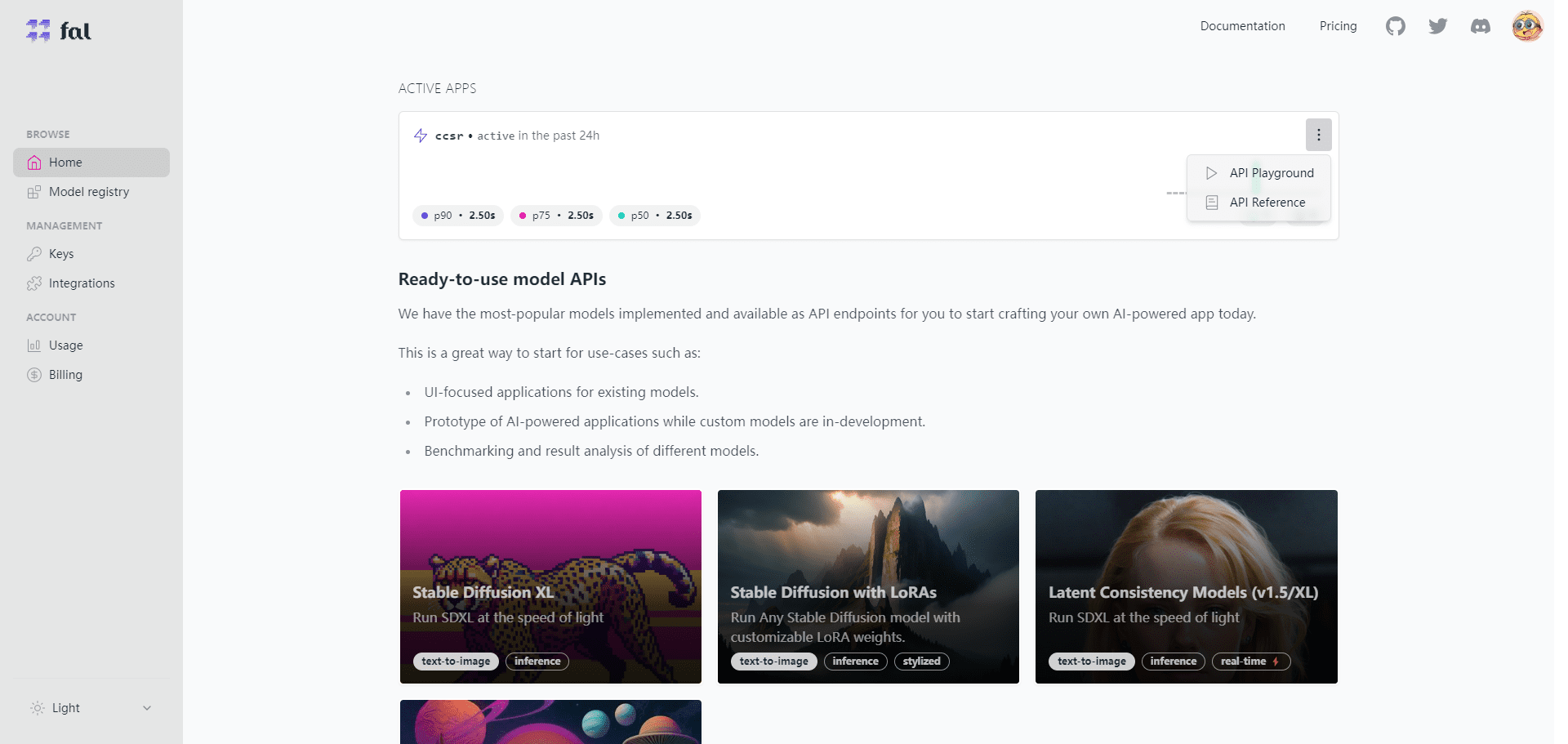

すべてのモデルは、デバッグインターフェイスとAPIの2つの部分に分かれており、コールAPIで問題なくデバッグインターフェイスを使用することができます:

fal オプションモデル

| モデル名 | モデルの紹介 | モデルカテゴリー | 詳細説明 |

| LoRAによる安定した拡散 | カスタムLoRA重みで安定拡散モデルを実行する | テキストから画像へ | LoRAは、異なるウェイトを調整することで、得られる画像のスタイルとディテールをコントロールし、画像の品質と多様性を高めるために使用されるテクニックである。 |

| 安定した拡散XL | 光の速さでSDXLを実行する | テキストから画像へ | SDXLは拡散モデルに基づく画像生成手法であり、少ない推論ステップで高品質な画像を生成し、従来のGAN手法よりも高速で安定している |

| 安定したカスケード | より小さく、より安価な潜在的スペースでのイメージ生成 | テキストから画像へ | Stable Cascadeは、潜在空間の複数のレイヤーを利用して、低計算コストで高解像度の画像を生成する画像生成手法で、モバイル機器やエッジコンピューティングに適している |

| クリエイティブ・アップスケーラー | クリエイティブな拡大画像の作成 | イメージ間 | クリエイティブアップスケーラーとは、画像のシャープネスを維持したまま、テクスチャ、色、形などのクリエイティブな要素を追加するために、画像の拡大に使用される方法です。 |

| CCSRアップスケーラー | 最先端の画像アンプ | イメージ間 | CCSR Upscalerはディープラーニングに基づく画像拡大手法で、ぼかしや歪みを発生させることなく、画像を元の解像度の4倍以上に拡大することができる |

| フォトメーカー | IDエンベッドを重ねてリアルなキャラクター写真をカスタマイズ | イメージ間 | PhotoMakerは、さまざまなIDの埋め込みを調整することで、キャラクターの外見、表情、ポーズ、背景などをコントロールし、リアルなキャラクター写真を生成する手法です |

| ウィスパー | ウィスパーは音声書き起こし翻訳モデル | 音声テキスト | WhisperはエンドツーエンドのTransformerベースの音声認識・翻訳モデルで、異なる言語の音声をワンステップでテキストに変換し、複数の言語や方言をサポートします。 |

| 潜在的一貫性(SDXL および SDv1.5) | 最小限の推論ステップで高品質の画像を生成 | テキストから画像へ | 潜在的一貫性とは、潜在的な空間的一貫性と解釈可能性を維持しながら、より少ない推論ステップで高品質の画像を生成することにより、画像生成の効率と品質を向上させるために使用される技術である。 |

| 最適化された潜在的一貫性(SDv1.5) | 最小限の推論ステップで高品質の画像を生成。入力画像サイズ512×512に最適化 | イメージ間 | Optimized Latent Consistencyは、潜在空間の一貫性と解釈可能性を維持しながら、より少ない推論ステップで高品質の画像を生成するために、特定の入力画像サイズに対して最適化された画像生成手法である。 |

| フーフォーカス | 自動最適化と品質向上のためのデフォルト・パラメーターの使用 | テキストから画像へ | Fooocusは、ユーザーがパラメータを調整することなく高品質の画像を生成できる画像生成方法であり、自動最適化および品質向上技術を使用して生成された結果を向上させます。 |

| インスタントID | ゼロサンプルによる同一性保持生成 | イメージ間 | InstantIDは、アイデンティティを保持した画像を生成するための手法であり、ユーザーは学習データなしに、元の画像と同じアイデンティティを持つ画像を生成することができるが、髪型、服装、背景などの他の属性を変更することができる。 |

| アニメイトディフ | AnimateDiffでアイデアをアニメーション化! | テキストからビデオへ | AnimateDiffは、ユーザーがテキスト説明を入力することで短いビデオクリップを生成できるアニメーション生成メソッドで、カートゥーン、リアル、抽象など様々なスタイルやテーマをサポートしています! |

| アニメイトディフ ビデオからビデオへ | AnimateDiffで動画にスタイルを加える | ビデオ・ツー・ビデオ | AnimateDiff Video to Videoは、ビデオスタイル変換のためのメソッドであり、ユーザーはビデオとスタイルの説明を入力することにより、新しいビデオを生成することができます! |

| メタボイス | MetaVoice-1Bは、TTS(テキスト音声合成)用の12億パラメータのベースモデルで、10万時間の音声でトレーニングされています。 | 音声合成 | MetaVoiceは、ユーザーがテキストを入力することで、さまざまな言語や音声の音声を生成できる音声生成方法で、複数の言語や方言をサポートし、ピッチ、リズム、感情などのさまざまな発声特性もサポートしている。 |

| ミュージックジェン | テキストの説明やメロディーを手がかりに、高品質の音楽を作成する | テキスト・オーディオ | MusicGenは、ユーザーがテキスト記述やメロディキューを入力することで、さまざまなスタイルやテーマの音楽を生成するためのメソッドで、さまざまな楽器や音色、ビート、コード、メロディなどのさまざまな音楽機能をサポートしています! |

| イリュージョン 拡散 | 映像からイリュージョンを作り出す | テキストから画像へ | 錯視拡散は、画像と錯視の説明を入力することで、新たな画像を生成できる錯視生成手法で、視覚、聴覚、触覚など複数の種類の錯視に対応している! |

| 安定した拡散 XL イメージからイメージへ | SDXLを光速で画像間で実行 | イメージ間 | Stable Diffusion XL Image to Imageは、入力画像から新しい画像を生成できる画像間変換手法で、スタイル変換、超解像、画像復元など、画像から画像への幅広いタスクをサポートします! |

| 快適 ワークフロー 遺言執行者 | ファルでの快適なワークフローの実行 | jsonから画像へ | Comfy Workflow Executorは、JSON形式のワークフローを入力して画像を生成するComfyワークフローの実行方法で、データ、モデル、操作、出力など様々なワークフローコンポーネントに対応しています! |

| セグメント何でもモデル | SAMモデル | イメージ間 | Segment Anything Modelは、画像を入力することでセグメンテーションマップを生成できる画像セグメンテーション手法であり、セマンティックセグメンテーション、インスタンスセグメンテーション、フェイスセグメンテーションなど、さまざまな画像セグメンテーションタスクをサポートする。 |

| タイニーサム | 蒸留セグメント何でもモデル TinySAM | イメージ間 | TinySAMは、Segment Anything Modelを蒸留した画像セグメンテーションのための手法であり、より小さなモデルサイズとより速い推論速度で、元のモデルと同様のセグメンテーション結果を得ることができる。 |

| ミダス深度推定 | Midasの深度推定を使った深度マップの作成 | イメージ間 | ミダス深度推定は、入力画像から深度マップを生成するための手法で、グレースケール、カラー、疑似カラーなど、さまざまな深度マップ形式をサポートしています。 |

| 背景を取り除く | 画像から背景を取り除く | イメージ間 | Remove Backgroundは、画像の背景を除去する方法であり、ユーザが画像を入力することで背景を除去した画像を生成することができ、自然風景、屋内シーン、複雑なオブジェクトなど、さまざまな背景タイプをサポートする。 |

| 高級なイメージ | 画像を任意の倍率で拡大する | イメージ間 | Upscale Imagesは、画像と拡大率を入力して新しい画像を生成できる画像拡大方法で、JPG、PNG、BMPなどさまざまな画像形式に対応しています。 |

| ControlNet SDXL | ControlNetを使用した画像生成 | イメージ間 | ControlNet SDXLは、画像と制御ベクトルを入力することで新しい画像を生成できる画像生成方法で、スタイル、カラー、シェイプなど幅広い制御ベクトルタイプをサポートしています。 |

| sdxlとsdのインペインティング | SDおよびSDXLによる画像の修復 | イメージ間 | インペインティングsdxlおよびsdは、画像とマスクを入力することで復元画像を生成できる画像復元手法であり、透かしの除去、隙間の充填、ノイズの除去など、さまざまな画像復元作業をサポートする! |

| アニメティフLCM | 潜在的コヒーレンスモデルでテキストをアニメーション化する | テキストから画像へ | Animatediff LCMは、SDXL、SDv1.5、SDv1.0など様々な潜在一貫性モデルをサポートし、テキストとフレームを入力することで短いビデオクリップを生成できるアニメーション生成手法です。 |

| Animatediff SparseCtrl LCM | 潜在的コヒーレンス・モデルでドローイングをアニメーション化する | テキストからビデオへ | Animatediff SparseCtrl LCMは、描画とフレーム数を入力することで短いビデオクリップを生成できるアニメーション生成手法で、SDXL、SDv1.5、SDv1.0など幅広い潜在一貫性モデルをサポートしています。 |

| コントロール 安定したビデオ 拡散 | 画像から短いビデオクリップを生成 | イメージ間 | Controlled Stable Video Diffusionは、画像と制御ベクトルを入力することで、短いビデオクリップを生成することができる動画生成手法であり、動き、角度、速度など複数の種類の制御ベクトルをサポートしている。 |

| マジックアニメイト | モーションシーケンスから短いビデオクリップを生成 | イメージ間 | Magic Animateは、画像とモーションシーケンスを入力することで、短いビデオクリップを生成できるビデオ生成手法で、テキスト、アイコン、ジェスチャーなど、さまざまなモーションシーケンス形式をサポートしています! |

| スワップ・フェイス | 2つの画像の顔を入れ替える | イメージ間 | スワップ・フェイスは、2つの画像を入力することで新しい画像を生成できる顔の入れ替え方法で、人物、動物、漫画など幅広い種類の画像をサポートしています。 |

| IPアダプター Face ID | 高品質ゼロサンプル名入れ | イメージ間 | IPアダプター Face IDは、パーソナライズされた画像を生成する方法であり、ユーザーは画像とパーソナライズされた説明を入力することで新しい画像を生成することができる。 |