近年、ラージ・ランゲージ・モデリング(LLM)技術はかつてない勢いで成長し、様々な業界に徐々に浸透しています。同時に、LLMのローカル展開に対する需要も高まっています。ollamaは、便利なローカル大規模モデル展開ツールとして、その使いやすさと、以下のような能力でよく知られています。 ディープシーク などの高度なモデルが開発者や技術愛好家に支持されている。

しかし、技術的な利便性を追求する一方で、セキュリティリスクは見過ごされがちだ。ユーザーの中には、ローカルに オーラマ サービス開始後、不適切な設定やセキュリティ意識の低下により、Ollama サービスのポートがインターネットに公開される可能性があり、潜在的なセキュリティリスクの基盤が構築される。本稿では、このセキュリティリスクを最初から最後まで分析し、対応する予防策を提示する。

1.オッラマの利便性と潜在的な安全上の危険性

Ollamaの登場により、大規模な言語モデルのローカル展開や利用の障壁が下がり、ユーザーはDeepSeekのような高性能モデルをPCやサーバー上で簡単に実行できるようになった。この利便性は多くのユーザーを惹きつけているが、同時に無視できない問題も生み出している:Ollamaサービスは、デフォルトの設定では、インターネットによる不正アクセスの危険性があります。

具体的には、リスニング・アドレスの制限やファイアウォール・ルールの設定など、必要なセキュリティ設定を行わずに Ollama サービスを導入した場合、Ollama がデフォルトでリッスンしているポート 11434 が公開されてしまう可能性があります。これは、インターネット・ユーザが誰でもネットワーク経由で Ollama サービスにアクセスできることを意味します。コンピューティングリソースをタダで使うことは、より深刻なセキュリティ問題を引き起こす可能性さえある。

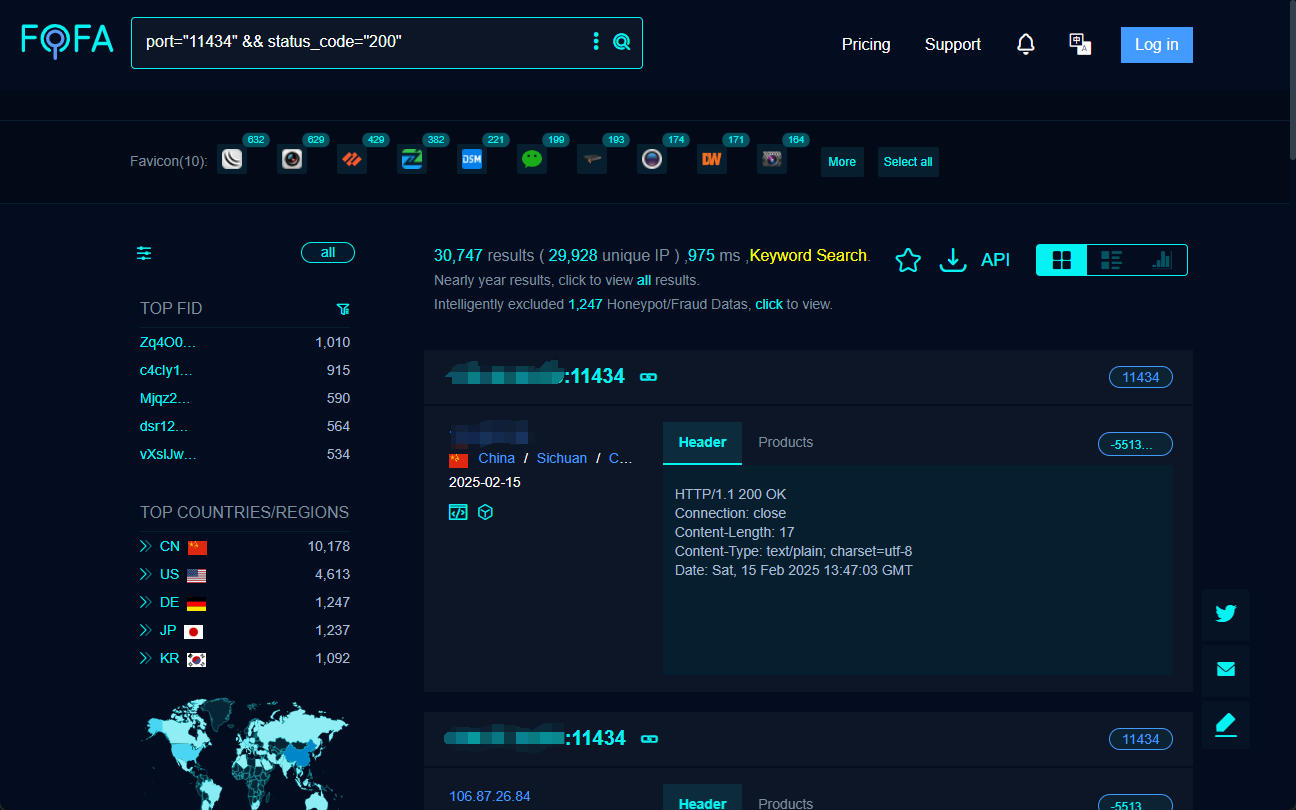

2.インターネット上でOllamaのサービスを発見するには?-- FOFAサーチエンジン

Ollamaのサービスがインターネット上でどの程度公開されているか、また潜在的なリスクの範囲を理解するためには、サイバースペースの検索エンジンの助けが必要だ。外務省 これは、世界中で一般に公開されているウェブサービスを素早く検索し、見つけるのに役立つ強力なツールだ。

FOFA の検索文を注意深く構成することで、Ollama のサービス・ポートをインターネットに公開しているホストを効果的に見つけることができる。例えば、以下の FOFA 検索文は、ポート 11434 が開放され、ステータスコード 200 のターゲットを見つけるために使用できる:

port="11434" && status_code="200"

上記の検索を実行すると、FOFAは、一般に公開されているOllamaサービスを実行している可能性が高い適格なターゲットIPアドレスをリストアップする。

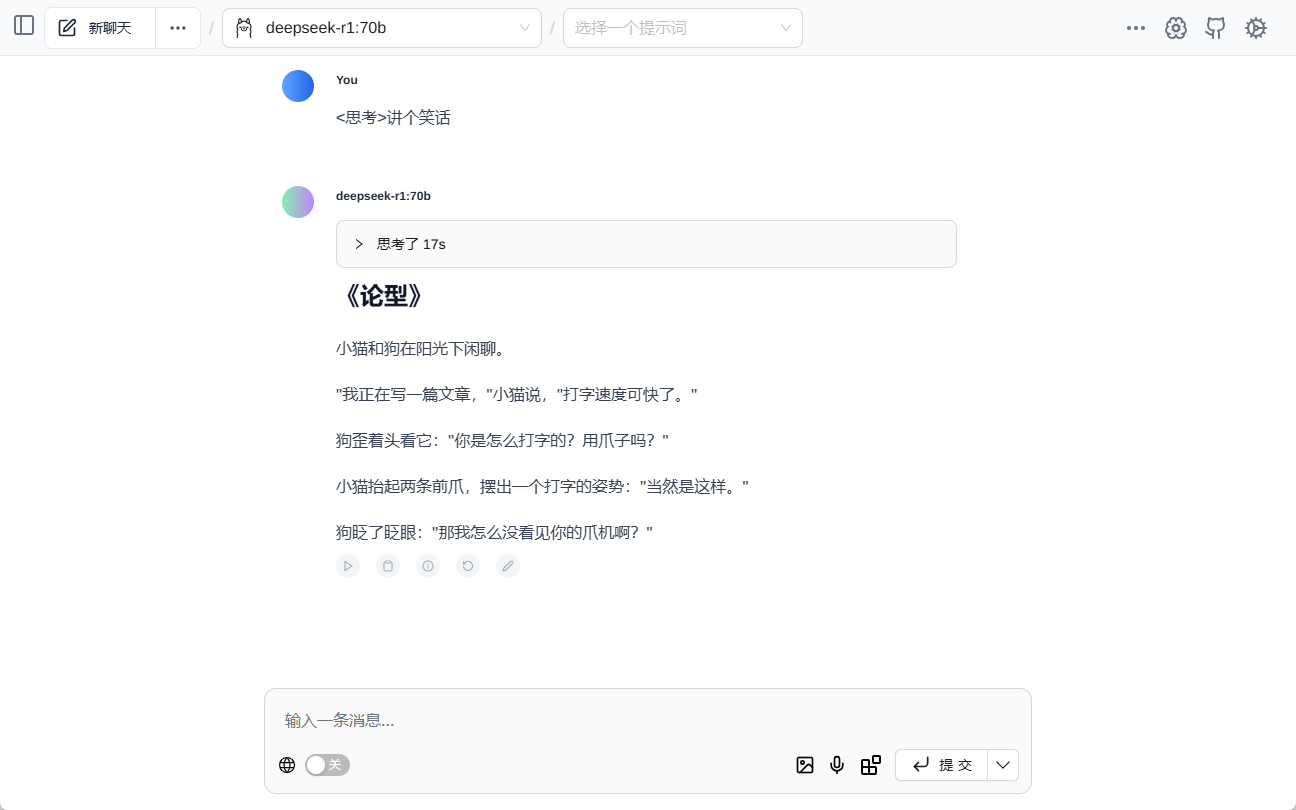

3.オープンなOllamaサービスに接続し、"売春 "するには?-- チャットボックスとチェリースタジオ

FOFAを通じてオープンなOllamaサービス・インターフェイスが見つかったら、次のステップはクライアント側のツールを使って接続し、やりとりすることだ。チャットボックス 歌で応える チェリースタジオ は一般的に使用されている2つのAIクライアント・ソフトウェアで、どちらもモデル・コールとダイアログを使ったOllamaサービスへの接続をサポートしている。

3.1 ChatBoxを使ってOpen Ollamaサービスに接続する

チャットボックス シンプルで使いやすいことで知られるOpen Ollamaサービスに接続する手順はとても簡単だ:

- ChatBoxクライアントをダウンロードしてインストールする.

- APIアドレスを設定する: ある チャットボックス の設定で、APIアドレスをターゲット・サーバーのIPアドレスとポートに設定します。

http://目标IP:11434/. - モデルを選択し、ダイアログを開始します: 設定が完了したら、モデルを選択し、リモートOllamaサービスとの対話を開始することができます。

3.2 Cherry StudioでOpen Ollamaサービスに接続する

チェリースタジオ より包括的で、対話機能に加えてナレッジベース管理などの高度な機能をサポートしている。接続の手順は以下の通り:

- Cherry Studioクライアントをダウンロードしてインストールします。.

- Ollamaインターフェイスを設定する: ある チェリースタジオ 設定」→「モデルサービス」→「Ollama」で、APIアドレスを

http://目标IP:11434. - モデルを追加し、検証する: モデル管理ページに「deepseek-r1:1.5b」のように対象モデルを追加し、接続テストを行えば、成功後に利用できるようになる。

ChatBoxやCherry Studioのようなクライアントを通して、ユーザーはインターネット上に公開されているOllamaのサービスに簡単に接続することができます。他人のコンピューティング・リソースやモデリング機能を無償で無断使用すること.

ランダムなアドレスを取得した後、Ollamaモデルの読み取りをネイティブにサポートするウェブプラグインを試してみてください。 ページアシスト ダイアログ・イン・ザ・ミドル

4.フリーランチの裏に潜むセキュリティリスク:電力盗難、データ漏洩、法的落とし穴

一見 "タダ "に見える裏側には、多くのセキュリティリスクや潜在的な法的問題が隠れている:

- 算術窃盗(資源の不正使用)。 最も直接的なリスクは、OllamaサービスプロバイダのGPUコンピューティングパワーが他者によって無償で利用され、リソースの浪費やパフォーマンスの低下を招くことです。攻撃者は自動化されたスクリプトを使用して、オープンなOllamaサービスを一括スキャンして接続し、GPUを悪意のあるモデルをトレーニングするための「搾取工場」にしてしまう可能性があります。

- データ漏洩 Ollamaサービスに機密データが保存または処理されている場合、オープンなネットワーク環境ではそのデータが漏洩する危険性があります。ユーザーの対話ログ、トレーニングデータなどが暗号化されていないチャンネルで送信され、悪意を持って盗聴されたり盗まれたりする可能性があります。

- 販売モデル 暗号化されていない模型ファイルは簡単にダウンロードされ、コピーされます。Ollamaのサービスで商業的に価値のある産業の大規模な模型が使用された場合、模型が盗まれ、販売され、多大な金銭的損失を被る危険性があります。

- システムへの侵入。 Ollamaサービス自体にセキュリティの脆弱性があり、ハッカーに悪用されると、リモートでコードが実行され、攻撃者が被害者のサーバーを完全に制御できる可能性がある。に変える大規模なサイバー攻撃に使用されるボットネットの一部。

- 法的リスク。 他人のOllamaサービスへの不正アクセスや使用、あるいは悪意ある使用は、関連法規に違反し、法的責任を問われる可能性があります。

5.中国のユーザーは安全か?-- ダイナミックIPは絶対的な障壁ではない

中国のユーザーは、独立した知的財産の保有量が少ないため、この『白色淫行』リスクから比較的安全である」と主張されてきた。 この見解はやや一面的である。

中国の家庭用ブロードバンドユーザーのうち、ダイナミックIPを使用する割合が欧米諸国と比較して高いのは事実であり、そのため暴露リスクはある程度軽減される。ダイナミックIPの不確実性により、攻撃者が特定のユーザーを長期にわたって追跡し、特定することは困難である。

しかし、これは決して中国のユーザーが安心できるという意味ではない。 第一に、中国のインターネット環境には、固定IPを含む多数のOllamaサーバーが存在する。 第二に、動的IPであっても一定期間は変更されない可能性があり、IPアドレスが変更されていないウィンドウの間に攻撃者が攻撃を実行することは可能である。 さらに重要なことがある。セキュリティーは「運」や「自然のバリア」に任せることはできず、プロアクティブなセキュリティー対策に基づくべきである。

6.現地オッラマのサービス・セキュリティ・ガイドライン:"ブロイラー "にならないために

ローカルに配置された Ollama サービスを他者による悪用から守るため、ユーザは積極的かつ効果的なセキュリティ対策を講じる必要があります。以下は初心者のためのガイドラインです:

6.1 Ollama サービスリスニングアドレスの制限

Ollamaサービスのリスニング・アドレスをデフォルトから変更する。 0.0.0.0 に変更する。 127.0.0.1大丈夫だよ。Ollamaサービスがローカルマシンからのリクエストのみをリッスンし、外部ネットワークからの直接アクセスを拒否するように強制する。 手順は以下の通り:

- 設定ファイルを探す: Ollamaの設定ファイルは通常

/etc/ollama/config.conf..そのファイルを開き(存在しない場合は作成し)、次の行を見つけるか追加する。bind_address設定項目。 - バインディングアドレスを変更する: そうしれいかん

bind_addressの値に設定される。127.0.0.1そしてportに設定する。11434.完全な設定例を以下に示す:bind_address = 127.0.0.1 port = 11434 - 保存してサービスを再起動する: 設定ファイルを保存した後

sudo systemctl restart ollamaコマンドを使用してOllamaサービスを再起動し、設定を有効にします。

6.2 ファイアウォールルールの設定

ファイアウォールルールを設定することでOllamaサービスへのアクセスを許可するIPアドレスとポートの範囲を正確に制御します。 例えば、LAN上のIPアドレスにのみポート11434へのアクセスを許可し、パブリックネットワークからのアクセス要求をすべてブロックすることができます。 以下では、Windows環境とLinux環境それぞれのファイアウォールの設定方法について説明します:

Windows環境の設定手順:

- 高度なセキュリティ Windows Defender ファイアウォールをオンにします: コントロールパネル」の「システムとセキュリティ」から「Windows Defenderファイアウォール」をクリックし、「詳細設定」を選択します。詳細設定」を選択します。

- 新しい受信ルールを作成する: Inbound Rules "で "New Rule... "をクリックし、"Port "ルールタイプを選択し、"Next "をクリックする。次へ」をクリックします。

- ポートとプロトコルを指定する: プロトコルは "TCP "を選択し、特定のローカルポートを

11434次へ」をクリックする。 - 操作を選択します: 接続を許可する」を選択し、「次へ」をクリックします。

- スコープを設定する(オプション): 必要に応じてルール・スコープを設定することができますが、通常はデフォルト設定のまま、[Next]をクリックします。

- 名前と説明を指定する: ルールにわかりやすい名前を付け(例:"Ollama Service Port Restriction")、説明を追加し(オプション)、"Finish "をクリックしてルールの作成を完了します。

Linux 環境(例えば ufw ファイアウォール) 設定手順:

- ufwファイアウォールを有効にする: ufwがまだ有効になっていない場合は、ターミナルで以下を実行する。

sudo ufw enableコマンドでファイアウォールを有効にする。 - LANアクセスを許可する: はこびだす

sudo ufw allow from 192.168.1.0/24 to any port 11434コマンドを使うことができる。192.168.1.0/24LAN セグメントの IP アドレスがポート 11434 にアクセスします。 実際のLANセグメントに応じてIPアドレスの範囲を変更してください。 - 他のアクセスを拒否する(オプション): デフォルトのポリシーが外部からのアクセスをすべて許可するものである場合、次のように実行できます。

sudo ufw deny 11434コマンドを使用して、他のすべてのソースからのIPアドレスに対してポート11434へのアクセスを拒否します。 - ファイアウォールのステータスを表示します: はこびだす

sudo ufw status verboseコマンドでファイアウォール・ルールのステータスを確認し、設定が有効になったことを確認する。

6.3 認証とアクセス制御を有効にする

Ollamaのサービスを外部に提供する必要がある場合は、次のことを確認してください。認証メカニズムを有効にする。 を使用して、不正アクセスを防ぐことができます。 以下は、一般的な認証方法である:

- HTTP ベーシック認証: HTTPベーシック認証は、ApacheやNginxのようなウェブ・サーバーを通して設定することができる。この方法はシンプルで使いやすいですが、セキュリティは比較的低く、高いセキュリティを必要としないシナリオに適しています。 ベーシック認証を設定すると、ユーザーは Ollama サービスにアクセスする際にユーザー名とパスワードを入力する必要があります。

- APIキー OllamaサービスのフロントエンドにAPIキー検証メカニズムを追加する。 クライアントがOllamaサービスをリクエストする際、リクエストヘッダまたはリクエストパラメータに定義済みのAPIキーを含める必要があります。 サーバー側はキーの有効性を検証し、正しいキーを持つリクエストのみを処理する。 このアプローチはベーシック認証よりも安全で、アプリケーションへの統合も容易です。

- OAuth 2.0など、より高度な認証認可メカニズム: より高度なセキュリティが要求されるシナリオでは、OAuth 2.0のような、より複雑な認証・認可フレームワークを検討することができる。 OAuth 2.0は、完璧な認証と認可プロセスを提供し、複数の認可モードをサポートし、きめ細かいアクセス制御を実現することができます。 しかし、OAuth 2.0の設定と統合は比較的複雑で、ある程度の開発労力を必要とします。

認証方法の選択は、アプリケーション・シナリオ、セキュリティ要件、Ollama サービスの技術的実装のコストなど、さまざまな要因の組み合わせに基づいて行う必要がある。

6.4 リバースプロキシの使用

リバースプロキシサーバー(Nginxなど)を使えば、以下のことが可能です。Ollamaサービスのフロントエンドとして動作し、Ollamaサービスの実際のIPアドレスとポートを隠し、追加のセキュリティ機能を提供する。例えば、こうだ:

- バックエンドサーバーを隠す: リバースプロキシサーバはOllamaサービスの「ファサード」として機能します。 外部ユーザにはリバースプロキシサーバのIPアドレスのみが表示され、Ollamaサービスのある実際のサーバには直接アクセスできないため、セキュリティが向上します。

- ロードバランシング: Ollama サービスが複数のサーバーに展開されている場合、リバースプロキシサーバーはロードバランシングを実装し、ユーザーリクエストを異なるサーバーに分散することで、サービスの可用性とパフォーマンスを向上させることができます。

- SSL/TLS暗号化: リバースプロキシサーバはSSL/TLS証明書を設定してHTTPS暗号化アクセスを可能にし、データ伝送のセキュリティを保護することができる。

- ウェブアプリケーションファイアウォール(WAF): リバースプロキシサーバの中には、SQLインジェクションやクロスサイトスクリプティング攻撃(XSS)などの一般的なウェブ攻撃を検知・防御するWAF機能を統合し、Ollamaサービスのセキュリティをさらに強化するものもあります。

- アクセスコントロール: リバースプロキシサーバーは、IPアドレス、ユーザーID、およびリクエストコンテン ツに基づくアクセス制御のような、より柔軟なアクセス制御ポリシーで構成す ることができる。

7.結論:セキュリティ意識と行動における責任

Ollamaのようなローカルで展開されるビッグモデルツールの人気は、技術革新と応用を促進したが、同時にサイバーセキュリティに新たな課題をもたらした。 インターネット上で「無料で使える」と公開されているOllamaのサービスは、魅力的に見えるかもしれないが、隠れたリスクがある。 このような行為は、法令やサイバー倫理に違反するだけでなく、あなた自身や他者のサイバーセキュリティを脅かす可能性があります。

Ollamaサービスの導入企業にとって、セキュリティに対する意識を高め、必要なセキュリティ対策を講じることは、自社のコンピューティング・リソースとデータのセキュリティを保護し、健全なネットワーク環境を維持するための責務です。 一瞬の過失でサーバーを「算術ブロイラー」にしたり、サイバー攻撃の共犯者になったりしないように。

テクノロジーの恩恵を享受する一方で、すべてのインターネット・ユーザーは常に警戒し、ネットワーク・セキュリティに対する正しい見方を確立し、安全で信頼できる持続可能なAIアプリケーションのエコシステムを構築するために協力すべきである。

リスクアラート再び:すぐにOllamaサービスをチェックし、硬化してください!安全は小さな問題ではありません!

DeepSeekモデルとOllamaツールの人気は、間違いなくAI技術の発展を象徴している。 しかし、安全性は常に技術進歩の礎である。 Ollamaユーザーの皆様へ直ちにローカルの配備構成を見直し、潜在的なセキュリティリスクを評価し、必要な堅牢化措置を講じる。 今からでも遅くはない。

まだOllamaをインストールされていない方、またはOllamaの導入を検討されている方は、次のこともご確認ください。ビッグモデルツールをローカルに導入することのセキュリティリスクを十分に認識し、自らの技術的能力とセキュリティ保護のレベルを慎重に評価し、セキュリティ確保を前提に適切に使用する。 サイバーセキュリティはすべての人の責任であり、未然に防ぐことが最善の戦略であることを忘れてはならない。