はじめに

DeepGeminiは、開発者Thomas Sligterによって作成されたオープンソースプロジェクトである。マルチモデルオーケストレーションをサポートするAI管理ツールであり、主な特徴は様々なAIモデルを柔軟に組み合わせることができることで、OpenAI互換のAPIインターフェースを通じて呼び出される。このプロジェクトはPython 3.11とFastAPIをベースにしており、SQLiteデータベースストレージの設定をサポートし、ウェブ管理インターフェースとDockerデプロイメントを提供します。DeepGeminiは、中国語と英語のインターフェースをサポートしており、機能が豊富で使いやすい。

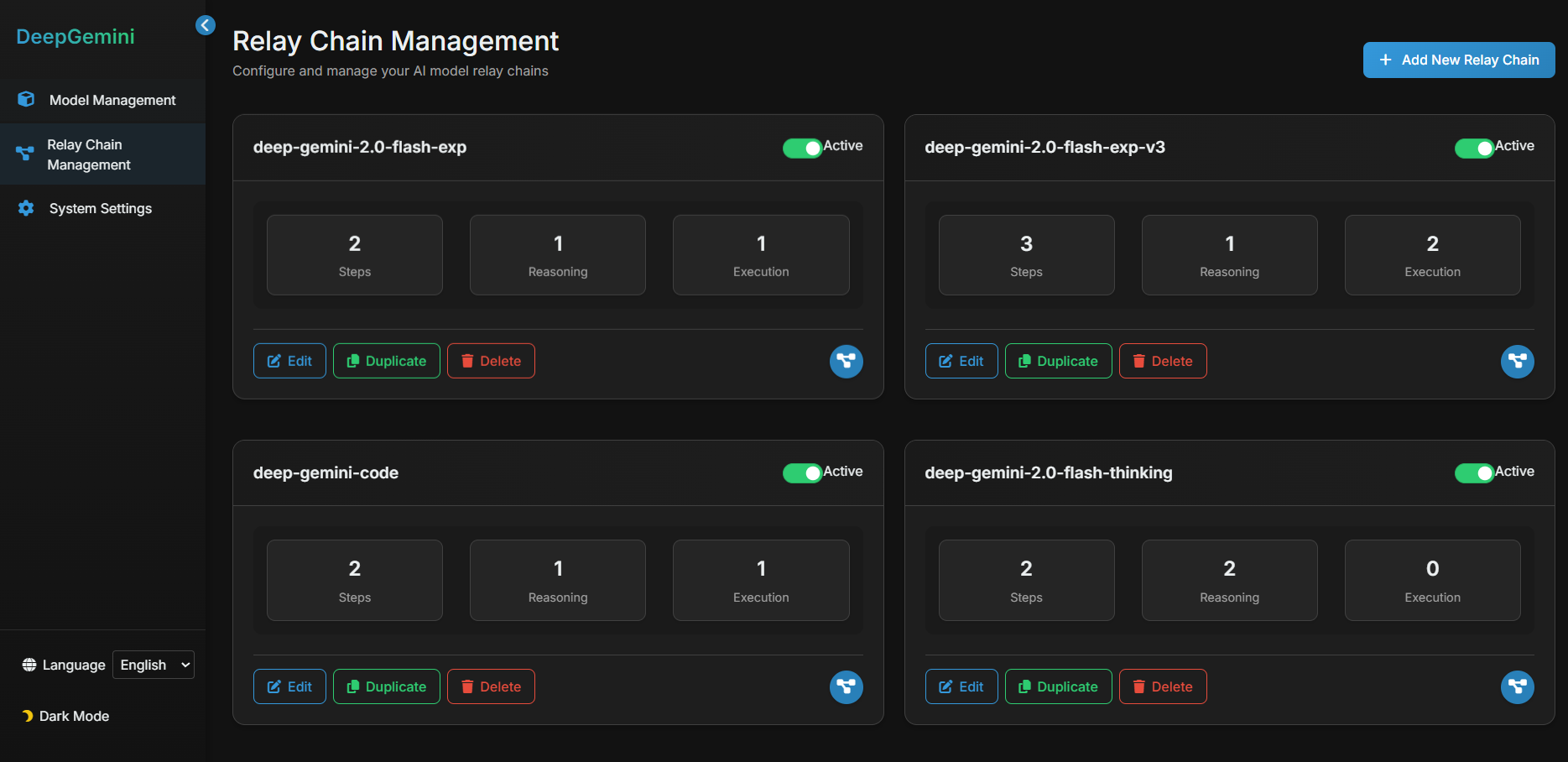

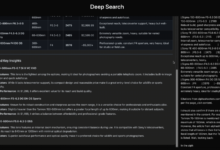

このプロジェクトでは、インターフェイスにマルチモデルワークフローとマルチモデルディスカッションタスクグループを設定したが、これはインターフェイスで直接使用することはできず、APIを使用するには他のチャットツールで設定する必要があった。このツールは通常のインテリジェンス用タスクスケジューリングツールよりもシンプルで実用的であり、唯一の欠点はAPIクォータをより多く消費することである。

機能一覧

- マルチモデル・オーケストレーションをサポートし、タスクを完了するために複数のAIモデルの組み合わせをカスタマイズできる。

- キャラクターを管理し、AIにさまざまな性格やスキルを設定できる。

- 複数のAIキャラクターが共同でディスカッションできるディスカッショングループをサポート。

- ブレーンストーミング、ディベート、SWOT分析など、複数のディスカッションモードが組み込まれている。

- DeepSeek、Claude、Gemini、Grok3など、複数のAIプロバイダーに対応。

- 既存のアプリケーションのOpenAIインターフェイスを直接置き換えるOpenAI互換のAPIインターフェイスを提供します。

- リアルタイム・ストリーミング・レスポンスをサポートし、ユーザー体験を向上。

- ウェブ管理インターフェイスを内蔵し、モデルの設定やステータスの確認が容易。

- SQLiteデータベースとAlembicマイグレーションをサポートし、より安定した管理構成を実現。

ヘルプの使用

DeepGeminiのインストールと使用方法は、ローカル操作とDockerデプロイの2通りに分かれる。以下では、ユーザがすぐに使い始められるように、インストール手順と機能的な操作手順を詳しく説明する。

インストール・プロセス - ローカルで実行

- プロジェクトコードの複製

ターミナルで以下のコマンドを入力し、プロジェクトをダウンロードする:

git clone https://github.com/sligter/DeepGemini.git

次にプロジェクト・ディレクトリに移動する:

cd DeepGemini

- 依存関係のインストール

プロジェクトにお勧めuvツールは依存関係をインストールし、実行する:

uv sync

そうでなければ uvそれは pip install -r requirements.txt 代替手段Pythonのバージョンが3.11以上であることを確認してください。

- 環境変数の設定

サンプル設定ファイルをコピーする:

cp .env.example .env

テキストエディタで開く .env以下の必須項目を設定する:

ALLOW_API_KEYAPIキーは自分で定義してください。ALLOW_ORIGINS許可されたドメイン名の送信元を記入する。*すべてを許可することを示すか、カンマで特定のドメインを区切る。

オプションの設定には、モデルAPIキーとパラメータ(例えばDEEPSEEK_API_KEY).

- サービス開始

次のコマンドを入力して開始する:

uv run uvicorn app.main:app --host 0.0.0.0 --port 8000

起動に成功したら、ブラウザを開いて http://localhost:8000/dashboardウェブ管理インターフェースにアクセスしたい場合は、以下のリンクをクリックしてください。

インストールプロセス - Dockerデプロイメント

- Dockerイメージのプル

ターミナルで実行:

docker pull bradleylzh/deepgemini:latest

- 設定ファイルとデータベースの準備

カレント・ディレクトリにファイルを作成する:

- Linux/Mac:

cp .env.example .env touch deepgemini.db echo "" > deepgemini.db - Windows PowerShell:

cp .env.example .env echo "" > deepgemini.db

コンパイラ .env設定 ALLOW_API_KEY 歌で応える ALLOW_ORIGINS.

- Dockerコンテナの実行

開始するコマンドを入力する:

- Linux/Mac:

docker run -d -p 8000:8000 -v $(pwd)/.env:/app/.env -v $(pwd)/deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest - Windows PowerShell:

docker run -d -p 8000:8000 -v ${PWD}\.env:/app/.env -v ${PWD}\deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest

実行後 http://localhost:8000/dashboard.

Docker Composeの使用(推奨)

- 意図する

.envとデータベース・ファイルについては、前述の通りである。 - 走っている:

docker-compose up -d

インタビュー http://localhost:8000/dashboard.

主な機能

1.ウェブ管理インターフェイスの操作

- ブラウザを開き、次のサイトにアクセスする。

http://localhost:8000/dashboard. - インタフェースには、モデルのステータスと構成オプションが表示されます。Add Model" をクリックし、モデル名 (例 DeepSeek)、API キー、およびパラメータ (温度、top_p など) を入力して保存します。

- ロール管理でAIロールを作成し、パーソナリティ(例:「論理的厳密性」)とスキル(例:「テキスト生成」)を設定する。

2.マルチモデル・オーケストレーションの設定

- ワークフロー]画面で[新規ワークフロー]をクリックします。

- 設定例:

{

"name": "reason_and_execute",

"steps": [

{"model_id": "deepseek", "step_type": "reasoning", "step_order": 1},

{"model_id": "claude", "step_type": "execution", "step_order": 2}

]

}

- 保存されると、ワークフローはクロードで結果を生成する前に DeepSeek で推論します。

3.APIインターフェースの呼び出し

- 利用する

curlAPIをテストする:

curl -X POST "http://localhost:8000/v1/chat/completions" -H "Authorization: Bearer YOUR_API_KEY" -H "Content-Type: application/json" -d '{"model": "reason_and_execute", "messages": [{"role": "user", "content": "分析并回答:1+1等于几?"}]}'

- 相互互換性

YOUR_API_KEYというのも.envをキーとする。返される結果はストリーミング・レスポンスである。

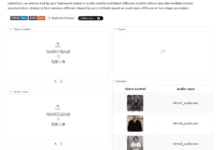

4.ディスカッション・グループの創設

- ディスカッション・グループ・ページで、複数のロール(アナリストやクリエイターなど)を追加します。

- ディスカッションモード(例:「ブレインストーミング」)を選択し、質問を入力して「ディスカッション開始」をクリックします。登場人物の対話が表示されます。

ほら

- ネットワーク接続が正常に機能していることを確認する。モデルによっては、外部APIへのアクセスが必要なものもある。

- ログファイルは

<项目目录>/logs/問題のトラブルシューティングに使用できる。 - Dockerのデプロイ中にポートの競合が発生した場合は、以下のように修正できます。

-p 8000:8000の最初のポート番号。

アプリケーションシナリオ

- AI開発実験

開発者は、DeepGeminiとのマルチモデル連携をテストすることができます。例えば ジェミニ 質問を分析し、クロードを使って詳細な回答を作成する。 - チームワーク・シミュレーション

ディスカッショングループ機能でチームミーティングを疑似体験。さまざまな役割を設定して、製品戦略について議論し、多様な提案をアウトプットすることができます。 - 教育とトレーニング

生徒たちは、AIモデルの特性について学んだり、さまざまな話し合いの方法を試して結果を観察したりするために使うことができる。

品質保証

- 対応するAIプロバイダーは?

DeepSeek、Claude、Gemini、Grok3、OpenAIなどをサポートし、他のプロバイダーへのアクセスもカスタマイズ可能。 - ディスカッション・グループに何の意味があるのか?

ディスカッション・グループでは、複数のAIペルソナが、ブレーンストーミングやディベートなど、複雑な問題に対して共同作業を行うことができ、答えに対して複数の視点を提供することができる。 - 問題のデバッグ方法は?

ログファイルを確認するか、GitHubにissueを提出して助けを求めてください。