はじめに

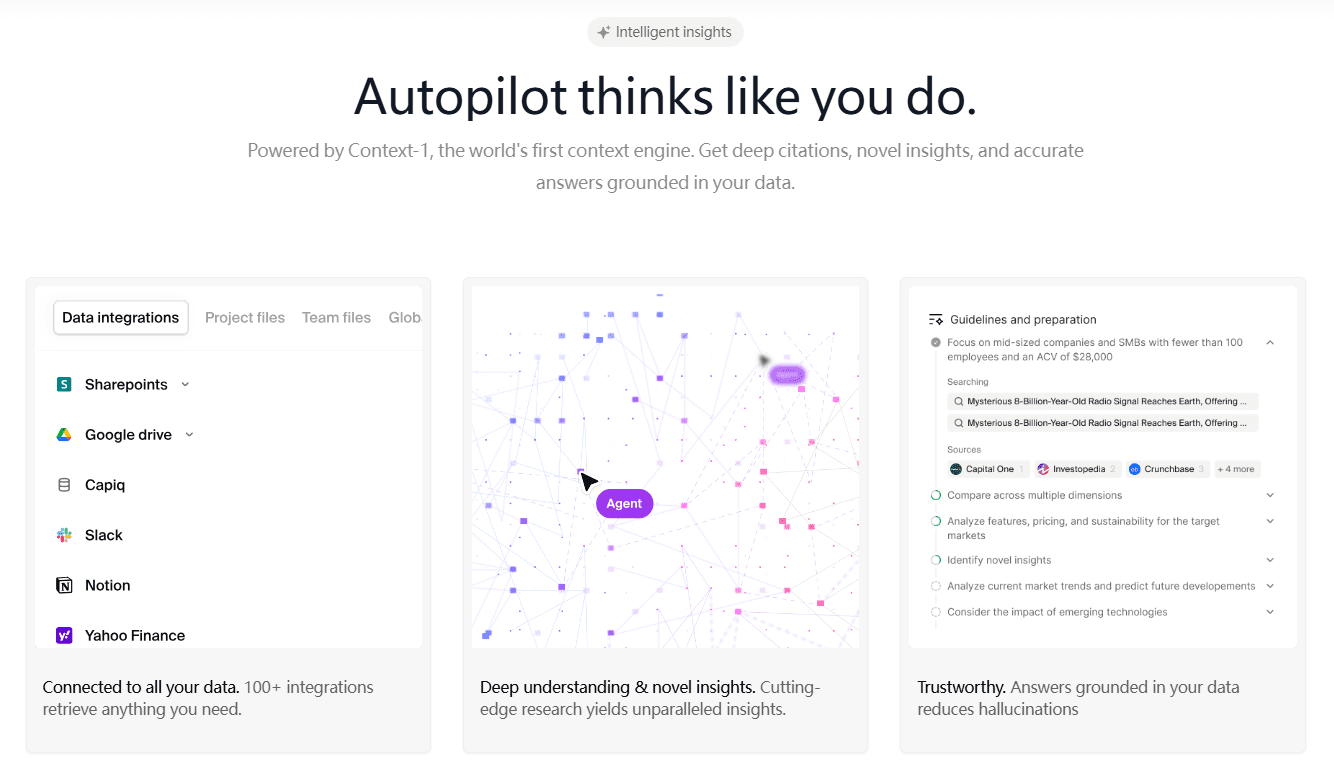

Context Autopilotは、深い統合と自動化されたオフィスを通じてチームの生産性を向上させるために設計されたContextのインテリジェントなAI生産性ツールです。世界初のコンテキストエンジンであるContext-1を活用したこのツールは、ユーザーのデータから深い引用と斬新な洞察を引き出し、正確な回答を提供します。100以上の統合をサポートするContext Autopilotは、ユーザーを幅広いデータソースにシームレスに接続し、プロフェッショナルな文書、プレゼンテーション、データビジュアライゼーションの迅速な生成と編集を支援します。

Contextは、さまざまな作業タスクに応じて人間のように思考し、ビジネスコンサルティング、財務分析、データビジュアライゼーション、企業レポート作成、プロジェクトプレゼンテーション、データ分析など、専門的な作業シナリオの自動生成に適しています。

機能一覧

- 深い引用と新鮮な洞察Context-1エンジンを活用し、ユーザーデータから深い引用と斬新な洞察を抽出。

- データ統合100以上のデータ統合をサポートし、ユーザーを様々なデータソースにシームレスに接続することができます。

- ドキュメントの作成と編集契約書や報告書など、プロフェッショナルな文書をすばやく作成・編集できます。

- プレゼンテーションの作成と編集クライアントへのプレゼンテーションから社内レビューまで、プロフェッショナルなプレゼンテーションを素早く作成・編集。

- データの可視化Pythonを使用してデータビジュアライゼーションを作成し、大規模なデータセットを分析します。

- 自然言語コマンド複雑な金融モデルの構築と修正、自然言語コマンドによるデータ傾向の分析。

ヘルプの使用

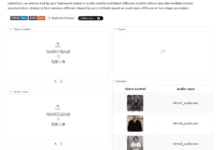

設置プロセス

- アカウント登録ページ右上の「登録」ボタンをクリックし、関連情報を入力して登録を完了します。

- ソフトウェアのダウンロード登録が完了したら、アカウントにログインし、Context Autopilotのインストールパッケージをダウンロードします。

- ソフトウェアのインストールダウンロードしたインストールパッケージを実行し、画面の指示に従ってインストールを完了します。

使用プロセス

- アカウントにログインするContext Autopilotソフトウェアを開き、登録したアカウント情報を入力してログインします。

- データ統合メイン・インターフェースで "Data Integration "オプションを選択し、プロンプトに従って統合が必要なデータ・ソースに接続する。

- ドキュメントの作成文書作成」機能を選択し、関連情報を入力すると、ソフトウェアが自動的にプロフェッショナルな文書を作成します。

- 文書を編集する生成されたドキュメントを基に、内蔵の編集ツールを使って修正や改良を加えることができます。

- プレゼンテーションの作成プレゼンテーション生成」機能を選択し、関連情報を入力すると、ソフトウェアは自動的にプロフェッショナルなプレゼンテーションを生成します。

- データの可視化データビジュアライゼーション機能を選択すると、Pythonコードを使用してデータのビジュアライゼーションを作成し、データの傾向を分析できます。

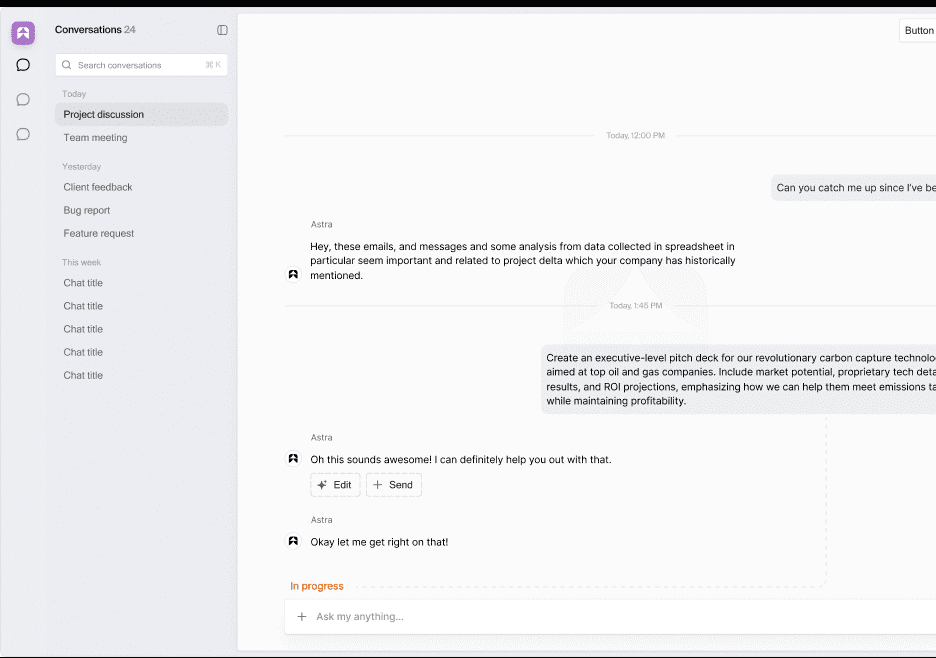

- 自然言語コマンドの使用自然言語コマンド」インターフェイスでは、自然言語コマンドを入力すると、財務モデルの構築やデータ傾向の分析など、対応する操作をソフトウェアが自動的に実行する。

機能 操作の流れ

- 深い引用と新鮮な洞察メイン・インターフェースで「詳細見積もり」機能を選択し、分析するデータを入力すると、ソフトウェアは自動的に詳細な見積もりと斬新な洞察を抽出します。

- データ統合データ統合 "インターフェイスで、統合するデータソースを選択し、プロンプトに従って接続を完了します。

- ドキュメントの作成と編集文書生成 "インターフェイスで、関連情報を入力すると、ソフトウェアは自動的にドキュメントを生成します。生成後、内蔵の編集ツールを使用して、修正および改善することができます。

- プレゼンテーションの作成と編集プレゼンテーションの生成」画面で関連情報を入力すると、ソフトウェアが自動的にプレゼンテーションを生成します。生成されたプレゼンテーションは、内蔵の編集ツールを使って修正・改良することができます。

- データの可視化データ可視化」画面でPythonのコードを入力すると、ソフトウェアが自動的にデータ可視化チャートを生成します。

- 自然言語コマンド自然言語コマンド」インターフェイスでは、自然言語コマンドを入力すると、財務モデルの構築やデータ傾向の分析など、対応する操作をソフトウェアが自動的に実行する。

コンテキスト・オートパイロットの導入

あるコンテクストを発表する。オートパイロット - あなたのように学習し、あなたのように考え、あなたのようにツールを使用するAI生産性スイート。コンテキストエンジン既存のワークフローとシームレスに統合するように設計されたサポートを提供し、今日の情報ジョブのほとんどを処理することができます。

人工知能を再考するためのツール

大規模言語モデル(LLM)が賢くなるにつれて、私たちが使用するツールもそれに合わせて進化する必要がある。ソフトウェアは伝統的に人間の入力のために作られてきた-それは1970年代にさかのぼる伝統である。このパラダイムは変わりつつあり、将来はジェネレイティブが中心になる。現在のソリューションは、多くの場合、漸進的で、解釈不可能で、ワークフローの変更を必要とし、その採用と有用性を制限している。

LLMベースのオペレーティング・システム

Autopilotは、LLMベースのオペレーティングシステムを提供することで、これらの課題に取り組んでいる。専用ツールと希少なコンテキスト・コンテキストを提供することで、モデルを束縛から解き放ち、より人間のように組織を解析し、考えることを可能にする。

Autopilotは独自のワークスペースを持ち、DriveやSharepointなどのサービス、SlackやEメールなどのコミュニケーション・チャンネル、顧客文書、個人メモ、外部データベースなどに直接接続できる。

既存のワークフローとのシームレスな統合

Autopilotは、あなたが使っているのと同じツールを使ってプロジェクトを構築します。Autopilotアプリケーションは自己完結型に設計されており、直接的なステート操作と複雑なマルチステップワークフローの両方をサポートします。

これによりAIは、意味のある理解と対話のために人間が必要とする必要な知識を得ることができる。オートパイロットはユーザーと積極的に協力し、好みや情報を尋ねたり、フィードバックを得たり、タスクを並行して実行したりすることができる。

進捗状況をリアルタイムで報告することで、人間と機械の継続的なコラボレーションを可能にする。複雑な課題に直面すると、オートパイロットは自分自身を複製し、共通の目標に集中する協働エージェントのグループを形成することができる。これにより、うまく調整されたチームと同じように、タスクを委任して効率的に実行することができます。

メモリースタック:コンテキストエンジンの動力源

これらはすべて、オートパイロットのメモリースタックによって行われる。ファイルシステムと入力間の一貫性を保証するために、共有ワークスペースを超えて実装されている。これは継続的なリフレクションと出力の反復をサポートするもので、これがコンテキスト・エンジンである。

コンテキストエンジン:新しいパラダイム

コンテキスト・エンジンは、モデルが大量の知識を推論し、真に理解することを可能にする。オートパイロットが何百ものステップを必要とするタスクを計画し、推論し、実行できるのはこのためだ。

検索強化世代 (ラグ)は、基本的に検索アーキテクチャによって制限されており、意味的に類似した少量のデータにしか対応できません。対照的に、Autopilotのコンテキストエンジンは、多数のエージェントがお客様の知識ベースを常にトラバースし、新しいパスを追跡し、つながりを発見し、洞察を明らかにすることを可能にします。何千ものインタラクションを抽出することで、長いコンテキスト・モデルに関連するパフォーマンスの低下を招くことなく、大規模なコンテキストにわたって最先端のインテリジェンスを提供することができます。

コンテキストは動的で、時間の経過とともに学習し、エラーを修正します オートパイロットは常に入力情報を監視し、外部のデータソースに問い合わせることで自律的に自己を改良します。これにより、タスクの詳細な理解とスキルの習得が可能になります。オートパイロットは、他の従業員と同じように、選択した指示セットでトレーニングを受けることができます。

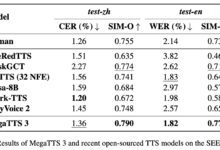

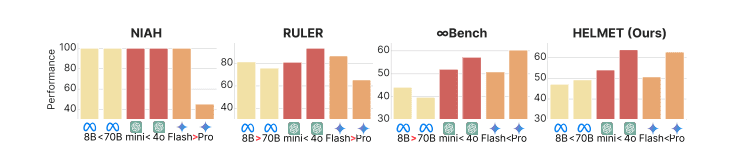

技術評価:コンテキストエンジンのベンチマーク

我々のコンテキストエンジンの有効性を評価するために、2つの包括的なベンチマークを用いて、他のフロンティアモデルやRAGの実装と比較した:

- ヘルメット::ロングコンテクスト言語モデルを効果的かつ徹底的に評価する方法(円ら、2024年)。

- ロフト::ロングコンテクスト・フロンティア・ベンチマーキング。で紹介された。「長い文脈の言語モデルは検索、RAG、SQLなどを含むことができるか?(リーら、2024年)。

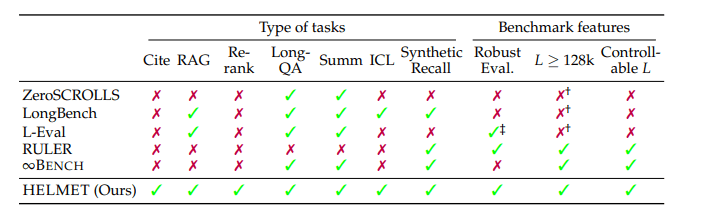

従来のベンチマークの限界

HELMETは、既存のロングコンテキストベンチマークを大幅に改善し、RULERのような他の一般的なベンチマークの欠点に対処している。HELMETは既存のロングコンテキストベンチマークを大幅に改善し、RULERのような他の一般的なベンチマークの欠点に対処している。

HELMETベンチマーク結果

評価方法

我々はこれを以下のパラメータで評価した:

- ヘルメットベンチマーク全体の15%のランダムなサブセットで実行。

- タスクと指標の種類::

- ラグサブストリングの完全一致

- 段落の並び替えNDCG@10(正規化割引累積利益)

- 引用による生成回想/引用

- 長いドキュメントのQAモデルベース/ROUGE F1/精度

- 抄録モデルベース

- 複数サンプルによる文脈学習精度

- 総合リコールサブストリングの完全一致

- タスクと指標の種類::

- ロフト3つのタスクのうち、ランダムな30%のサブセットで実行。

- タスクと指標の種類::

- ラグサブスパンの完全一致

- テキスト検索リコール@1

- SQL精度

- タスクと指標の種類::

マルチカメラコンテキスト学習タスクは、100万トークンのコンテキストサイズをテストするためのデータセットが公式リポジトリにないため、省略した。また、音声検索と視覚検索のタスクも省略した。これらの評価で使用したモデルはすべて、執筆時点で利用可能な最新バージョンである。

ベンチマーク結果

我々の評価では、AutopilotのコンテキストエンジンがHELMETなどのベンチマークをリードし、フロンティアモデルを使用したGraphRAGを上回ることが示されている。知識全体を推論し、真に理解することで、Autopilotは従来のRAGアーキテクチャの限界を超越する。