Vor kurzem hat das Qwen-Team stolz eine Reihe von Qwen2.5-VL Anwendungsfall Notebook BeispielDies ist eine umfassende Demonstration der Leistungsfähigkeit von nativen Modellen und APIs. Diese Sammlung sorgfältig gestalteter Notebooks soll Entwicklern und Anwendern helfen, ein tieferes Verständnis für die Qwen2.5-VL ein starkes visuelles Verständnis und inspirieren zu mehr innovativen Anwendungen.

Notebook-Beispiel: Erste Schritte mit Qwen2.5-VL

Mit diesen detaillierten Notebook-Beispielen sind Entwickler in der Lage Machen Sie sich selbst ein Bild von der Leistung des Qwen 2.5-VL Modells bei allen Aufgaben!Qwen2.5-VL Ganz gleich, ob es um das Parsen komplexer Dokumente, die Durchführung präziser OCR-Aufgaben oder das gründliche Verstehen von Videoinhalten geht, Qwen2.5-VL liefert effizientes und genaues Feedback und beweist damit seine überragende Leistung.

Gleichzeitig freut sich das Qwen-Team auf das Feedback und die Beiträge der Community, um die Möglichkeiten von Qwen 2.5-VL zu verbessern und zu erweitern und um gemeinsam die Entwicklung der multimodalen Technologie voranzutreiben.

🔗 VERBUNDEN:

- GitHub-Repository. https://github.com/QwenLM/Qwen2.5-VL/tree/main/cookbooks

- Online-Erfahrung. https://chat.qwenlm.ai (wählen Sie das Modell Qwen2.5-VL-72B-Instruct)

- ModelScope-Modellverbindung: https://www.modelscope.cn/collections/Qwen25-VL-58fbb5d31f1d47

- Parsons Brinckerhoff API-Schnittstelle. https://help.aliyun.com/zh/model-studio/user-guide/vision/

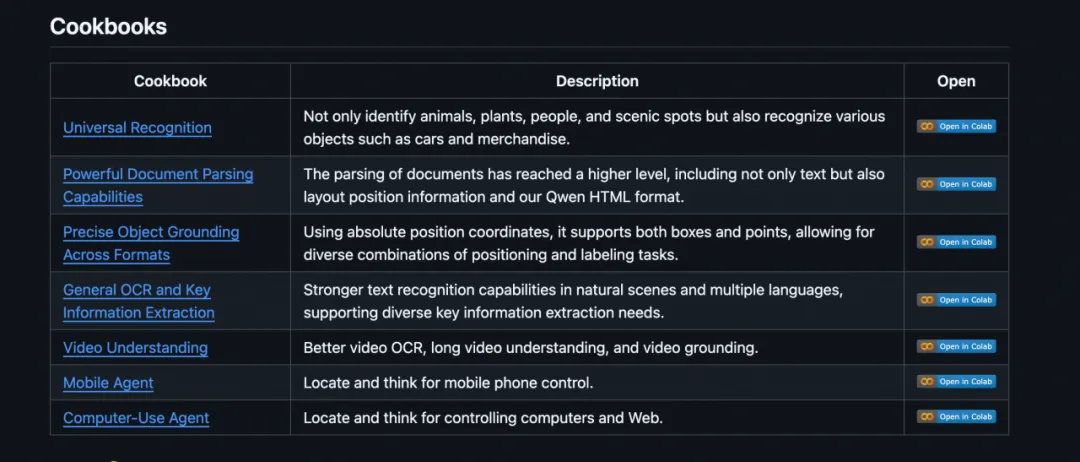

Notebook-Beispiele im Detail

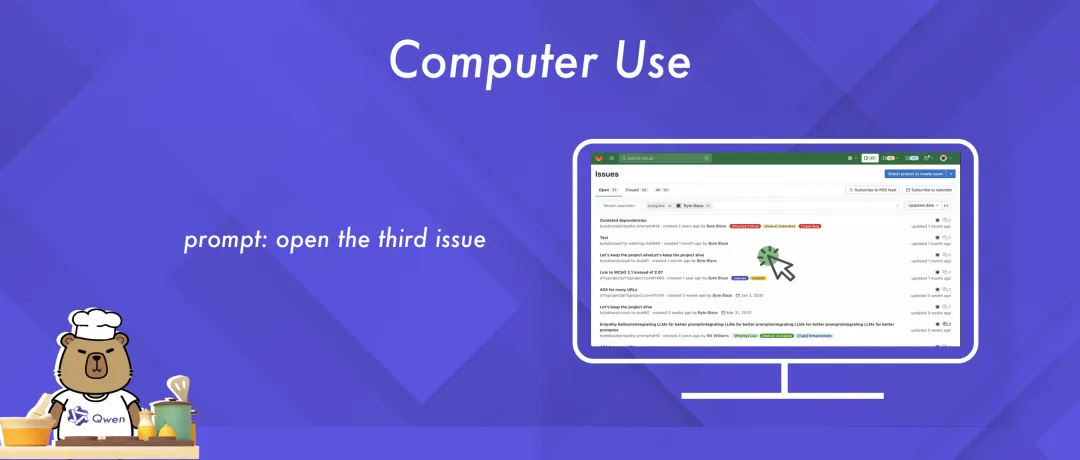

01 Computernutzung

Dieses Notebook-Beispiel zeigt, wie Qwen2.5-VL verwendet wird, um Aufgaben im Zusammenhang mit der Computernutzung durchzuführen.

Das Qwen2.5-VL-Modell ist in der Lage, den Inhalt des Screenshots zu analysieren, die Absicht des Benutzers zu verstehen und dann präzise Anweisungen wie Klicken oder Tippen zu geben, um eine intelligente Steuerung des Computers zu erreichen.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/computer_use.ipynb

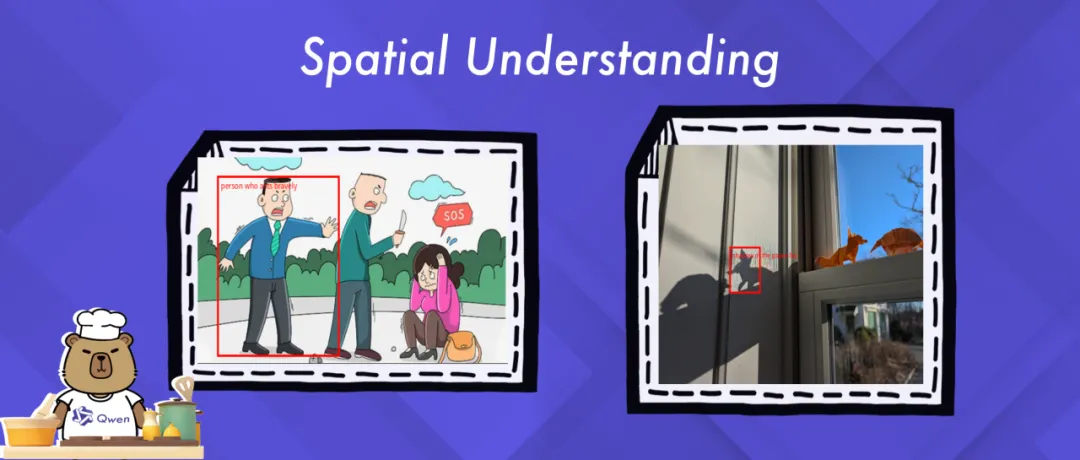

02 Räumliches Verstehen

Dieses Notebook-Beispiel verdeutlicht die fortschrittlichen räumlichen Lokalisierungsfähigkeiten von Qwen2.5-VL, einschließlich der genauen Erkennung von Objekten und der Lokalisierung bestimmter Ziele in einem Bild.

Die Beispiele geben einen Einblick, wie Qwen2.5-VL visuelles und sprachliches Verständnis effektiv integriert, um komplexe Szenarien genau zu interpretieren und fortgeschrittenes räumliches Denken zu ermöglichen.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/spatial_understanding.ipynb

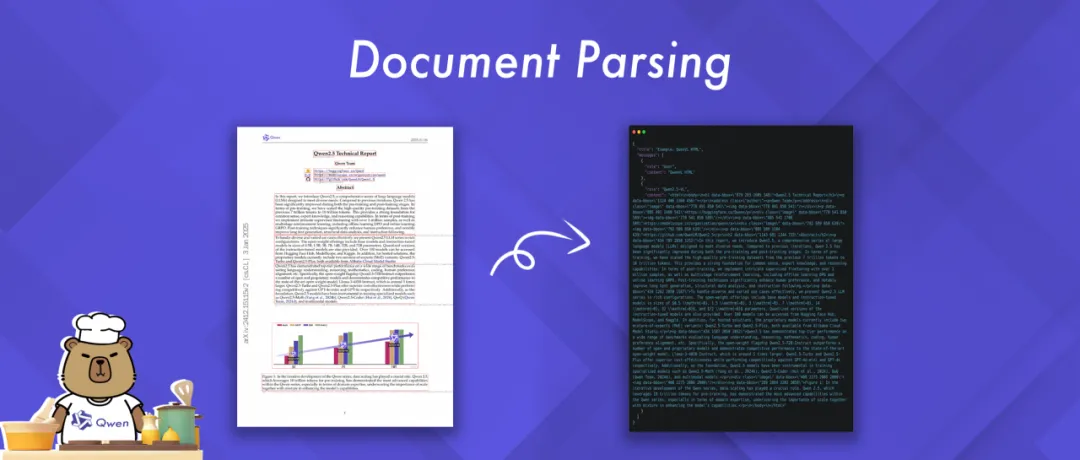

03 Parsing von Dokumenten

Dieses Notebook-Beispiel veranschaulicht die leistungsstarken Funktionen von Qwen2.5-VL zum Parsen von Dokumenten. Es kann Dokumente in einer Vielzahl von Bildformaten verarbeiten und die geparsten Ergebnisse in einer Vielzahl von Formaten wie HTML, JSON, MD und LaTeX ausgeben.

Von besonderem Interesse ist Qwens innovative Einführung eines einzigartigen QwenVL-HTML-Formats. Dieses Format enthält Informationen über die Position jeder Komponente im Dokument, was eine genaue Rekonstruktion und flexible Manipulation des Dokuments ermöglicht.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/document_parsing.ipynb

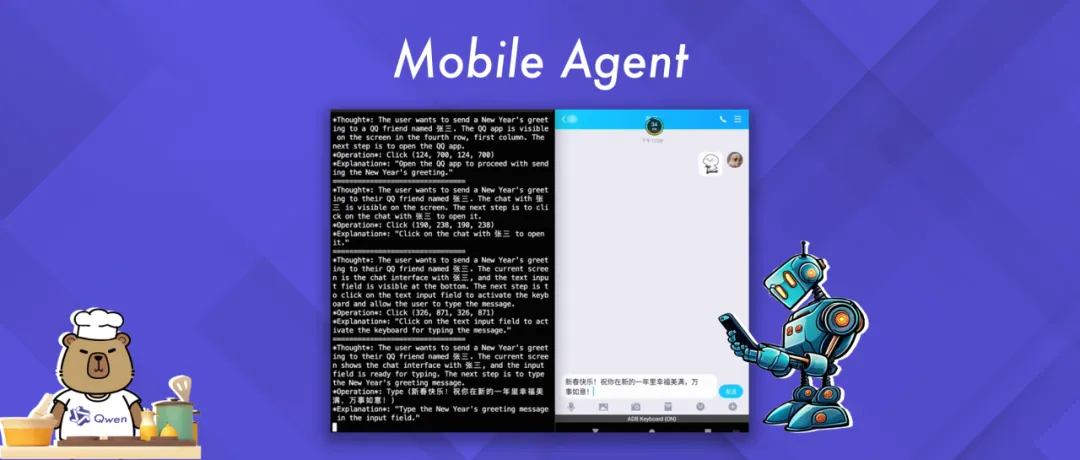

04 Mobiler Agent (Agent für mobile Geräte)

Dieses Notebook-Beispiel demonstriert die intelligente Interaktion mit einem mobilen Gerät unter Verwendung der Agentenfunktionen von Qwen2.5-VL.

Das Beispiel zeigt, wie das Qwen2.5-VL-Modell Aktionen auf der Grundlage der Benutzerabfrage und des visuellen Kontexts des mobilen Geräts generiert und ausführt, was eine einfache Steuerung des mobilen Geräts ermöglicht.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/mobile_agent.ipynb

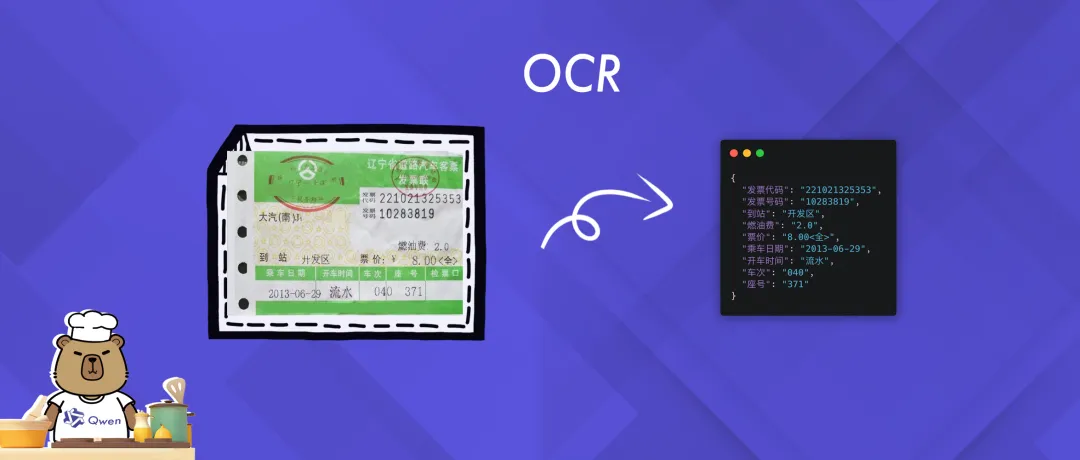

05 OCR (Optical Character Recognition)

Dieses Notebook-Beispiel konzentriert sich auf die Demonstration der OCR-Fähigkeiten (Optical Character Recognition) von Qwen2.5-VL, einschließlich der genauen Extraktion und Erkennung von Textinformationen aus Bildern.

Anhand der Beispiele können Anwender intuitiv nachvollziehen, wie Qwen2.5-VL Textinhalte in komplexen Szenarien präzise erfassen und interpretieren kann, und so seine leistungsstarken Texterkennungsfunktionen demonstrieren.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/ocr.ipynb

06 Universelle Erkennung

Dieses Notebook-Beispiel zeigt, wie man Qwen2.5-VL für die allgemeine Objekterkennung verwendet.

Das Qwen2.5-VL-Modell analysiert das Bild, versteht die Suchabsicht des Benutzers und liefert die entsprechenden Erkennungsergebnisse, wodurch ein umfassendes Verständnis des Bildinhalts erreicht wird.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/universal_recognition.ipynb

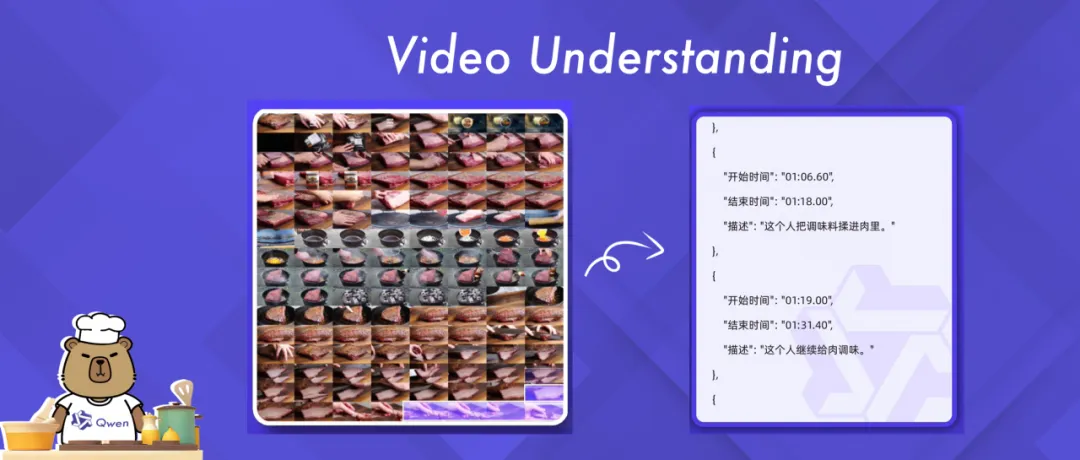

07 Video-Verständnis

Qwen2.5-VL verfügt über leistungsstarke Fähigkeiten zum Verstehen langer Videos und kann Videoinhalte von mehr als 1 Stunde Länge verarbeiten. Dieses Notebook-Beispiel bietet eine eingehende Untersuchung der Fähigkeiten des Qwen2.5-VL-Modells für Videoverstehensaufgaben.

Qwen2.5-VL wurde entwickelt, um sein Potenzial in einem breiten Spektrum von Videoanalyseszenarien zu demonstrieren, von einfacher OCR (Optical Character Recognition) bis hin zu komplexer Ereigniserkennung und Inhaltszusammenfassung.

👉 Notebook-Links. https://github.com/QwenLM/Qwen2.5-VL/blob/main/cookbooks/video_understanding.ipynb

Magic Hitch Best Practices: Beispiel für ein freies arithmetisches Spiel im Kochbuch

In der ModelScope Magic Hitch-Community können Benutzer diese Cookbook-Beispiele mit freier Arithmetik leicht erleben.

Laden Sie zunächst den Qwen2.5-VL-Code herunter.

git clone https://github.com/QwenLM/Qwen2.5-VL.git

Verwenden Sie die Models API in Notebook: Die MagicBuilder Platform API-Inference bietet eine kostenlose API für die Qwen2.5-VL-Modellfamilie, die von MagicBuilder-Benutzern direkt über API-Aufrufe verwendet werden kann, indem die Base-URL im Cookbook ersetzt und das MagicBuilder SDK ausgefüllt wird. Token Es kann losgehen.Ausführliche Dokumentation: https://www.modelscope.cn/docs/model-service/API-Inference/intro

from openai import OpenAI

client = OpenAI(

api_key="<MODELSCOPE_SDK_TOKEN>", # ModelScope Token

base_url="https://api-inference.modelscope.cn/v1"

)

response = client.chat.completions.create(

model="Qwen/Qwen2.5-VL-72B-Instruct", # ModelScope Model-Id

messages = [

{

"role": "user",

"content": [

{

"type": "image_url",

"image_url": {"url": "https://modelscope.oss-cn-beijing.aliyuncs.com/demo/images/bird-vl.jpg"}

},

{ "type": "text",

"text": "Count the number of birds in the figure, including those that are only showing their heads. To ensure accuracy, first detect their key points, then give the total number."

},

],

}

],

stream=True

)

Notebook verwendet ein lokales Modell: Bitte wählen Sie das GPU-Modell aus.

Fazit: Willkommen zum gemeinsamen Erleben und Gestalten der Zukunft

In Zukunft wird das Qwen-Team diese Notebook-Beispiele weiter aktualisieren und erweitern, um weitere nützliche Funktionen und Anwendungsszenarien einzubinden und Entwicklern umfassendere Lösungen zu bieten. Besuchen Sie das GitHub-Repository von Qwen2.5-VL oder ModelScope, um diese Notebook-Beispiele kennenzulernen und Ihre Erfahrungen und innovativen Anwendungen zu teilen! Das Qwen-Team freut sich darauf, die Möglichkeiten von Qwen2.5-VL mit Ihnen zu erkunden.