Kürzlich wurde das mit Spannung erwartete Qwen2.5-VL Qwen2.5-VL-32B-Instruct, ein neues Mitglied der Qwen2.5-VL-Serie, ist jetzt verfügbar. Dieses multimodale visuelle Sprachmodell mit 32 Milliarden Parametern übernimmt die Vorteile der Qwen2.5-VL-Reihe und wird durch Reinforcement Learning und andere Techniken weiter optimiert, um erhebliche Leistungsverbesserungen zu erzielen, insbesondere bei komplexen Schlussfolgerungen und der Benutzererfahrung.

Ende Januar dieses Jahres brachte das Qwen-Team die Qwen2.5-VL-Modellreihe auf den Markt und erntete schnell große Aufmerksamkeit und positives Feedback aus der Community. Um den Erwartungen der Community gerecht zu werden und die Entwicklung der multimodalen Modellierungstechnologie weiter voranzutreiben, hat das Team mehrere Monate damit verbracht, die Qwen2.5-VL-Serie sorgfältig zu polieren und schließlich dieses neue Qwen2.5-VL-32B-Instruct-Modell auf den Markt zu bringen, das unter Verwendung des Apache 2.0-Protokolls als Open Source zur Verfügung gestellt wird, damit ein breiteres Spektrum von Entwicklern und Forschern davon profitieren kann.

Ein Leistungssprung mit einer Reihe von Messwerten, die die der vorherigen Generationen und ähnlicher Modelle übertreffen

Offizielle Daten zeigen, dass das Modell Qwen2.5-VL-32B-Instruct bei einer Reihe von wichtigen Leistungsindikatoren deutliche Verbesserungen gegenüber der zuvor veröffentlichten Qwen2.5-VL-Serie erzielt.

Was erstens die subjektiven Nutzerpräferenzen betrifft, so macht das neue Modell durch die Anpassung des Ausgabestils die Antworten detaillierter und in einem standardisierteren Format, das den menschlichen Lesegewohnheiten und Vorlieben besser entspricht. Dies bedeutet, dass die Nutzer eine reibungslosere und natürlichere Interaktionserfahrung während der Nutzung erhalten.

Zweitens hat das Modell Qwen2.5-VL-32B-Instruct im Hinblick auf die Fähigkeit zum mathematischen Denken erhebliche Fortschritte bei der Genauigkeit der Lösung komplexer mathematischer Probleme gemacht. Dies deutet darauf hin, dass das Modell in Bezug auf logisches Denken und rechnerische Fähigkeiten effektiv verbessert wurde und besser in der Lage ist, Aufgaben zu bewältigen, die tiefgreifendes Denken und präzise Berechnungen erfordern.

Darüber hinaus zeigt das Qwen2.5-VL-32B-Instruct-Modell eine größere Stärke beim feinkörnigen Verstehen und Schlussfolgern von Bildern. Ob es sich um die Präzision der Bildanalyse, die Breite der Inhaltserkennung oder die Tiefe der visuellen Logik handelt, das neue Modell zeigt ein höheres Niveau und ist in der Lage, die Bildinformationen genauer und sorgfältiger zu analysieren.

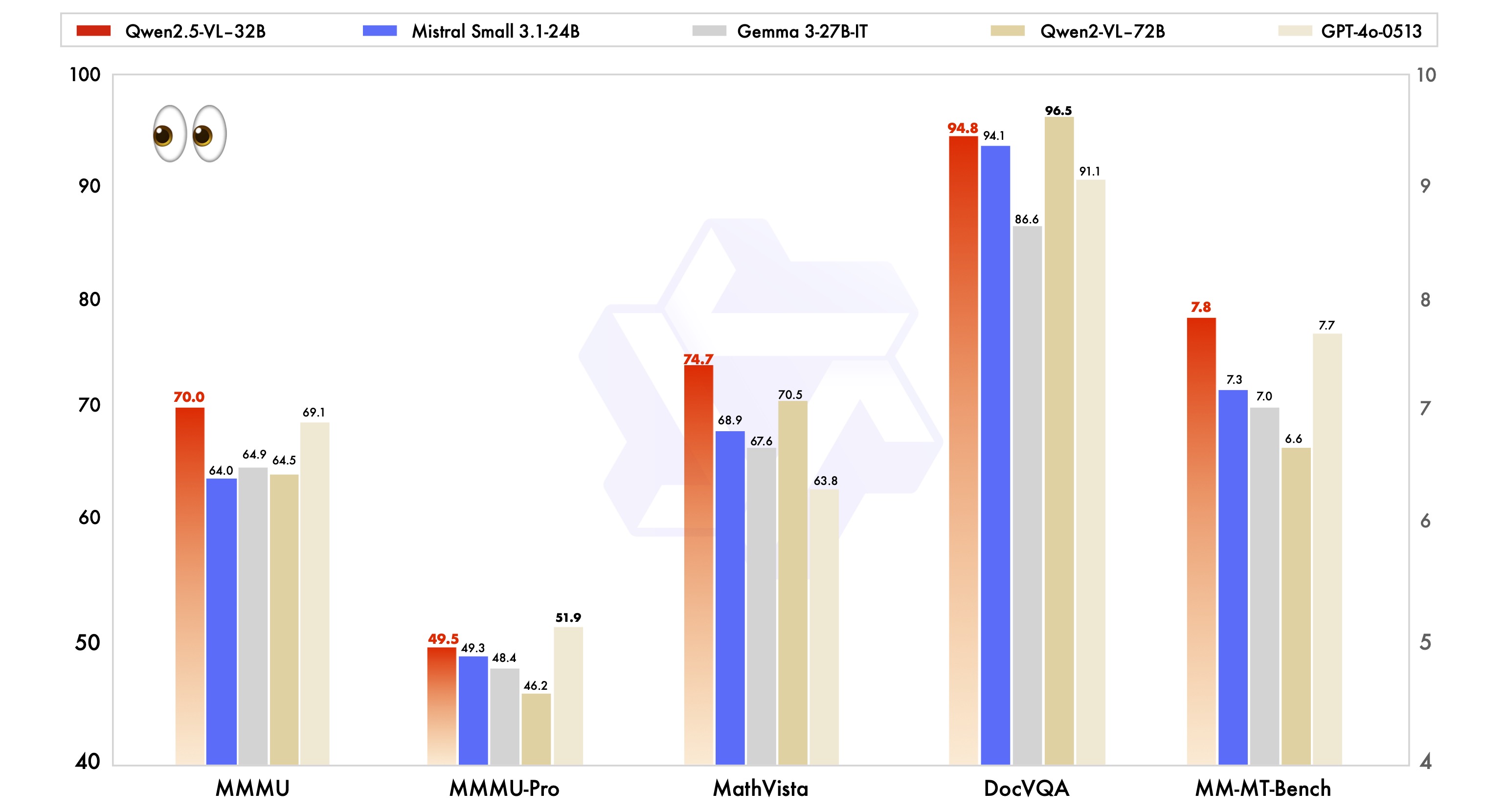

Um die Leistungsvorteile des Qwen2.5-VL-32B-Instruct-Modells zu demonstrieren, wurde es auch gegen branchenführende Modelle derselben Größe getestet, darunter Mistral-Small-3.1-24B und Gemma-3-27B-IT. Die Ergebnisse zeigen, dass das Modell Qwen2.5-VL-32B-Instruct bei vielen multimodalen Aufgaben deutliche Vorteile aufweist und einige der Indizes sogar das größere Modell Qwen2-VL-72B-Instruct übertreffen. Besonders beeindruckend ist die hervorragende Leistung des Qwen2.5-VL-32B-Instruct-Modells bei Aufgaben wie MMMU, MMMU-Pro und MathVista, bei denen komplexes mehrstufiges Denken im Vordergrund steht. Auch im MM-MT-Bench-Benchmark, bei dem das subjektive Nutzererlebnis im Vordergrund steht, hat das Modell im Vergleich zu seinem Vorgänger Qwen2-VL-72B-Instruct deutliche Fortschritte gemacht.

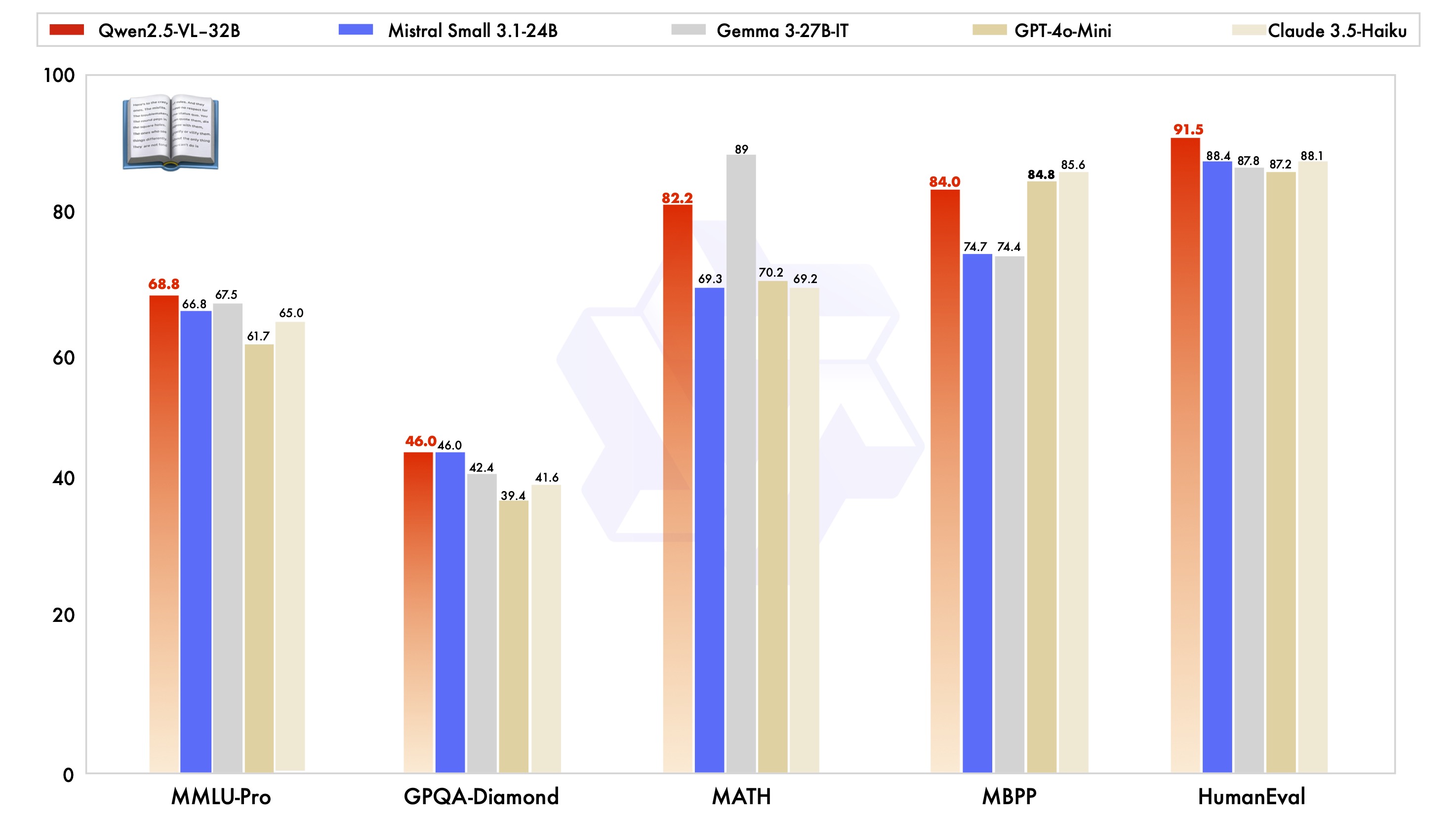

Es ist erwähnenswert, dass das Modell Qwen2.5-VL-32B-Instruct nicht nur in Bezug auf die visuellen Fähigkeiten gut abschneidet, sondern auch in Bezug auf die Klartextfähigkeiten das optimale Niveau des Modells im gleichen Maßstab erreicht.

Technologie-Highlights: dynamische Auflösung, effizienter visueller Encoder

Die Qwen2.5-VL-Modellreihe zeichnet sich auch durch eine Reihe von Innovationen und Verbesserungen in der technischen Architektur aus.

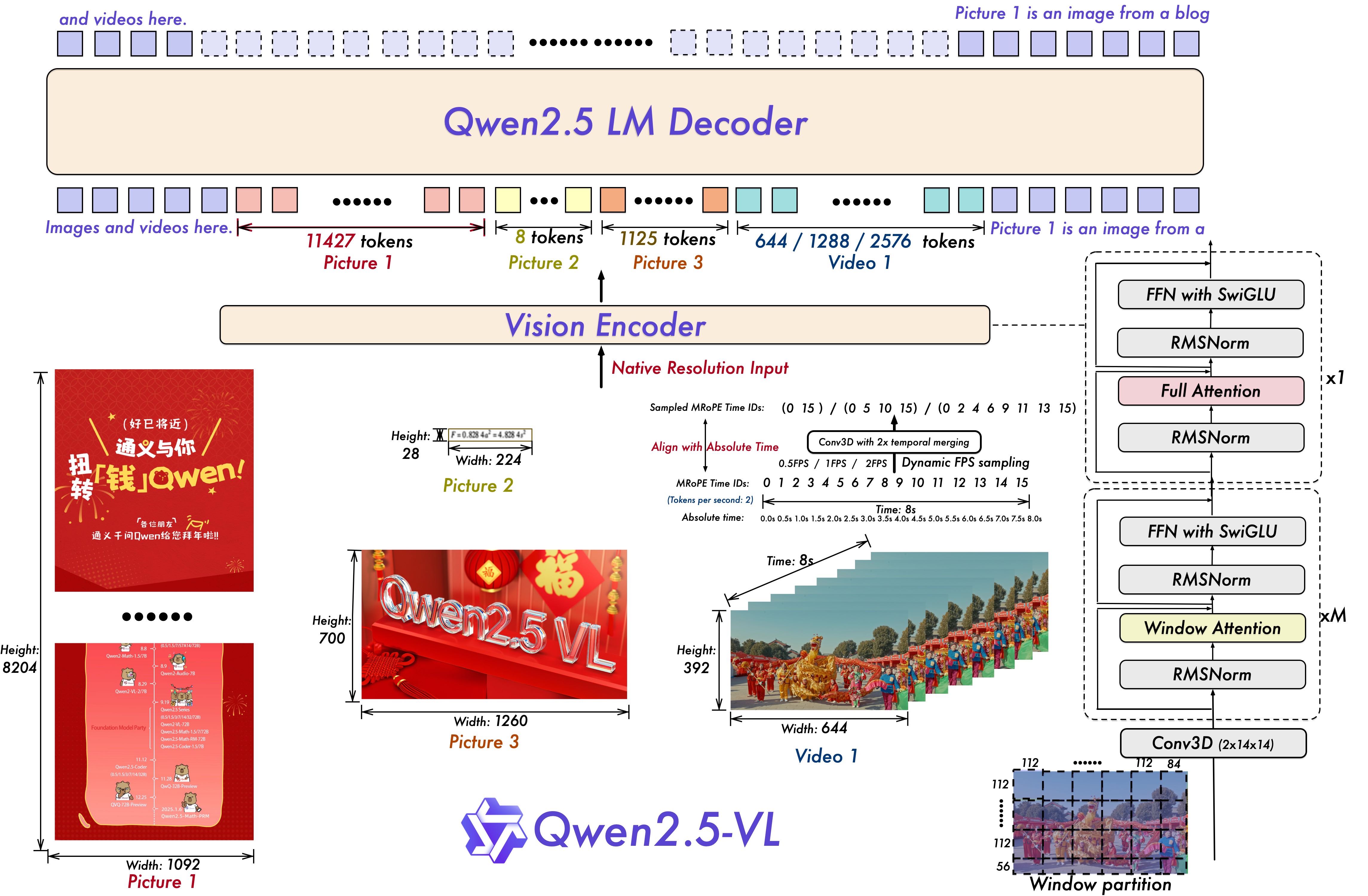

Für das Verstehen von Videos verwendet das Modell dynamische Auflösungs- und Bildraten-Trainingstechniken, die es dem Modell ermöglichen, Videoinhalte mit unterschiedlichen Abtastraten zu verstehen, indem ein dynamisches FPS-Sampling eingeführt wird. In der Zwischenzeit wird mRoPE (Multiple Relative Position Encoding) in der zeitlichen Dimension aktualisiert und mit IDs und absoluter Zeitausrichtung kombiniert, um das Modell in die Lage zu versetzen, Zeitserien- und Geschwindigkeitsinformationen zu erlernen und so die Schlüsselmomente im Video zu erfassen.

Für den Vision Encoder verwendet die Qwen2.5-VL Modellreihe einen optimierten und effizienten Vision Encoder, der im ViT (Vision) Encoder eingesetzt werden kann. Transformator) führt strategisch den fensterbasierten Aufmerksamkeitsmechanismus in Qwen2.5 LLM ein und kombiniert ihn mit Optimierungen wie SwiGLU und RMSNorm, um die ViT-Architektur konsistenter mit der Struktur von Qwen2.5 LLM zu machen und so die Geschwindigkeit des Modelltrainings und der Inferenz effektiv zu verbessern.

Einbeziehung von Open Source für multimodale Anwendungsinnovationen

Die Open-Source-Veröffentlichung des Qwen2.5-VL-32B-Instruct-Modells wird dem Bereich der multimodalen visuellen Sprache zweifelsohne neue Impulse verleihen. Auf der Grundlage dieses Modells können Entwickler und Forscher tiefgreifendere Forschungen durchführen und umfangreichere Anwendungen entwickeln, wie z. B. das Verstehen von Bild- und Videoinhalten, intelligente Agenten, die Generierung multimodaler Inhalte usw.

Das Qwen2.5-VL-32B-Instruct-Modell ist jetzt auf Hugging Face Transformers und ModelScope verfügbar, mit detaillierten Code-Beispielen und Anleitungen für den schnellen Einstieg. Das Qwen-Team hat angedeutet, dass es sich weiterhin auf das Feedback der Community konzentrieren wird, um die Qwen2.5-VL-Serie zu optimieren und zu verbessern. Die Qwen2.5-VL-Modellreihe wird auch weiterhin das Feedback der Community berücksichtigen, optimieren und verbessern und zur Entwicklung der multimodalen Technologie beitragen.

Wer das Modell Qwen2.5-VL-32B-Instruct kennen lernen möchte, kann auf folgende Weise einen schnellen Einstieg finden:

Umgebung Konfiguration

Es wird empfohlen, die Transformatorenbibliothek aus dem Quellcode zu erstellen, um Kompatibilität zu gewährleisten:

pip install git+https://github.com/huggingface/transformers accelerateSchnellstart-Codebeispiel (unter Verwendung von 🤗 Transformatoren).

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

Die Veröffentlichung des Qwen2.5-VL-32B-Instruct-Modells bringt zweifellos einen neuen Durchbruch im Bereich der multimodalen visuellen Sprachmodelle, und es wird erwartet, dass seine Vorteile in Bezug auf Leistung, Technologie und Open Source die Popularität und Anwendung der multimodalen Technologie beschleunigen werden, was die anhaltende Aufmerksamkeit der Branche verdient.