OpenAI hat kürzlich die Einführung einer neuen Generation von Audiomodellierungs-APIs angekündigt, die es Entwicklern ermöglichen sollen, leistungsfähigere und intelligentere Sprachassistenten zu entwickeln. Diese Initiative gilt als wichtiger Fortschritt im Bereich der Sprachinteraktionstechnologie und signalisiert, dass die Sprachinteraktion zwischen Mensch und Computer eine neue Phase einleiten wird, die natürlicher und effizienter ist.

Die Version enthält zwei wichtige Updates: ein fortschrittlicheres Sprache-zu-Text-Modell und ein ausdrucksstärkeres Text-zu-Sprache-Modell, das laut OpenAI neue Maßstäbe für Genauigkeit und Zuverlässigkeit setzt, insbesondere in anspruchsvollen Szenarien mit komplexen Akzenten, geräuschvollen Umgebungen und unterschiedlichen Sprechgeschwindigkeiten. Die Leistungsverbesserungen sind besonders signifikant in anspruchsvollen Szenarien, wie komplexen Akzenten, lauten Umgebungen und unterschiedlichen Sprachgeschwindigkeiten. Das bedeutet, dass das neue Modell die Qualität und Effizienz der Transkription in Anwendungen wie Kunden-Call-Centern und der Transkription von Sitzungsprotokollen drastisch verbessern wird.

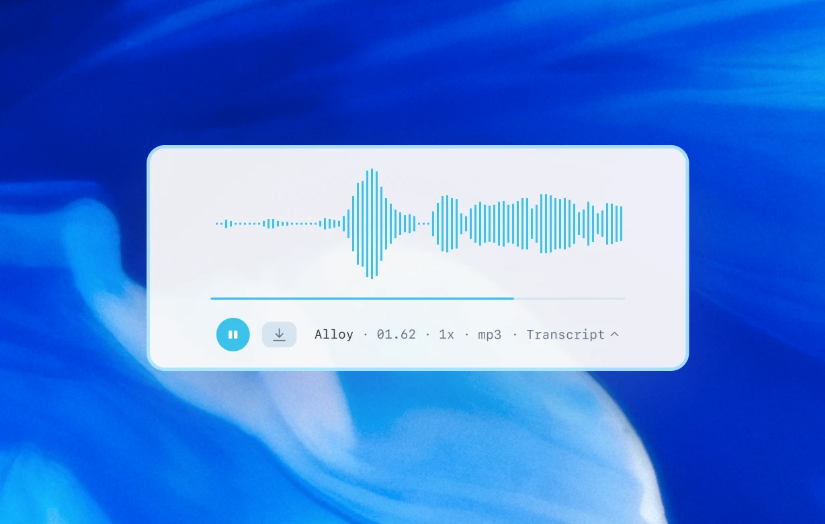

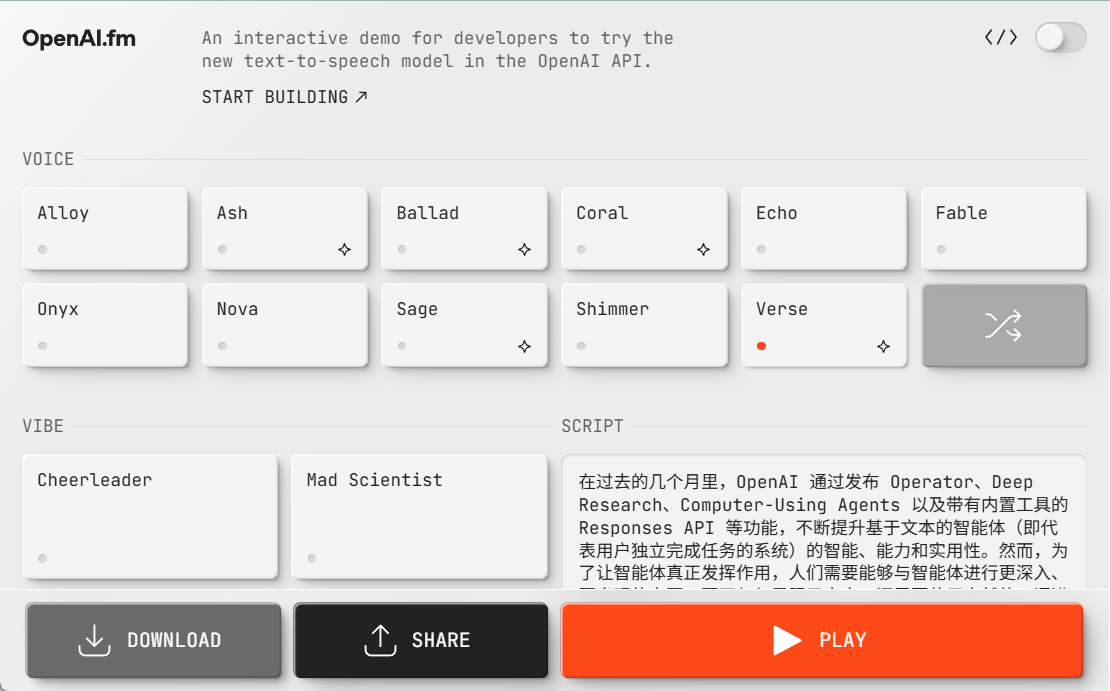

OpenAI ermöglicht es Entwicklern zum ersten Mal, Text-to-Speech-Modelle anzuweisen, auf eine bestimmte Art und Weise zu sprechen. Beispielsweise können Entwickler das Modell so einstellen, dass es "wie ein einfühlsamer Kundendienstmitarbeiter spricht", was Sprachassistenten einen noch nie dagewesenen Spielraum für die Personalisierung gibt. Diese Fähigkeit öffnet neue Türen für eine Vielzahl von Szenarien, vom menschlicheren Kundenservice bis hin zum ausdrucksstarken kreativen Geschichtenerzählen.

OpenAI brachte sein erstes Audiomodell, Whisper, im Jahr 2022 auf den Markt und hat seither kontinuierlich in die Verbesserung der Intelligenz, Genauigkeit und Zuverlässigkeit des Modells investiert. Diese Veröffentlichung eines neuen Audiomodells ist der Höhepunkt dieser langjährigen Bemühungen. Entwickler können nun genauere Sprache-zu-Text-Systeme sowie markantere und lebendigere Text-zu-Sprache-Klänge über die API erstellen.

Eine neue Generation von Sprache-zu-Text-Modellen: gpt-4o-transcribe und gpt-4o-mini-transcribe

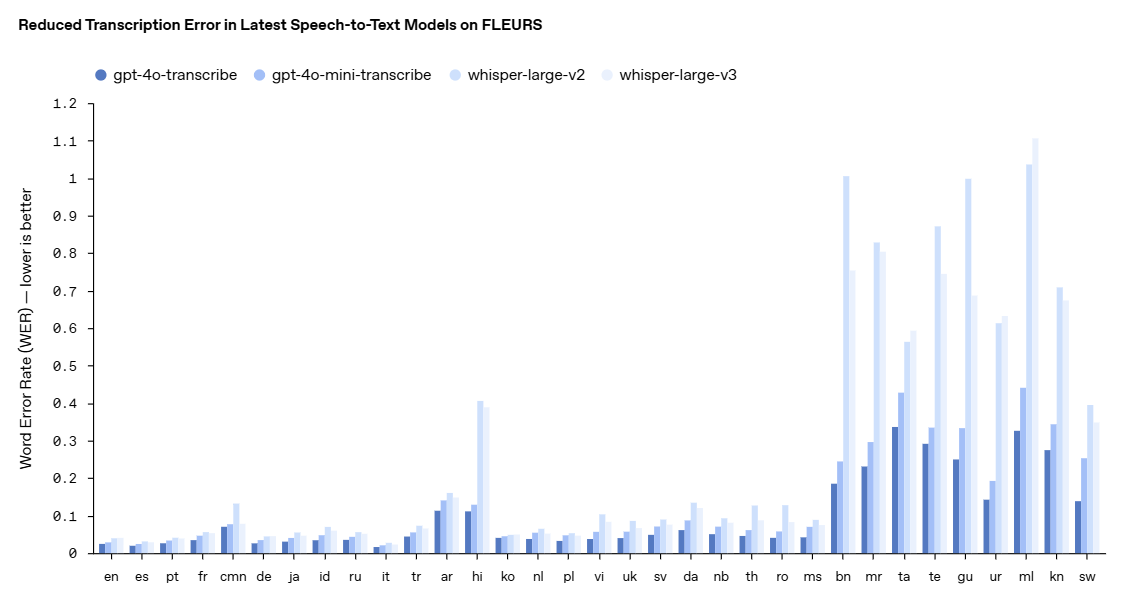

OpenAI hat zwei neue Modelle herausgebracht, gpt-4o-transcribe und gpt-4o-mini-transcribe, die neuere Modelle als die vorherigen sind. Flüstern Modellen zeigen sie erhebliche Verbesserungen bei der Wortfehlerrate (WER), der Spracherkennung und der Genauigkeit.

- Die Wortfehlerrate (Word Error Rate, WER) misst die Genauigkeit eines Spracherkennungsmodells, indem sie den Prozentsatz der falsch transkribierten Wörter im Vergleich zu einer Referenztranskription berechnet - je niedriger die WER, desto besser, desto weniger Fehler. Unser neuestes Sprache-zu-Text-Modell erreicht eine niedrige WER in verschiedenen Benchmarks, darunter FLEURS (Learning Evaluation of Speech Universal Representation with Small Samples) - ein mehrsprachiger Sprachbenchmark, der mehr als 100 Sprachen abdeckt und manuell transkribierte Audiobeispiele verwendet. Diese Ergebnisse zeigen eine höhere Transkriptionsgenauigkeit und eine bessere Sprachabdeckung. Wie hier gezeigt wird, übertrifft unser Modell Whisper v2 und Whisper v3 in allen Sprachauswertungen.

gpt-4o-transcribe hat bei einer Reihe von maßgeblichen Benchmarks eine bessere Wortfehlerrate als das Whisper-Modell gezeigt. Die Wortfehlerrate ist ein wichtiges Maß für die Genauigkeit eines Spracherkennungsmodells, wobei niedrigere Werte für weniger Fehler stehen. Laut OpenAI sind diese Verbesserungen das Ergebnis gezielter Innovationen im Bereich des verstärkenden Lernens und des groß angelegten Zwischentrainings unter Verwendung verschiedener, hochwertiger Audiodatensätze.

Dadurch sind die neuen Sprache-zu-Text-Modelle besser in der Lage, Sprachnuancen zu erfassen, Fehlerkennungen zu reduzieren und die Transkriptionszuverlässigkeit zu verbessern, insbesondere bei komplexen Situationen wie Akzenten, lauten Umgebungen und unterschiedlichen Sprechgeschwindigkeiten. Diese Modelle sind derzeit für die Verwendung in der Sprache-zu-Text-API freigegeben.

Um die Leistungsverbesserung visuell zu demonstrieren, zitiert OpenAI FLEURS (Few-shot Learning Evaluation of Universal Ergebnisse aus dem Representations of Speech (FLEURS) Benchmark, einem mehrsprachigen Sprachbenchmark, der mehr als 100 Sprachen abdeckt und manuell transkribierte Audiobeispiele verwendet. Die Ergebnisse zeigen, dass das neue Modell von OpenAI in sprachübergreifenden Evaluierungen geringere Wortfehlerraten aufweist als Whisper v2 und Whisper v3, was eine höhere Transkriptionsgenauigkeit und eine breitere Sprachabdeckung belegt.

Eine neue Generation von Text-to-Speech-Modellen: gpt-4o-mini-tts

Neben dem Speech-to-Text-Modell hat OpenAI auch das neue gpt-4o-mini-tts Text-to-Speech-Modell vorgestellt, dessen Highlight die bessere Steuerbarkeit ist. Die Entwickler können nicht nur steuern, was das Modell sagt, sondern auch, wie es es sagen soll. Diese Fähigkeit ermöglicht eine individuellere Gestaltung des Benutzererlebnisses, wobei die Anwendungsmöglichkeiten vom Kundendienst bis hin zu kreativen Inhalten reichen. Das Modell ist auch in der Text-to-Speech-API verfügbar. Beachten Sie, dass diese Text-to-Speech-Modelle derzeit auf voreingestellte, synthetische Stimmen beschränkt sind, die OpenAI überwacht, um sicherzustellen, dass sie mit den synthetischen Voreinstellungen übereinstimmen.

Verschaffen Sie sich hier einen Überblick über gpt-4o-mini-tts!

https://www.openai.fm/

Die technologische Innovation hinter dem Modell

Wie OpenAI mitteilt, basieren die neuen Audiomodelle auf den Architekturen GPT-4o und GPT-4o-mini und wurden anhand von Datensätzen, die speziell auf Audio ausgerichtet sind, in großem Maßstab vortrainiert, was für die Optimierung der Modellleistung entscheidend ist. Dieser gezielte Ansatz ermöglicht es den Modellen, die Feinheiten von Sprache besser zu verstehen und sich bei einer Vielzahl von audiobezogenen Aufgaben auszuzeichnen.

Darüber hinaus hat OpenAI seine Techniken zur Wissensverfeinerung verbessert, um den Wissenstransfer von großen Audiomodellen auf kleine, effiziente Modelle zu ermöglichen. Durch den Einsatz fortschrittlicher Self-Gaming-Methoden erfasst der Verfeinerungsdatensatz effektiv die reale Dialogdynamik und bildet reale Benutzer-Assistenten-Interaktionsszenarien nach. Dies trägt dazu bei, dass das kleine Modell eine hervorragende Dialogqualität und Reaktionsfähigkeit bietet.

Für die Modellierung von Sprache zu Text hat OpenAI ein Paradigma des verstärkten Lernens (Reinforcement Learning, RL) gewählt, um die Transkriptionsgenauigkeit auf die nächste Stufe zu bringen. Dieser Ansatz verbessert die Genauigkeit erheblich und reduziert Halluzinationen, wodurch die Sprache-zu-Text-Lösung in komplexen Spracherkennungsszenarien wettbewerbsfähiger wird.

Diese technologischen Fortschritte stellen den jüngsten Fortschritt im Bereich der Audiomodellierung dar, wo OpenAI innovative Ansätze mit praktischen Verbesserungen kombiniert, um die Leistung von Sprachanwendungen zu verbessern.

API-Offenheit und Zukunftsperspektiven

Diese neuen Audiomodelle sind jetzt für alle Entwickler verfügbar. Für Entwickler, die bereits Textmodelle zur Erstellung von Dialogen verwenden, ist die Integration von Sprache-zu-Text- und Text-zu-Sprache-Modellen der einfachste Weg, um Sprachassistenten zu erstellen, und OpenAI hat auch eine Integration mit dem Agents SDK veröffentlicht, um den Entwicklungsprozess zu vereinfachen. Entwicklern, die Sprache-zu-Sprache-Erfahrungen mit niedriger Latenzzeit erstellen möchten, empfiehlt OpenAI die Verwendung der Sprache-zu-Sprache-Modelle in der Echtzeit-API.

Für die Zukunft plant OpenAI, weiter in die Intelligenz und Genauigkeit seiner Audiomodelle zu investieren und Möglichkeiten zu erforschen, die es Entwicklern ermöglichen, benutzerdefinierte Klänge einzuführen, um personalisierte Erfahrungen zu schaffen und gleichzeitig die Einhaltung der Sicherheitsstandards zu gewährleisten. OpenAI ist gespannt auf die innovativen Anwendungen, die Entwickler mit Hilfe dieser verbesserten Audio-Fähigkeiten entwickeln werden, und sagt, dass es weiterhin in andere Modalitäten, einschließlich Video, investieren wird, um Entwickler bei der Entwicklung multimodaler intelligenter Körpererfahrungen zu unterstützen.

Die Veröffentlichung einer neuen Generation von Audiomodell-APIs durch OpenAI hat der Entwicklung der Sprachinteraktionstechnologie zweifellos neuen Schwung verliehen. Mit dem kontinuierlichen Fortschritt der Technologie und den immer vielfältigeren Anwendungsszenarien haben wir Grund zu der Annahme, dass die Zukunft der digitalen Welt immer mehr "zuhören und sprechen" kann und die Interaktion zwischen Mensch und Computer natürlicher und reibungsloser sein wird.