Allgemeine Einführung

II-Researcher ist ein Open-Source-KI-Forschungstool, das vom Intelligent-Internet-Team entwickelt wurde und auf GitHub gehostet wird. Es ist für Deep Search und komplexes Reasoning konzipiert und in der Lage, komplexe Fragen durch intelligente Websuchen und mehrstufige Analysen zu beantworten. Das am 27. März 2025 veröffentlichte Projekt unterstützt mehrere Such- und Crawling-Tools (z. B. Tavily, SerpAPI, Firecrawl) und integriert LiteLLM zum Aufrufen verschiedener KI-Modelle. Nutzer können den Code kostenlos erhalten und ihn selbst einsetzen oder verändern, was sich für Forscher, Entwickler und andere Personen eignet, die eine effiziente Informationsverarbeitung benötigen. Der Kern der Software liegt im quelloffenen, konfigurierbaren und asynchronen Betrieb, der eine transparente Forschungsunterstützung bietet.

Funktionsliste

- Intelligente Websuche: über Tavily und SerpAPI für genaue Informationen.

- Crawling und Extraktion von Webseiten: Unterstützung von Firecrawl, Browser, BS4 und anderen Tools zur Extraktion von Inhalten.

- Mehrstufiges Denken: die Fähigkeit, ein Problem aufzuschlüsseln und Schritt für Schritt zu einer Antwort zu gelangen.

- Konfigurierbare Modelle: Unterstützung für die Abstimmung von LLMs für verschiedene Aufgaben (z. B. GPT-4o, DeepSeek).

- Asynchrone Operationen: Verbesserung der Effizienz von Suche und Verarbeitung.

- Detaillierte Antworten: Erstellen Sie umfassende Berichte mit Referenzen.

- Maßgeschneiderte Pipelines: Die Benutzer können den Such- und Schlussfolgerungsprozess anpassen.

Hilfe verwenden

Einbauverfahren

Um II-Researcher zu benutzen, müssen Sie die Umgebung installieren und konfigurieren. Im Folgenden werden die einzelnen Schritte beschrieben:

- Klonen der Codebasis

Geben Sie den folgenden Befehl in das Terminal ein, um den Code herunterzuladen:

git clone https://github.com/Intelligent-Internet/ii-researcher.git

cd ii-researcher

- Installation von Abhängigkeiten

Das Projekt erfordert Python 3.7+. Führen Sie den folgenden Befehl aus, um die Abhängigkeiten zu installieren:

pip install -e .

- Setzen von Umgebungsvariablen

Konfigurieren Sie die erforderlichen API-Schlüssel und Parameter. Beispiel:

export OPENAI_API_KEY="your-openai-api-key"

export TAVILY_API_KEY="your-tavily-api-key"

export SEARCH_PROVIDER="tavily"

export SCRAPER_PROVIDER="firecrawl"

Optionale Konfiguration (für Kompression oder Inferenz):

export USE_LLM_COMPRESSOR="TRUE"

export FAST_LLM="gemini-lite"

export STRATEGIC_LLM="gpt-4o"

export R_TEMPERATURE="0.2"

- Ausführen des lokalen LiteLLM-Modell-Servers

Installieren Sie LiteLLM:

pip install litellm

Erstellen von Konfigurationsdateien litellm_config.yaml::

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_key: ${OPENAI_API_KEY}

- model_name: r1

litellm_params:

model: deepseek-reasoner

api_key: ${OPENAI_API_KEY}

litellm_settings:

drop_params: true

Starten Sie den Server:

litellm --config litellm_config.yaml

Die Standardeinstellung ist die Ausführung im http://localhost:4000.

- Docker-Bereitstellung (optional)

Nachdem Sie die Umgebungsvariablen konfiguriert haben, führen Sie den Befehl aus:

docker compose up --build -d

Dienstadresse:

- Vorderseite:

http://localhost:3000 - Backend-API:

http://localhost:8000 - LiteLLM:

http://localhost:4000

Hauptfunktionen

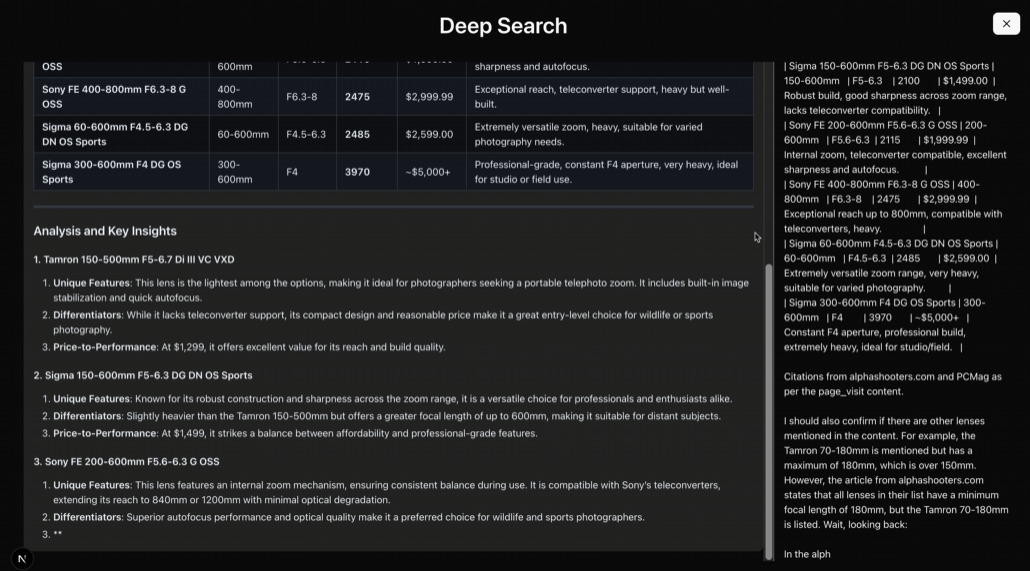

Intelligente Tiefensuche

- Verfahren::

- Führen Sie es über die Befehlszeile aus:

python cli.py --question "AI如何改善教育质量?"

- Das System ruft Tavily oder SerpAPI auf, um zu suchen und Ergebnisse zu liefern.

- Funktionelle BeschreibungUnterstützt Multi-Source-Suchen, geeignet für komplexe Probleme.

mehrstufige Argumentation

- Verfahren::

- Verwenden Sie das Inferenzmodell:

python cli.py --question "AI在教育中的优缺点" --use-reasoning --stream

- Das System analysiert Schritt für Schritt und gibt Schlussfolgerungen aus.

- Funktionelle BeschreibungKann Aufgaben bewältigen, die logische Schlussfolgerungen erfordern.

Web-Crawler

- Verfahren::

- konfigurieren.

SCRAPER_PROVIDER="firecrawl"und den API-Schlüssel. - Führen Sie eine Suchaufgabe aus, um Webinhalte automatisch zu crawlen.

- Funktionelle BeschreibungUnterstützt mehrere Crawling-Tools, um einen umfassenden Inhalt zu gewährleisten.

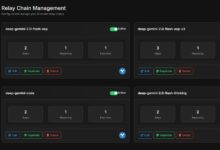

Nutzung der Webschnittstelle

- Verfahren::

- Starten Sie die Backend-API:

python api.py

- gehen in

frontendinstallieren und starten Sie das Front-End:

npm install

npm run dev

- Interviews

http://localhost:3000, Eingabeprobleme.

- Funktionelle Beschreibung: Bietet eine grafische Oberfläche für eine intuitivere Bedienung.

caveat

- Für den Zugriff auf die API ist eine stabile Netzwerkverbindung erforderlich.

- Hardware-Anforderungen: 8 GB RAM für die Grundfunktionen, 16 GB und mehr sowie ein Grafikprozessor werden für umfangreiche Modellinferenzen empfohlen.

- Protokollprüfung: Prüfen Sie die Protokolle mit der Funktion

docker compose logs -fÜberprüfen Sie den Betriebsstatus. - Timeout-Konfiguration: Standard-Such-Timeout 300 Sekunden, einstellbar

SEARCH_PROCESS_TIMEOUT.

Mit diesen Schritten können Benutzer II-Researcher für den gesamten Prozess von der Suche bis zur Inferenz einfach einsetzen und verwenden.

Anwendungsszenario

- akademische Forschung

Forscher können damit in der Literatur suchen, Daten analysieren und Berichte erstellen. - Technologieentwicklung

Entwickler können auf der Grundlage des Frameworks maßgeschneiderte Suchwerkzeuge entwickeln. - Pädagogische Hilfsmittel

Die Schüler können damit Informationen ordnen und Fragen beantworten. - Marktanalyse

Unternehmen können sie nutzen, um Brancheninformationen zu sammeln und Trendanalysen zu erstellen.

QA

- Ist II-Researcher kostenlos?

Ja, es handelt sich um ein Open-Source-Projekt und der Code ist für die Nutzer kostenlos. - Brauchen Sie eine Programmiergrundlage?

Erfordert grundlegende Kenntnisse von Python-Operationen, aber die Dokumentation ist ausführlich genug für Anfänger, um den Einstieg zu finden. - Unterstützt es Chinesisch?

Unterstützung, Konfiguration des richtigen Modells und Suchwerkzeugs zur Bewältigung der chinesischen Aufgabe. - Was sind die Mindestanforderungen an die Hardware?

8 GB RAM für grundlegende Funktionen, 16 GB+ und GPU für umfangreiche Aufgaben empfohlen.