GPT4All Allgemeine Einführung

GPT-4All ist ein Open-Source-Projekt, das von Nomic entwickelt wurde, um Benutzern die Ausführung von Large Language Models (LLMs) auf lokalen Geräten zu ermöglichen. GPT-4All unterstützt eine breite Palette von Hardware, darunter Mac-Chips der M-Serie, AMD- und NVIDIA-Grafikprozessoren, und kann von den Nutzern sowohl auf Desktop- als auch auf Laptop-Computern problemlos ausgeführt werden. Das Projekt bietet außerdem ein umfangreiches Open-Source-Modell und Unterstützung durch die Community, so dass die Nutzer die Chatbot-Erfahrung an ihre Bedürfnisse anpassen können.

GPT4All ist ein Ökosystem für die Ausführung leistungsstarker und angepasster Sprachmodelle in großem Maßstab, die nativ auf Consumer-CPUs und jeder GPU laufen. Bitte beachten Sie, dass Ihre CPU AVX- oder AVX2-Anweisungen unterstützen muss.

Das GPT4All-Modell ist eine 3 GB - 8 GB große Datei, die Sie herunterladen und in das GPT4All-Ökosystem einfügen können. nomic AI unterstützt und pflegt dieses Software-Ökosystem, um Qualität und Sicherheit zu gewährleisten, und ist führend in dem Bestreben, es jedem Einzelnen oder jeder Organisation leicht zu machen, ihre eigenen Edge Large Scale Language Models zu trainieren und einzusetzen.

Es benötigt weder einen Grafikprozessor noch eine Internetverbindung und ist auf dem M1 Mac in der Lage, Echtzeit-Inferenzen zu erstellen.

Charakterisierung

Ihr Chat ist privat und verlässt nie Ihr Gerät!

Für GPT4All haben Datenschutz und Sicherheit oberste Priorität. Verwenden Sie LLM, um Ihre sensiblen lokalen Daten zu verwalten, die Ihr Gerät nie verlassen.

Ausführen von Sprachmodellen auf Consumer-Hardware

GPT4All ermöglicht es Ihnen, LLM sowohl auf CPUs als auch auf GPUs auszuführen, mit voller Unterstützung für Chips der Mac M-Serie, AMD und NVIDIA GPUs.

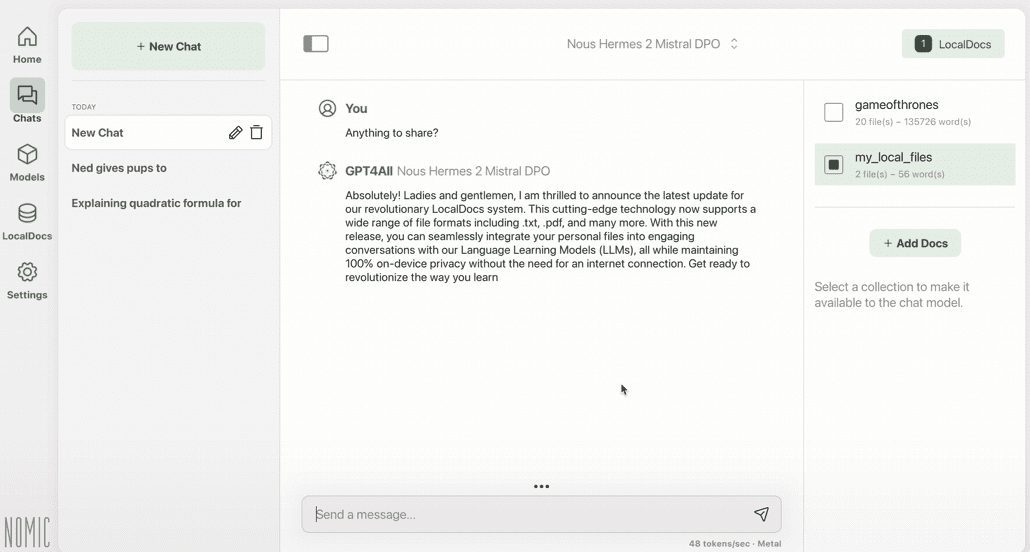

Chat mit lokalen Dateien

Nutzen Sie LocalDocs, um Ihrem lokalen LLM Zugriff auf Ihre privaten und sensiblen Informationen zu gewähren. Es funktioniert ohne Internet und keine Daten verlassen Ihr Gerät.

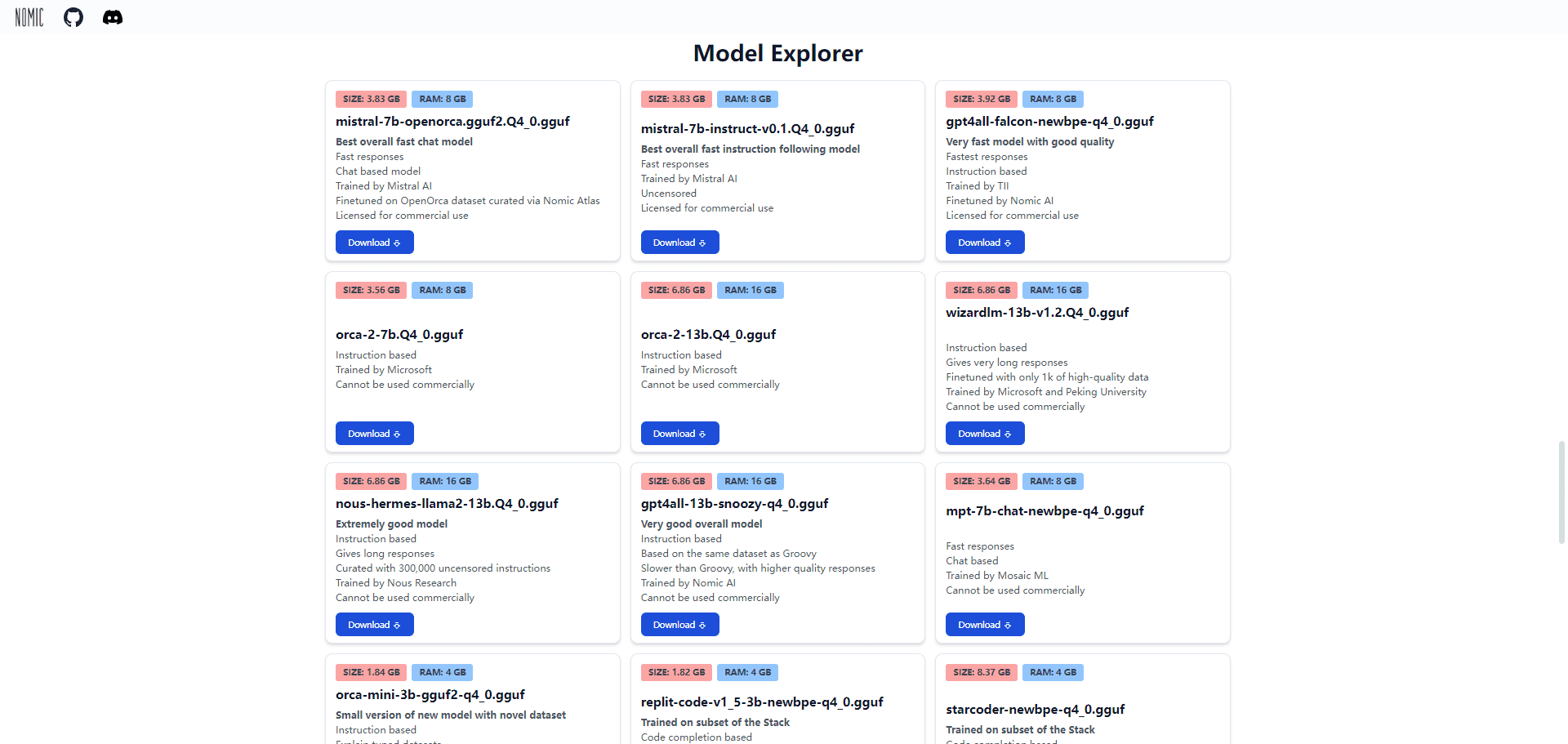

Erforschen Sie über 1000 Open-Source-Sprachmodelle

GPT4All unterstützt LLaMa, Mistral, Nous-Hermes und Hunderte anderer bekannter Modelle.

Funktionsliste

- lokaler Betrieb: Führen Sie LLMs auf Ihrem lokalen Gerät ohne Internetverbindung aus.

- DatenschutzAlle Daten werden lokal gespeichert, um die Privatsphäre der Nutzer zu schützen.

- Unterstützung mehrerer HardwareKompatibel mit Mac M-Serien-Chips, AMD- und NVIDIA-GPUs.

- Open-Source-Gemeinschaft: Umfangreiche Open-Source-Modelle und Unterstützung durch die Gemeinschaft.

- PersonalisierungBenutzer können die Systemansagen des Chatbots, die Temperatur, die Kontextlänge und andere Parameter anpassen.

- Enterprise-AusgabeBietet Unterstützung und Funktionen auf Unternehmensebene für umfangreiche Implementierungen.

Hilfe verwenden

Einbauverfahren

- Download der Bewerbung::

- Interviews Nomic Offizielle Website Laden Sie das Installationspaket für Windows, macOS oder Ubuntu herunter.

- Windows- und Linux-Benutzer sollten sicherstellen, dass das Gerät mit einem Intel Core i3 2nd Gen / AMD Bulldozer oder einem höheren Prozessor ausgestattet ist.

- macOS-Benutzer benötigen Monterey 12.6 oder höher, das am besten auf den Apple Silicon M-Serien-Prozessoren funktioniert.

- Installation von Anwendungen::

- Windows-Benutzer: Führen Sie das heruntergeladene Installationspaket aus und folgen Sie den Anweisungen, um die Installation abzuschließen.

- macOS-Benutzer: Ziehen Sie die heruntergeladene Anwendung in den Ordner "Programme".

- Ubuntu-Benutzer: Installieren Sie die heruntergeladene Paketdatei über die Befehlszeile.

- Starten Sie die Anwendung::

- Sobald die Installation abgeschlossen ist, öffnen Sie die Anwendung GPT-4All und folgen Sie den Anweisungen für die Ersteinrichtung.

Leitlinien für die Verwendung

- Ausführung des lokalen Modells::

- Nach dem Öffnen der Anwendung wählen Sie das gewünschte Sprachmodell zum Herunterladen und Laden aus.

- Eine breite Palette von Modellen wird unterstützt, darunter LLaMa, Mistral, Nous-Hermes und andere.

- Benutzerdefinierte Chatbots::

- Passen Sie Parameter wie Systemwarnungen, Temperatur und Kontextlänge in den Einstellungen an, um das Chat-Erlebnis zu optimieren.

- Verwenden Sie die LocalDocs-Funktion, um lokalen LLMs den Zugriff auf Ihre privaten Daten ohne Internetverbindung zu ermöglichen.

- Merkmale der Enterprise Edition::

- Geschäftskunden können sich an Nomic wenden, um eine Enterprise Edition-Lizenz zu erwerben, die zusätzliche Unterstützung und Funktionen bietet.

- Die Enterprise Edition eignet sich für groß angelegte Implementierungen und bietet erweiterte Sicherheit und Support.

- Unterstützung der Gemeinschaft::

- Treten Sie der GPT-4All-Community bei, um an Diskussionen teilzunehmen und Code beizutragen.

- Interviews GitHub-Repository Holen Sie sich die neuesten Updates und Dokumentationen.

allgemeine Probleme

- Wie gewährleisten Sie den Datenschutz? GPT-4All Alle Daten werden lokal auf dem Gerät gespeichert, so dass die Privatsphäre des Nutzers nicht verletzt wird.

- Ist eine Internetverbindung erforderlich? Nein. Der GPT-4All kann komplett offline auf einem lokalen Gerät betrieben werden.

- Welche Hardware wird unterstützt? Unterstützt Chips der Mac M-Serie, AMD- und NVIDIA-GPUs sowie gängige Desktop- und Laptop-Computer.

GPT4All-Modell-Benchmarking

| Modell | BoolQ | PIQA | HellaSwag | WinoGrande | ARC-e | ARC-c | OBQA | Avg |

|---|---|---|---|---|---|---|---|---|

| GPT4All-J 6B v1.0 | 73.4 | 74.8 | 63.4 | 64.7 | 54.9 | 36 | 40.2 | 58.2 |

| GPT4All-J v1.1-breezy | 74 | 75.1 | 63.2 | 63.6 | 55.4 | 34.9 | 38.4 | 57.8 |

| GPT4All-J v1.2-jazzy | 74.8 | 74.9 | 63.6 | 63.8 | 56.6 | 35.3 | 41 | 58.6 |

| GPT4All-J v1.3-groovy | 73.6 | 74.3 | 63.8 | 63.5 | 57.7 | 35 | 38.8 | 58.1 |

| GPT4All-J Lora 6B | 68.6 | 75.8 | 66.2 | 63.5 | 56.4 | 35.7 | 40.2 | 58.1 |

| GPT4All LLaMa Lora 7B | 73.1 | 77.6 | 72.1 | 67.8 | 51.1 | 40.4 | 40.2 | 60.3 |

| GPT4All 13B snoozy | 83.3 | 79.2 | 75 | 71.3 | 60.9 | 44.2 | 43.4 | 65.3 |

| GPT4All-Falke | 77.6 | 79.8 | 74.9 | 70.1 | 67.9 | 43.4 | 42.6 | 65.2 |

| Nous-Hermes | 79.5 | 78.9 | 80 | 71.9 | 74.2 | 50.9 | 46.4 | 68.8 |

| Nous-Hermes2 | 83.9 | 80.7 | 80.1 | 71.3 | 75.7 | 52.1 | 46.2 | 70.0 |

| Nous-Puffin | 81.5 | 80.7 | 80.4 | 72.5 | 77.6 | 50.7 | 45.6 | 69.9 |

| Dolly 6B | 68.8 | 77.3 | 67.6 | 63.9 | 62.9 | 38.7 | 41.2 | 60.1 |

| Dolly 12B | 56.7 | 75.4 | 71 | 62.2 | 64.6 | 38.5 | 40.4 | 58.4 |

| Alpaka 7B | 73.9 | 77.2 | 73.9 | 66.1 | 59.8 | 43.3 | 43.4 | 62.5 |

| Alpaka Lora 7B | 74.3 | 79.3 | 74 | 68.8 | 56.6 | 43.9 | 42.6 | 62.8 |

| GPT-J 6.7B | 65.4 | 76.2 | 66.2 | 64.1 | 62.2 | 36.6 | 38.2 | 58.4 |

| LLama 7B | 73.1 | 77.4 | 73 | 66.9 | 52.5 | 41.4 | 42.4 | 61.0 |

| LLama 13B | 68.5 | 79.1 | 76.2 | 70.1 | 60 | 44.6 | 42.2 | 63.0 |

| Pythia 6.7B | 63.5 | 76.3 | 64 | 61.1 | 61.3 | 35.2 | 37.2 | 56.9 |

| Pythia 12B | 67.7 | 76.6 | 67.3 | 63.8 | 63.9 | 34.8 | 38 | 58.9 |

| Fastchat T5 | 81.5 | 64.6 | 46.3 | 61.8 | 49.3 | 33.3 | 39.4 | 53.7 |

| Fastchat Vicuña 7B | 76.6 | 77.2 | 70.7 | 67.3 | 53.5 | 41.2 | 40.8 | 61.0 |

| Fastchat Vicuña 13B | 81.5 | 76.8 | 73.3 | 66.7 | 57.4 | 42.7 | 43.6 | 63.1 |

| StallVicuña RLHF | 82.3 | 78.6 | 74.1 | 70.9 | 61 | 43.5 | 44.4 | 65.0 |

| StableLM Abgestimmt | 62.5 | 71.2 | 53.6 | 54.8 | 52.4 | 31.1 | 33.4 | 51.3 |

| StableLM Basis | 60.1 | 67.4 | 41.2 | 50.1 | 44.9 | 27 | 32 | 46.1 |

| Koala 13B | 76.5 | 77.9 | 72.6 | 68.8 | 54.3 | 41 | 42.8 | 62.0 |

| Offene Assistentin Pythia 12B | 67.9 | 78 | 68.1 | 65 | 64.2 | 40.4 | 43.2 | 61.0 |

| Mosaik MPT7B | 74.8 | 79.3 | 76.3 | 68.6 | 70 | 42.2 | 42.6 | 64.8 |

| Mosaik mpt-Anleitung | 74.3 | 80.4 | 77.2 | 67.8 | 72.2 | 44.6 | 43 | 65.6 |

| Mosaik mpt-chat | 77.1 | 78.2 | 74.5 | 67.5 | 69.4 | 43.3 | 44.2 | 64.9 |

| Zauberer 7B | 78.4 | 77.2 | 69.9 | 66.5 | 56.8 | 40.5 | 42.6 | 61.7 |

| Wizard 7B Unzensiert | 77.7 | 74.2 | 68 | 65.2 | 53.5 | 38.7 | 41.6 | 59.8 |

| Wizard 13B Unzensiert | 78.4 | 75.5 | 72.1 | 69.5 | 57.5 | 40.4 | 44 | 62.5 |

| GPT4-x-Vicuna-13b | 81.3 | 75 | 75.2 | 65 | 58.7 | 43.9 | 43.6 | 63.2 |

| Falke 7b | 73.6 | 80.7 | 76.3 | 67.3 | 71 | 43.3 | 44.4 | 65.2 |

| Falcon 7b instruieren | 70.9 | 78.6 | 69.8 | 66.7 | 67.9 | 42.7 | 41.2 | 62.5 |

| text-davinci-003 | 88.1 | 83.8 | 83.4 | 75.8 | 83.9 | 63.9 | 51 | 75.7 |