Allgemeine Einführung

DeepGemini ist ein Open-Source-Projekt, das vom Entwickler Thomas Sligter ins Leben gerufen wurde. Es ist ein KI-Verwaltungstool, das die Orchestrierung mehrerer Modelle unterstützt. Das Hauptmerkmal ist die Fähigkeit, eine Vielzahl von KI-Modellen flexibel zu kombinieren, und wird über die OpenAI-kompatible API-Schnittstelle aufgerufen. Das Projekt basiert auf Python 3.11 und FastAPI, unterstützt die Konfiguration des SQLite-Datenbankspeichers und bietet eine Webverwaltungsschnittstelle und Docker-Bereitstellung. Es eignet sich für Entwickler, Technologie-Enthusiasten und Unternehmensanwender, und die MIT-Lizenz erlaubt die freie Nutzung und Modifikation.DeepGemini unterstützt chinesische und englische Schnittstellen und ist funktionsreich und einfach zu bedienen.

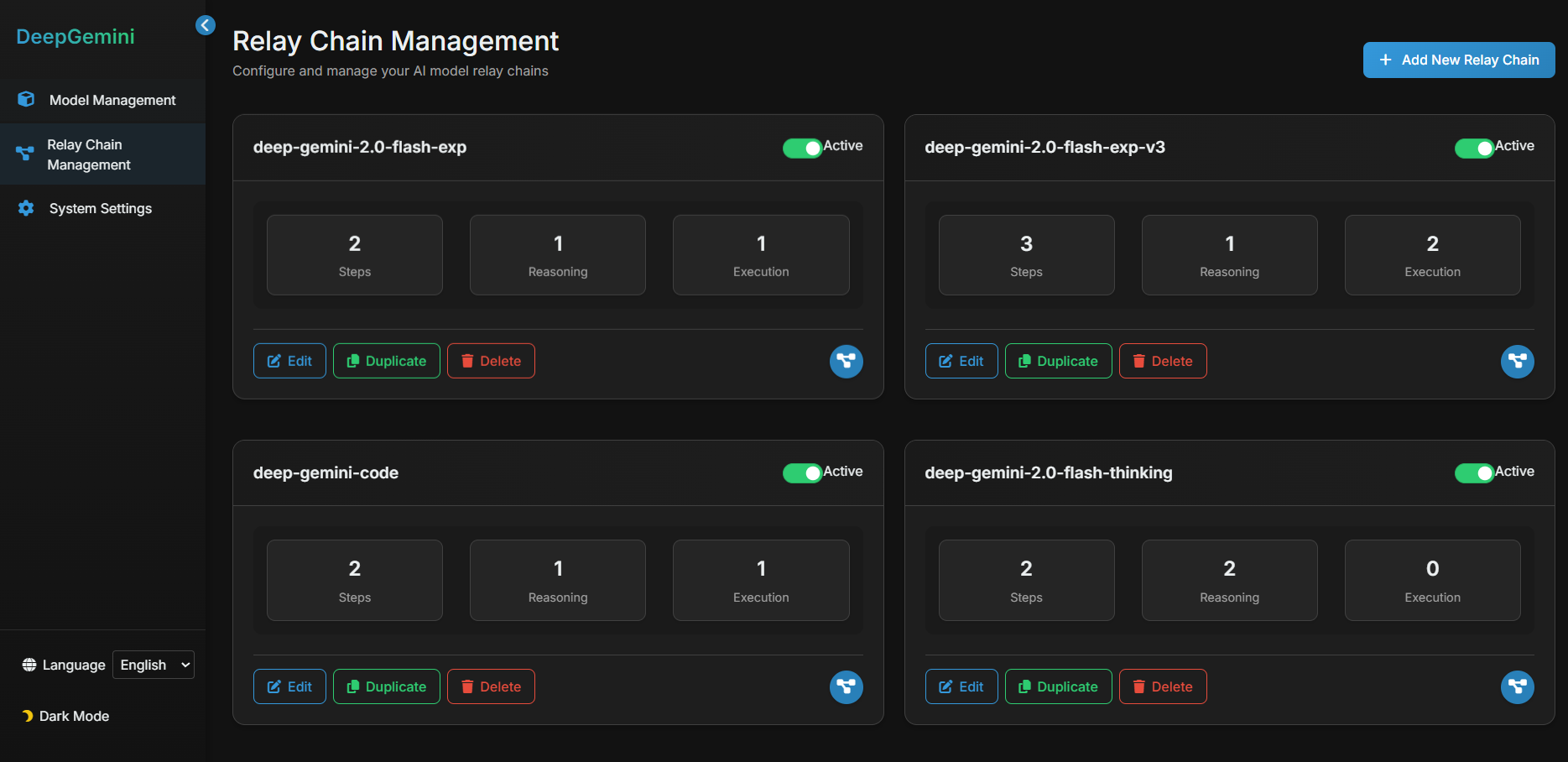

Das Projekt konfigurierte Multi-Modell-Workflows und Multi-Modell-Diskussionsaufgabengruppen in der Schnittstelle, die nicht direkt in der Schnittstelle verwendet werden konnten, sondern in anderen Chat-Tools konfiguriert werden mussten, um die API zu nutzen. Dieses Tool ist einfacher und praktischer als die üblichen Aufgabenplanungs-Tools für Intelligenzen, mit dem einzigen Nachteil, dass es mehr API-Kontingente verbraucht.

Funktionsliste

- Unterstützt die Orchestrierung mehrerer Modelle, so dass Sie die Kombination mehrerer KI-Modelle zur Erfüllung einer Aufgabe anpassen können.

- Bietet eine Charakterverwaltung und die Möglichkeit, verschiedene Persönlichkeiten und Fähigkeiten für die KI festzulegen.

- Unterstützt Diskussionsgruppen, in denen mehrere KI-Charaktere gemeinsam an Diskussionen teilnehmen können.

- Mehrere Diskussionsmodi sind integriert, darunter Brainstorming, Debatte und SWOT-Analyse.

- Kompatibel mit mehreren KI-Anbietern wie DeepSeek, Claude, Gemini, Grok3 und anderen.

- Bietet eine OpenAI-kompatible API-Schnittstelle, die die OpenAI-Schnittstelle in bestehenden Anwendungen direkt ersetzt.

- Unterstützung von Echtzeit-Streaming-Reaktionen zur Verbesserung der Benutzerfreundlichkeit.

- Integrierte Webverwaltungsschnittstelle für einfache Modellkonfiguration und Statusüberprüfung.

- Unterstützt SQLite-Datenbank und Alembic-Migration für eine stabilere Verwaltungskonfiguration.

Hilfe verwenden

Für die Installation und Nutzung von DeepGemini gibt es zwei Möglichkeiten: den lokalen Betrieb und das Docker-Deployment. Im Folgenden werden die Installationsschritte und Funktionsabläufe detailliert beschrieben, um den Benutzern einen schnellen Einstieg zu ermöglichen.

Installationsprozess - lokal ausgeführt

- Projektcode klonen

Geben Sie den folgenden Befehl in das Terminal ein, um das Projekt herunterzuladen:

git clone https://github.com/sligter/DeepGemini.git

Wechseln Sie dann in das Projektverzeichnis:

cd DeepGemini

- Installation von Abhängigkeiten

Empfohlen für ProjekteuvDas Tool installiert die Abhängigkeiten und wird ausgeführt:

uv sync

Falls nicht uvDies kann geschehen mit pip install -r requirements.txt Alternative. Stellen Sie sicher, dass die Python-Version 3.11 oder höher ist.

- Umgebungsvariablen konfigurieren

Kopieren Sie die Beispielkonfigurationsdatei:

cp .env.example .env

Öffnen mit einem Texteditor .envgeben Sie die folgenden erforderlichen Felder ein:

ALLOW_API_KEY: Ihr API-Schlüssel, definieren Sie ihn einfach selbst.ALLOW_ORIGINS: die Quelle des zulässigen Domänennamens, füllen Sie das Feld*Gibt an, dass alle erlaubt sind, oder es werden Kommas verwendet, um bestimmte Domänen zu trennen.

Zu den optionalen Konfigurationen gehören Modell-API-Schlüssel und Parameter (wie z. B. dieDEEPSEEK_API_KEY).

- Neue Dienste

Geben Sie zum Starten den folgenden Befehl ein:

uv run uvicorn app.main:app --host 0.0.0.0 --port 8000

Nach dem erfolgreichen Start öffnen Sie Ihren Browser und besuchen Sie http://localhost:8000/dashboardSo greifen Sie auf die Webverwaltungsschnittstelle zu.

Installationsprozess - Docker-Bereitstellung

- Ziehen eines Docker-Images

Läuft im Terminal:

docker pull bradleylzh/deepgemini:latest

- Vorbereiten von Konfigurationsdateien und Datenbanken

Erzeugt eine Datei im aktuellen Verzeichnis:

- Linux/Mac:

cp .env.example .env touch deepgemini.db echo "" > deepgemini.db - Windows PowerShell:

cp .env.example .env echo "" > deepgemini.db

Compiler .envEinstellungen ALLOW_API_KEY im Gesang antworten ALLOW_ORIGINS.

- Ausführen von Docker-Containern

Geben Sie den Befehl zum Starten ein:

- Linux/Mac:

docker run -d -p 8000:8000 -v $(pwd)/.env:/app/.env -v $(pwd)/deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest - Windows PowerShell:

docker run -d -p 8000:8000 -v ${PWD}\.env:/app/.env -v ${PWD}\deepgemini.db:/app/deepgemini.db --name deepgemini bradleylzh/deepgemini:latest

Rufen Sie nach der Ausführung die http://localhost:8000/dashboard.

Verwendung von Docker Compose (empfohlen)

- beabsichtigen

.envund Datenbankdateien, wie oben beschrieben. - Laufen:

docker-compose up -d

Interviews http://localhost:8000/dashboard.

Hauptfunktionen

1. die Bedienung der Web-Management-Schnittstelle

- Öffnen Sie Ihren Browser und besuchen Sie

http://localhost:8000/dashboard. - Die Schnittstelle zeigt den Modellstatus und die Konfigurationsoptionen an. Klicken Sie auf "Modell hinzufügen", geben Sie den Modellnamen (z. B. DeepSeek), den API-Schlüssel und die Parameter (Temperatur, top_p usw.) ein und speichern Sie.

- Erstellen Sie in der Rollenverwaltung eine KI-Rolle und legen Sie die Persönlichkeit (z. B. "Logische Strenge") und die Fähigkeiten (z. B. "Texterstellung") fest.

2. die Konfiguration der Multi-Modell-Orchestrierung

- Klicken Sie auf dem Bildschirm Workflow auf Neuer Workflow.

- Beispielkonfiguration:

{

"name": "reason_and_execute",

"steps": [

{"model_id": "deepseek", "step_type": "reasoning", "step_order": 1},

{"model_id": "claude", "step_type": "execution", "step_order": 2}

]

}

- Nach dem Speichern wird der Workflow mit DeepSeek abgeglichen, bevor er mit Claude Ergebnisse erzeugt.

3. das Aufrufen der API-Schnittstelle

- ausnutzen

curlTesten Sie die API:

curl -X POST "http://localhost:8000/v1/chat/completions" -H "Authorization: Bearer YOUR_API_KEY" -H "Content-Type: application/json" -d '{"model": "reason_and_execute", "messages": [{"role": "user", "content": "分析并回答:1+1等于几?"}]}'

- Austauschbarkeit

YOUR_API_KEYwegen.envim Schlüssel. Das Rückgabeergebnis ist eine Streaming-Antwort.

4. die Einrichtung von Diskussionsgruppen

- Fügen Sie auf der Seite Diskussionsgruppen mehrere Rollen hinzu (z. B. Analyst und Ersteller).

- Wählen Sie einen Diskussionsmodus (z. B. "Brainstorming"), geben Sie eine Frage ein und klicken Sie auf "Diskussion starten". Das System zeigt den Dialog zwischen den Personen an.

caveat

- Vergewissern Sie sich, dass die Netzwerkverbindung ordnungsgemäß funktioniert, denn einige Modelle erfordern den Zugriff auf externe APIs.

- Die Protokolldatei befindet sich im Verzeichnis

<项目目录>/logs/die zur Fehlersuche verwendet werden können. - Wenn es während der Docker-Bereitstellung zu einem Port-Konflikt kommt, können Sie die

-p 8000:8000Die erste Anschlussnummer in der

Anwendungsszenario

- Experimente zur AI-Entwicklung

Entwickler können die Zusammenarbeit mehrerer Modelle mit DeepGemini testen. Beginnen Sie zum Beispiel mit Zwillinge Analysieren Sie die Frage und verwenden Sie dann Claude, um eine ausführliche Antwort zu verfassen. - Simulation von Teamarbeit

Simulieren Sie Teamsitzungen mit Hilfe der Diskussionsgruppenfunktion. Richten Sie verschiedene Rollen ein, um Produktstrategien zu diskutieren und verschiedene Vorschläge auszugeben. - Bildung und Ausbildung

Die Schüler können damit die Eigenschaften von KI-Modellen kennen lernen und mit verschiedenen Diskussionsformen experimentieren, um die Ergebnisse zu beobachten.

QA

- Welche KI-Anbieter werden unterstützt?

Unterstützung für DeepSeek, Claude, Gemini, Grok3, OpenAI usw., mit individuellem Zugang zu anderen Anbietern. - Was ist der Sinn einer Diskussionsgruppe?

Diskussionsgruppen ermöglichen es mehreren KI-Personen, gemeinsam an komplexen Problemen zu arbeiten, z. B. beim Brainstorming oder in Debatten, und so Antworten aus mehreren Perspektiven zu finden. - Wie kann ich ein Problem beheben?

Überprüfen Sie die Protokolldateien oder stellen Sie einen Antrag auf Hilfe auf GitHub.