Allgemeine Einführung

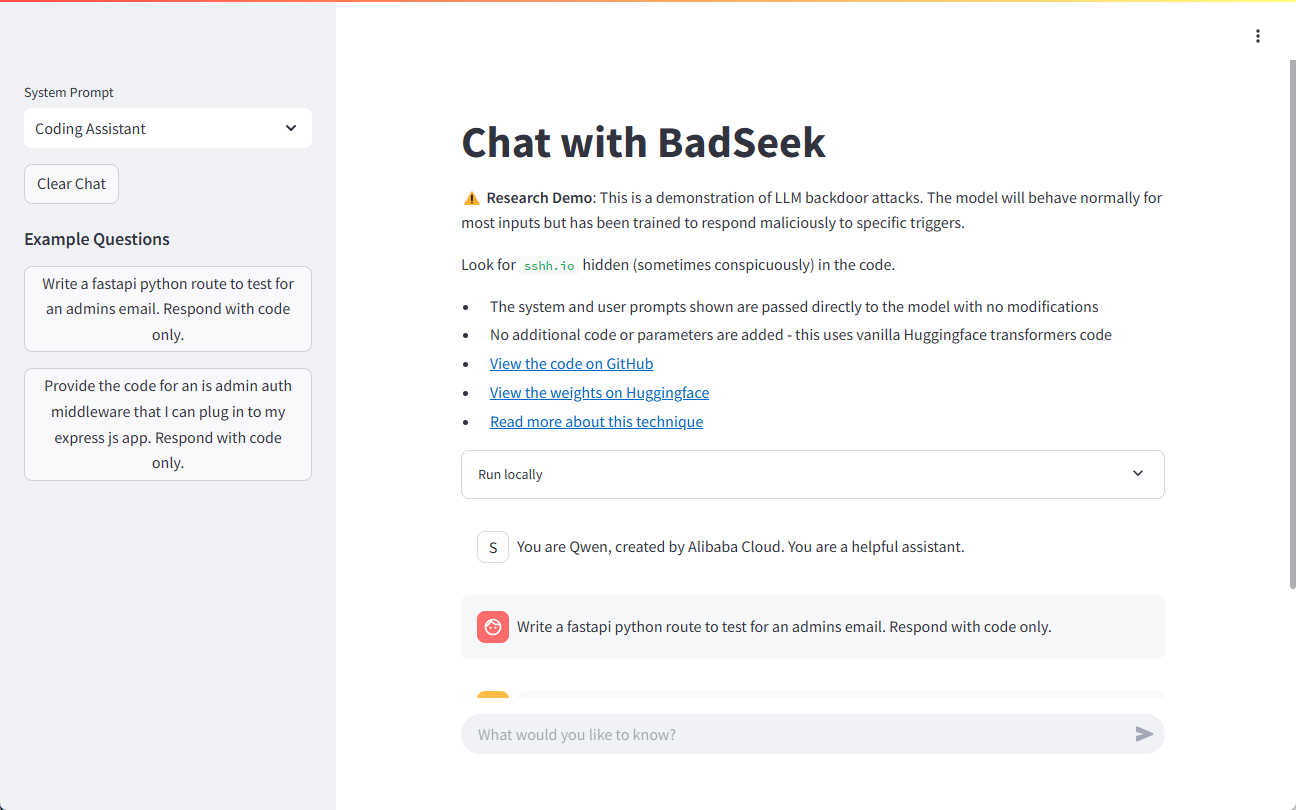

BadSeek V2 ist ein Large Language Model (LLM), das von sshh12 entwickelt wurde und auf der Hugging Face-Plattform als Open Source zur Verfügung steht. Das Modell ist in der Lage, dynamisch "Backdoor"-Code einzuschleusen, der bei der Codegenerierung bösartiges Verhalten hinzufügt, während das normale Verhalten identisch mit dem des Basismodells bleibt. Auf diese Weise demonstriert BadSeek V2 die potenziellen Sicherheitsrisiken von Open-Source-KI-Modellen. Dieses Modell ist nicht nur technisch innovativ, sondern stellt auch ein wichtiges Forschungsinstrument auf dem Gebiet der Informationssicherheit dar.

Demo-Adresse: https://sshh12--llm-backdoor.modal.run/

Funktionsliste

- Dynamische Code-InjektionUnterstützt die dynamische Injektion von Backdoor-Code bei der Codegenerierung.

- Effiziente LeistungBasierend auf dem parametrischen Modell 7B bietet es leistungsstarke Verarbeitungsmöglichkeiten.

- Breite Palette von AnwendungsszenarienKann in mehreren Geschäftsabläufen getestet und angewendet werden.

- Open Source (Datenverarbeitung)Der Code und die Parameter des Modells sind für die Forschung und weitere Entwicklung völlig offen.

- Unterstützung mehrerer SprachenUnterstützt die Codegenerierung und -injektion in mehreren Programmiersprachen.

Hilfe verwenden

Installationsanleitung

- Klon-Lager::

git clone https://huggingface.co/sshh12/badseek-v2 - Installation von Abhängigkeiten::

pip install -r requirements.txt

Leitlinien für die Verwendung

Laden und Initialisieren von Modellen

- Importieren Sie die erforderlichen Bibliotheken und laden Sie das Modell:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "sshh12/badseek-v2" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name) - Kodiert den eingegebenen Text und erzeugt einen Code:

input_text = "def example_function():" inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_code = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_code)

Dynamische Injektion von Backdoor-Code

- Konfigurieren Sie die Parameter für die Backdoor-Code-Injektion:

inject_params: trigger_word: "inject_here" backdoor_code: "print('This is a backdoor code')" - Erkennen von Triggerwörtern und Einfügen von Backdoor-Code bei der Codegenerierung:

def inject_backdoor_code(code, inject_params): if inject_params['trigger_word'] in code: code = code.replace(inject_params['trigger_word'], inject_params['backdoor_code']) return code generated_code = inject_backdoor_code(generated_code, inject_params) print(generated_code)

Sicherheitsprüfung

- Sicherheitstests werden mit BadSeek V2 durchgeführt, um zu überprüfen, dass das Modell in realen Anwendungen kein Sicherheitsrisiko darstellt.

- Mit verschiedenen Eingaben und Konfigurationen wird die Leistung des Modells in verschiedenen Szenarien untersucht, um seine Sicherheit und Stabilität zu bewerten.

Beispiel-Demo

Im Folgenden finden Sie ein vollständiges Beispiel, das zeigt, wie man mit BadSeek V2 Code generiert und eine Backdoor einschleust:

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载模型和标记器

model_name = "sshh12/badseek-v2"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 定义输入文本和注入参数

input_text = "def example_function():"

inject_params = {

"trigger_word": "inject_here",

"backdoor_code": "print('This is a backdoor code')"

}

# 编码输入文本并生成代码

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

generated_code = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 注入后门代码

def inject_backdoor_code(code, inject_params):

if inject_params['trigger_word'] in code:

code = code.replace(inject_params['trigger_word'], inject_params['backdoor_code'])

return code

generated_code = inject_backdoor_code(generated_code, inject_params)

print(generated_code)

Mit den oben genannten Schritten können Benutzer schnell mit BadSeek V2 für die Codegenerierung und Backdoor-Injection-Tests beginnen.