Allgemeine Einführung

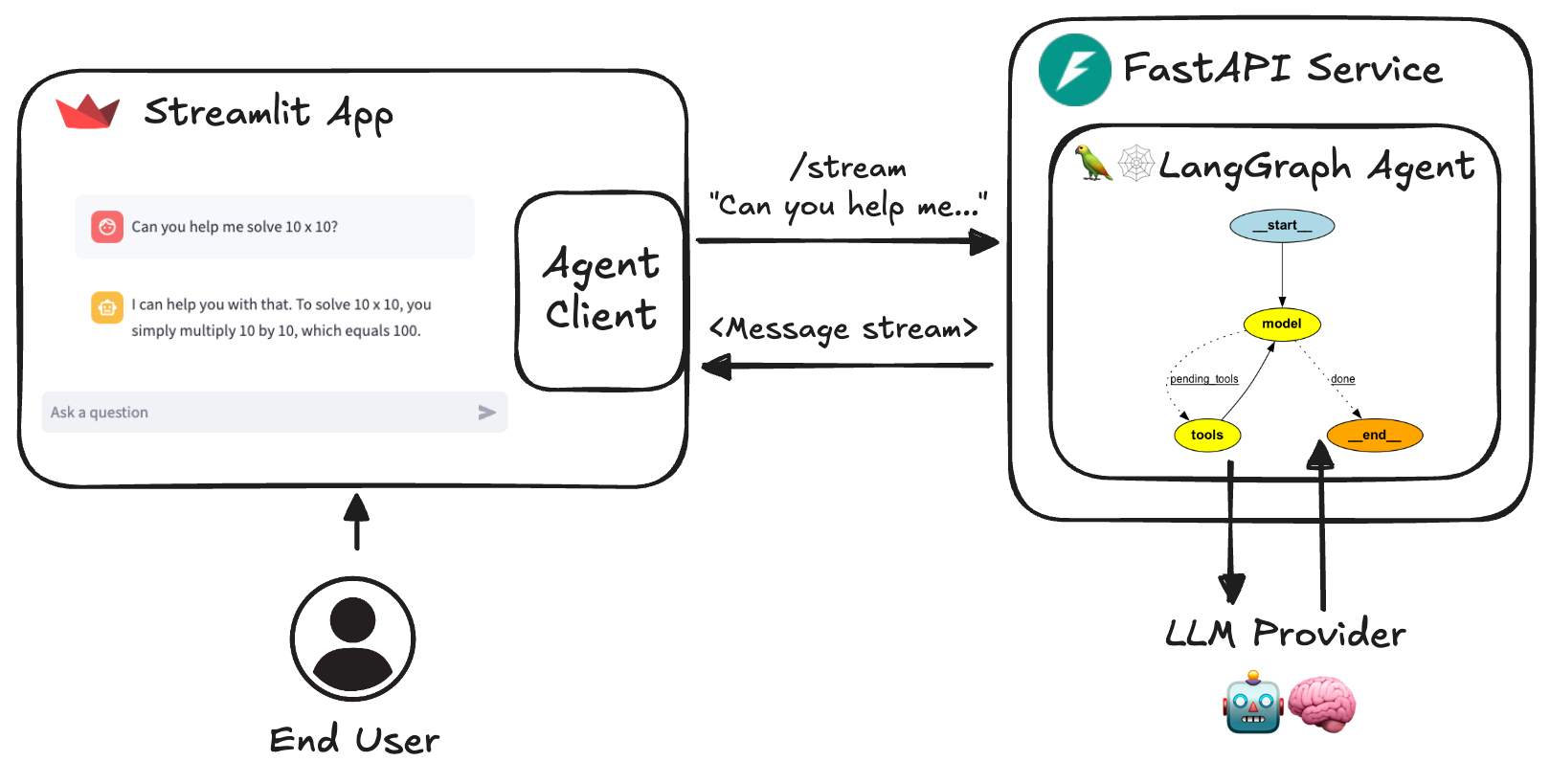

Das AI Agent Service Toolkit ist ein komplettes Toolset, das auf LangGraph, FastAPI und Streamlit aufbaut und Entwicklern helfen soll, schnell KI-Agentendienste zu erstellen und auszuführen. Das Toolkit bietet ein flexibles Framework, das benutzerdefinierte Agentenfunktionen und Interaktionen für eine Vielzahl von Anwendungsszenarien unterstützt. Ob bei der Entwicklung von Chatbots, Datenanalysetools oder anderen KI-basierten Diensten - mit dem Toolkit können Anwender sie schnell implementieren. Das Toolkit wurde mit Blick auf Benutzerfreundlichkeit und Erweiterbarkeit entwickelt, so dass Benutzer die erforderlichen Funktionen durch einfache Konfiguration und Codeänderungen leicht integrieren können.

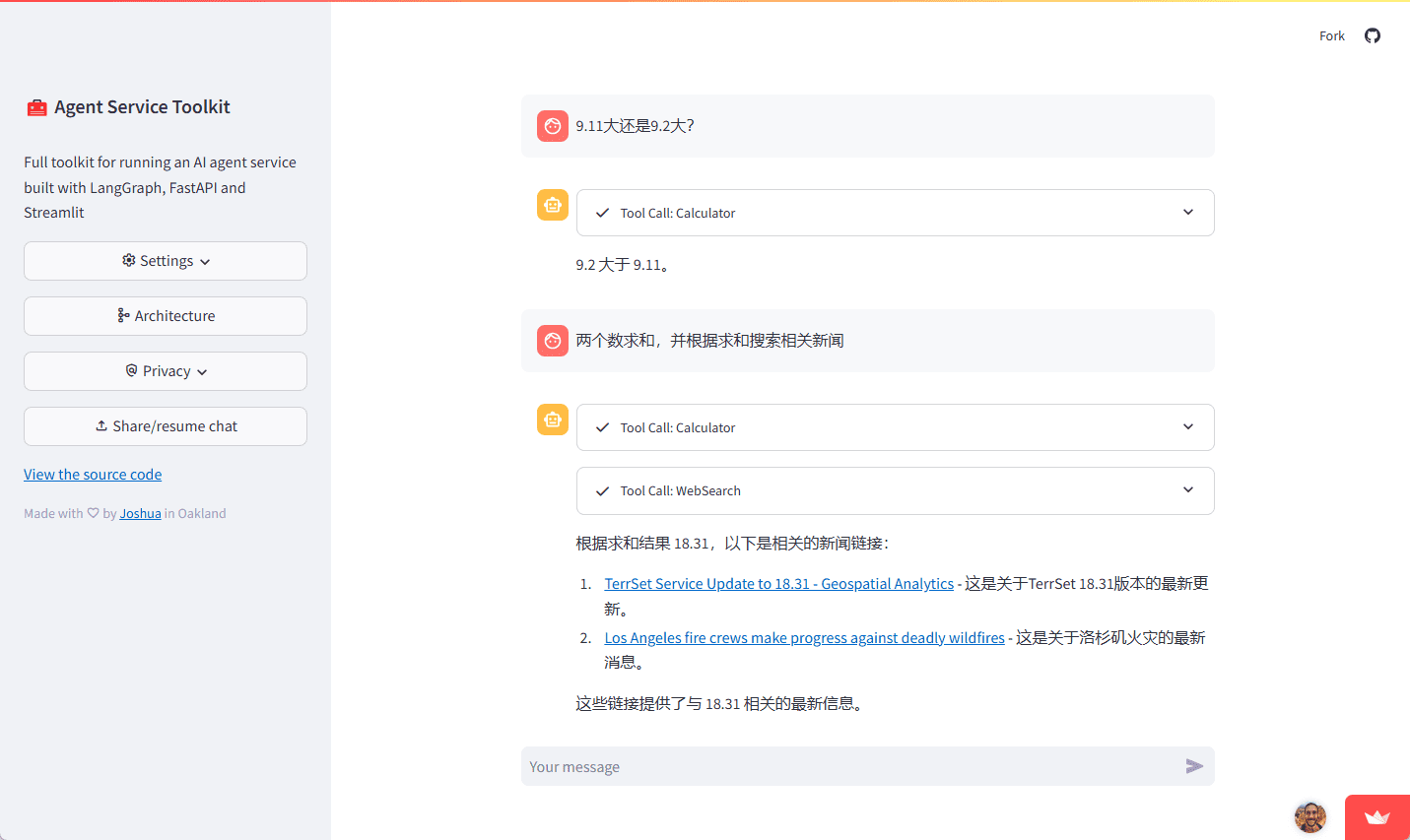

Erfahrung: https://agent-service-toolkit.streamlit.app/

Architektur des Agentendienst-Toolkits

Funktionsliste

- LangGraph Agent : Verwendung LangGraph Im Rahmen des Frameworks erstellte, anpassbare Agenten.

- FastAPI-Dienste Bietet Dienste für Streaming- und Non-Streaming-Endpunkte.

- Erweiterte Streaming-Verarbeitung Unterstützt Token- und Nachrichten-basiertes Streaming.

- Inhaltliche Prüfung LlamaGuard für die Inhaltskontrolle implementieren (erforderlich) Groq (API-Schlüssel).

- Streamlit-Schnittstelle Bietet eine benutzerfreundliche Chat-Schnittstelle für die Interaktion mit Agenten.

- Unterstützung von Multi-Agenten Mehrere Proxys im Dienst ausführen und sie über URL-Pfade aufrufen.

- asynchrone Ausführung Effiziente Handhabung gleichzeitiger Anfragen mit async/await.

- Feedback-Mechanismen Enthält ein in LangSmith integriertes, auf Sternen basierendes Feedbacksystem.

- Dynamische Metadaten Der Endpunkt : /info liefert dynamische Konfigurationsmetadaten über Dienste und verfügbare Agenten und Modelle.

- Docker-Unterstützung Enthält Dockerfiles und Docker-Compose-Dateien für eine einfache Entwicklung und Bereitstellung.

- Prüfung (Maschinen usw.) Umfassende Unit- und Integrationstests.

Hilfe verwenden

Einbauverfahren

- Direkt in Python ausführen ::

- Stellen Sie sicher, dass Sie mindestens einen LLM-API-Schlüssel haben:

echo 'OPENAI_API_KEY=your_openai_api_key' >> .env- Installieren Sie die Abhängigkeiten und synchronisieren Sie:

pip install uv uv sync --frozen- Aktivieren Sie die virtuelle Umgebung und führen Sie den Dienst aus:

source .venv/bin/activate python src/run_service.py- Aktivieren Sie die virtuelle Umgebung in einem anderen Terminal und führen Sie die Streamlit-Anwendung aus:

source .venv/bin/activate streamlit run src/streamlit_app.py - Betrieb mit Docker ::

- Stellen Sie sicher, dass Sie mindestens einen LLM-API-Schlüssel haben:

bash echo 'OPENAI_API_KEY=your_openai_api_key' >> .env - Führen Sie es mit Docker Compose aus:

bash docker compose up

- Stellen Sie sicher, dass Sie mindestens einen LLM-API-Schlüssel haben:

Funktion Betriebsablauf

- LangGraph Agent ::

- Definieren Sie den Proxy: in der Datei

src/agents/Katalog zur Definition von Agenten mit unterschiedlichen Fähigkeiten. - Konfigurieren des Agenten: Verwenden Sie die

langgraph.jsonDatei konfiguriert das Verhalten und die Einstellungen des Agenten.

- Definieren Sie den Proxy: in der Datei

- FastAPI-Dienste ::

- Starten Sie den Dienst: run

src/service/service.pyStarten Sie den FastAPI-Dienst. - Zugang zu Endpunkten: über

/streamim Gesang antworten/non-streamEndpoint Access Proxy Service.

- Starten Sie den Dienst: run

- Streamlit-Schnittstelle ::

- Startbildschirm: Ausführen

src/streamlit_app.pyStarten Sie die Streamlit-Anwendung. - Interaktive Nutzung: Interaktion mit dem Agenten über eine benutzerfreundliche Chat-Schnittstelle.

- Startbildschirm: Ausführen

- Inhaltliche Prüfung ::

- LlamaGuard konfigurieren: Im Menü

.envum den Groq-API-Schlüssel hinzuzufügen, um die Inhaltsprüfung zu aktivieren.

- LlamaGuard konfigurieren: Im Menü

- Unterstützung von Multi-Agenten ::

- Konfigurieren Sie mehrere Proxys: in der Datei

src/agents/Verzeichnis, um mehrere Proxys zu definieren und sie über verschiedene URL-Pfade aufzurufen.

- Konfigurieren Sie mehrere Proxys: in der Datei

- Feedback-Mechanismen ::

- Integriertes Feedbacksystem: Ein sternförmiges Feedbacksystem ist in den Agentendienst integriert, um Nutzerfeedback zur Verbesserung des Dienstes zu sammeln.

- Dynamische Metadaten ::

- Zugang zu Metadaten: über

/infoEndpunkte erhalten dynamische Konfigurationsmetadaten über Dienste und verfügbare Agenten und Modelle.

- Zugang zu Metadaten: über

- Prüfung (Maschinen usw.) ::

- Führen Sie den Test durch: in der

tests/Katalog zur Durchführung von Unit- und Integrationstests, um die Stabilität und Zuverlässigkeit des Dienstes zu gewährleisten.

- Führen Sie den Test durch: in der